Java 线程池笔记

从执行器到线程池(from executor interface to thread pool implementation)

Pooling is the grouping together of resources (assets, equipment, personnel, effort, etc.) for the purposes of maximizing advantage or minimizing risk to the users. The term is used in finance, computing and equipment management.

——wikipedia“池化”思想不仅仅能应用在计算机领域,在金融、设备、人员管理、工作管理等领域也有相关的应用。

在计算机领域中的表现为:统一管理IT资源,包括服务器、存储、和网络资源等等。通过共享资源,使用户在低投入中获益。除去线程池,还有其他比较典型的几种使用策略包括:

内存池(Memory Pooling):预先申请内存,提升申请内存速度,减少内存碎片。 连接池(Connection

Pooling):预先申请数据库连接,提升申请连接的速度,降低系统的开销。 实例池(Object

Pooling):循环使用对象,减少资源在初始化和释放时的昂贵损耗。

本文模式总览

本文从源码和实践两个维度剖析 Java 线程池,提炼出以下可迁移的设计模式和工程实践模式。读者可先浏览此表建立全局认知,再深入各章节:

| 类别 | 模式 | 章节 |

|---|---|---|

| 工程实践 | 线程池选型三板斧 | ThreadPoolExecutor 监控与调优实践 |

| 有界队列+明确拒绝策略 | 任务缓冲:阻塞队列 | |

| ThreadFactory 命名 | ThreadPoolExecutor 监控与调优实践 | |

| 池隔离原则 | ThreadPoolExecutor 监控与调优实践 | |

| Spring @Scheduled 单线程陷阱 | Spring @Scheduled 的默认陷阱 | |

| 调度策略 | Rate vs Delay | ScheduledThreadPoolExecutor 详解 |

| 周期任务防御性编程 | ScheduledThreadPoolExecutor 详解 | |

| cancel 后清理队列 | ScheduledThreadPoolExecutor 详解 | |

| 并发设计 | CAS + 锁分层 | mainLock:线程池的全局互斥锁 |

| Worker 不可重入锁 | Worker 类定义与锁状态 | |

| FutureTask 状态机 | FutureTask:任务包装的标准实现 | |

| 异步编排 | execute vs submit | 任务提交入口:submit 与 execute |

| CompletableFuture 异步编排 | CompletableFuture | |

| CompletableFuture 完成保证 | 完成保证原则 | |

| shutdown 优雅关闭 | 尝试关闭 ThreadPoolExecutor | |

| 未来方向 | 虚拟线程使用原则 | 虚拟线程的使用原则 |

Doug Lea 对线程池的期待有:

- 改善性能。

- 有界地利用资源(多次强调 bounds)。

- 提供统计。

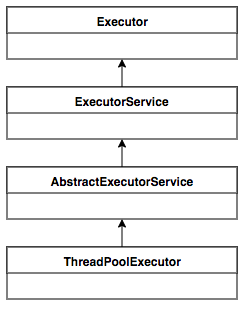

执行器继承体系

“设计良好的API应该简单、一致、可扩展。”

我们将任务交给执行器,于是有了执行器(executor);我们将执行器内部用 FutureTask 包装任务,于是有了同步转异步,异步转同步的设计,和多种 API(ExecutorService 和 AbstractExecutorService);我们将执行器用线程池来实现,于是我们得到了线程池执行器(ThreadPoolExecutor)。

- Executor:只定义"执行"契约

- ExecutorService:定义生命周期、 多种任务类型(Runnable/Callable)、批量任务契约

这两层都是契约层,方法之间没有明确关联。

- AbstractExecutorService:只提供算法模板-这一层提供了其他执行方法在 execute 之上的实现,把 api 关联起来。但是唯独 execute 的实现空余了。也没有提供工作线程和拥塞队列的实现。

- ThreadPoolExecutor:只实现 execute,并且围绕它搭建了一整套线程池的参考实现:Worker + 状态机 + 队列 + 拒绝策略 + 线程工厂。

- FutureTask:只负责任务包装。但是它的两个父接口让它成为连接了

execute(Runnable)和Future.get()两个世界的桥梁。

classDiagram

direction TB

%% ========== 设计原则注释 ==========

note for ThreadPoolExecutor "普通任务:生产者-消费者模式"

note for ForkJoinPool "并行计算:工作窃取模式"

%% ========== 契约层 ==========

class Executor {

<<interface>>

+execute(Runnable command) void

note: "契约层:只定义'执行'契约"

}

class ExecutorService {

<<interface>>

+submit(Callable~T~ task) Future~T~

+invokeAll(Collection~Callable~T~~ tasks) List~Future~T~~

+invokeAny(Collection~Callable~T~~ tasks) T

+shutdown() void

+awaitTermination(long timeout, TimeUnit unit) boolean

note: "契约层:生命周期+批量任务"

}

class ScheduledExecutorService {

<<interface>>

+schedule(Runnable command, long delay, TimeUnit unit) ScheduledFuture~?~

+schedule(Callable~V~ callable, long delay, TimeUnit unit) ScheduledFuture~V~

+scheduleAtFixedRate(Runnable command, long initialDelay, long period, TimeUnit unit) ScheduledFuture~?~

+scheduleWithFixedDelay(Runnable command, long initialDelay, long delay, TimeUnit unit) ScheduledFuture~?~

note: "契约层:延迟和周期任务"

}

class Future {

<<interface>>

+cancel(boolean mayInterruptIfRunning) boolean

+isCancelled() boolean

+isDone() boolean

+get() V

+get(long timeout, TimeUnit unit) V

}

class RunnableFuture {

<<interface>>

note: "标记接口:Runnable+Future"

}

class ScheduledFuture {

<<interface>>

}

class RunnableScheduledFuture {

<<interface>>

+isPeriodic() boolean

}

class RejectedExecutionHandler {

<<interface>>

+rejectedExecution(Runnable r, ThreadPoolExecutor executor) void

note: "策略模式:饱和处理"

}

class ThreadFactory {

<<interface>>

+newThread(Runnable r) Thread

}

%% ========== 模板层 ==========

class AbstractExecutorService {

<<abstract>>

#newTaskFor(Callable~T~ callable) RunnableFuture~T~

#newTaskFor(Runnable runnable, V value) RunnableFuture~V~

+submit(Callable~T~ task) Future~T~

+submit(Runnable task, V result) Future~V~

+invokeAll(Collection~Callable~T~~ tasks) List~Future~T~~

+invokeAny(Collection~Callable~T~~ tasks) T

note: "模板层:默认实现"

}

%% ========== 实现层 - ThreadPoolExecutor ==========

class ThreadPoolExecutor {

-corePoolSize: int

-maximumPoolSize: int

-keepAliveTime: long

-workQueue: BlockingQueue~Runnable~

-workers: HashSet~Worker~

-ctl: AtomicInteger

-threadFactory: ThreadFactory

-handler: RejectedExecutionHandler

+execute(Runnable command) void

+shutdown() void

+shutdownNow() List~Runnable~

+beforeExecute(Thread t, Runnable r) void

+afterExecute(Runnable r, Throwable t) void

#terminated() void

note: "ctl:高3位状态+低29位线程数"

}

class Worker {

-thread: Thread

-firstTask: Runnable

-completedTasks: long

+run() void

+lock() void

+unlock() void

+isLocked() boolean

+tryLock() boolean

note: "继承AQS的不可重入锁"

}

class FutureTask {

-callable: Callable~V~

-outcome: Object

-state: int

-runner: Thread

-waiters: WaitNode

+run() void

+get() V

+get(long timeout, TimeUnit unit) V

+cancel(boolean mayInterruptIfRunning) boolean

+isCancelled() boolean

+isDone() boolean

-set(V v) boolean

-setException(Throwable t) void

-report(int s) V

note: "状态机:NEW→COMPLETING→NORMAL/EXCEPTIONAL"

}

class AbortPolicy {

+rejectedExecution(Runnable r, ThreadPoolExecutor executor) void

}

class CallerRunsPolicy {

+rejectedExecution(Runnable r, ThreadPoolExecutor executor) void

}

class DiscardPolicy {

+rejectedExecution(Runnable r, ThreadPoolExecutor executor) void

}

class DiscardOldestPolicy {

+rejectedExecution(Runnable r, ThreadPoolExecutor executor) void

}

%% ========== 实现层 - ScheduledThreadPoolExecutor ==========

class ScheduledThreadPoolExecutor {

-delayedWorkQueue: DelayedWorkQueue

-removeOnCancel: boolean

+schedule(Runnable command, long delay, TimeUnit unit) ScheduledFuture~?~

+schedule(Callable~V~ callable, long delay, TimeUnit unit) ScheduledFuture~V~

+scheduleAtFixedRate(Runnable command, long initialDelay, long period, TimeUnit unit) ScheduledFuture~?~

+scheduleWithFixedDelay(Runnable command, long initialDelay, long delay, TimeUnit unit) ScheduledFuture~?~

+decorateTask(Runnable runnable, RunnableScheduledFuture~?~ task) RunnableScheduledFuture~?~

+decorateTask(Callable~V~ callable, RunnableScheduledFuture~V~ task) RunnableScheduledFuture~V~

+setRemoveOnCancelPolicy(boolean removeOnCancel) void

note: "基于DelayQueue的延迟调度"

}

class ScheduledFutureTask {

-time: long

-sequenceNumber: long

-period: long

-outerTask: RunnableScheduledFuture~V~

+run() void

+runAndReset() boolean

+isPeriodic() boolean

+getDelay(TimeUnit unit) long

+compareTo(Delayed other) int

-setNextRunTime() void

-reExecutePeriodic(RunnableScheduledFuture~?~ task) void

note: "period>0:固定频率;period<0:固定延迟"

}

class DelayedWorkQueue {

-queue: RunnableScheduledFuture~?~[]

-size: int

-leader: Thread

-lock: ReentrantLock

-available: Condition

+offer(RunnableScheduledFuture~?~ e) boolean

+take() RunnableScheduledFuture~?~

+poll() RunnableScheduledFuture~?~

+poll(long timeout, TimeUnit unit) RunnableScheduledFuture~?~

+peek() RunnableScheduledFuture~?~

+size() int

+clear() void

note: "堆实现+leader机制"

}

class Delayed {

<<interface>>

+getDelay(TimeUnit unit) long

}

%% ========== 实现层 - ForkJoinPool ==========

class ForkJoinPool {

-parallelism: int

-workQueues: WorkQueue[]

+execute(ForkJoinTask~?~ task) void

+submit(ForkJoinTask~T~ task) ForkJoinTask~T~

+invoke(ForkJoinTask~T~ task) T

note: "工作窃取:双端队列(LIFO/FIFO)"

}

class ForkJoinWorkerThread {

-pool: ForkJoinPool

-workQueue: WorkQueue

+run() void

+onStart() void

+onTermination(Throwable exception) void

}

class WorkQueue {

-array: ForkJoinTask~?~[]

-base: int

-top: int

-ctl: int

-pool: ForkJoinPool

-owner: ForkJoinWorkerThread

+push(ForkJoinTask~?~ task) int

+pop() ForkJoinTask~?~

+poll() ForkJoinTask~?~

+tryUnpush(ForkJoinTask~?~ task) boolean

+growArray() ForkJoinTask~?~[]

note: "array容量8192起,base/top无锁"

}

class ForkJoinTask {

<<abstract>>

-status: int

+fork() ForkJoinTask~T~

+join() T

+invoke() T

+tryUnfork() boolean

+quietlyComplete() void

note: "增强Future:fork/join语义+工作窃取支持"

}

class RecursiveTask {

<<abstract>>

+compute() V

}

class RecursiveAction {

<<abstract>>

+compute() void

}

class CountedCompleter {

<<abstract>>

-completer: CountedCompleter~?~

-pending: int

+compute() void

+onCompletion(CountedCompleter~?~ caller) void

+tryComplete() void

+propagateCompletion() void

+addToPendingCount(int delta) void

note: "JDK8 Stream并行实现的核心载体"

}

class Runnable {

<<interface>>

+run() void

}

%% ========== 继承关系(放在类定义之后)==========

Executor <|-- ExecutorService

ExecutorService <|-- ScheduledExecutorService

ExecutorService <|-- AbstractExecutorService

AbstractExecutorService <|-- ThreadPoolExecutor

AbstractExecutorService <|-- ForkJoinPool

ThreadPoolExecutor <|-- ScheduledThreadPoolExecutor

Future <|-- RunnableFuture

RunnableFuture <|.. FutureTask

Future <|-- ForkJoinTask

Future <|-- ScheduledFuture

RunnableScheduledFuture --|> ScheduledFuture

RunnableScheduledFuture --|> Runnable

ScheduledFutureTask ..|> RunnableScheduledFuture

Delayed <|.. ScheduledFutureTask

ForkJoinTask <|-- RecursiveTask

ForkJoinTask <|-- RecursiveAction

ForkJoinTask <|-- CountedCompleter

RunnableFuture --|> Runnable

RejectedExecutionHandler <|.. AbortPolicy

RejectedExecutionHandler <|.. CallerRunsPolicy

RejectedExecutionHandler <|.. DiscardPolicy

RejectedExecutionHandler <|.. DiscardOldestPolicy

%% ========== 组合关系 ==========

AbstractExecutorService ..> FutureTask : creates

ThreadPoolExecutor o-- Worker : manages

ThreadPoolExecutor --> RejectedExecutionHandler : uses

ThreadPoolExecutor --> ThreadFactory : uses

ScheduledThreadPoolExecutor o-- ScheduledFutureTask : manages

ScheduledThreadPoolExecutor --> DelayedWorkQueue : uses

ForkJoinPool o-- ForkJoinWorkerThread : manages

ForkJoinWorkerThread --> WorkQueue : owns

WorkQueue --> ForkJoinTask : stores

Executors ..> ThreadPoolExecutor : creates

Executors ..> ScheduledThreadPoolExecutor : creates

Executors ..> ForkJoinPool : creates

%% ========== 工具类 ==========

class Executors {

<<utility>>

+newFixedThreadPool(int nThreads) ExecutorService

+newCachedThreadPool() ExecutorService

+newSingleThreadExecutor() ExecutorService

+newScheduledThreadPool(int corePoolSize) ScheduledExecutorService

+newWorkStealingPool() ExecutorService

+defaultThreadFactory() ThreadFactory

note: "工厂方法(已不推荐)"

}

class TimeUnit {

<<enum>>

NANOSECONDS

MICROSECONDS

MILLISECONDS

SECONDS

+toNanos(long d) long

+toMillis(long d) long

+sleep(long timeout) void

}父子孙

从上述类图可提炼出清晰的继承层次:

- ThreadPoolExecutor 与 ForkJoinPool 是兄弟关系,都继承自 AbstractExecutorService

- ScheduledThreadPoolExecutor 是 ThreadPoolExecutor 的子类,是 AbstractExecutorService 的孙子

Executor 接口

将任务提交和任务执行进行解耦(decoupling the execution mechanic)。用户无需关注如何创建线程,如何调度线程(scheduling)来执行任务,用户只需提供 Runnable 对象,将任务的运行逻辑提交到执行器(Executor)中,由 Executor 框架完成线程的调配和任务的执行部分。

JUC 里所有的解耦设计都不一定是异步的,它只是解耦,所以执行器本身也是可以同步执行的:

1 | |

一般而言可以认为,executor 会 spawns a new thread for each task.

ExecutorService 接口

增加了一些能力:

扩充执行任务的能力,补充可以为一个或一批异步任务生成 Future 的方法(),从这里开始执行器开始可以执行异步任务:

1 | |

在上面的方法里,submit 能接收无结果的 Runnable、有结果的 Runnable、能返回结果的 Callable,再加上底层无返回结果的 execute,构成了4个基础的单任务api。

ExecutorService 还提供了管控线程池的方法,比如停止线程池的运行。详见后续章节对 shutdown() 和 shutdownNow() 的详细分析。

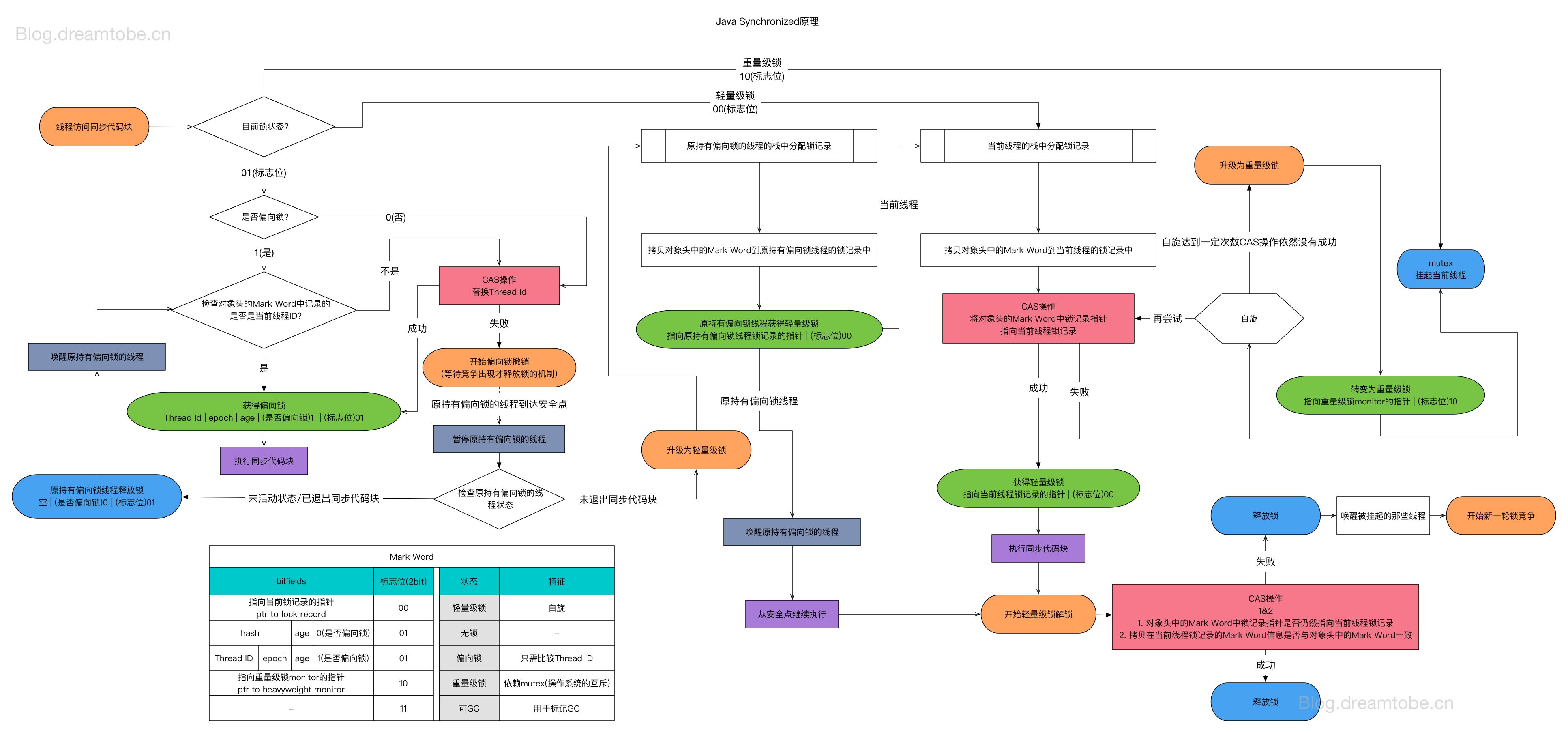

线程池的拒绝策略与线程中断机制

线程池通过 拒绝策略(Rejection Policy)和线程中断(Thread Interruption) 两种机制来处理任务提交失败和线程池关闭场景。

拒绝策略触发场景

拒绝策略通过 RejectedExecutionHandler 接口实现,在以下场景触发:

| 触发场景 | 触发时机 | 调用位置 | 说明 |

|---|---|---|---|

| 线程池饱和 | 核心线程数已满 + 队列已满 + 达到最大线程数 | execute() 步骤3失败 |

无法创建新线程处理任务 |

| 线程池关闭后提交 | 调用 shutdown() 或 shutdownNow() 后 |

execute() 步骤1检查 |

状态 >= SHUTDOWN 时拒绝新任务 |

| Worker 创建失败 | ThreadFactory 返回 null 或线程启动失败 | addWorker() 失败后 |

无法创建工作线程 |

代码示例:

1 | |

线程中断触发场景

线程中断用于通知线程检查状态或终止执行,ThreadPoolExecutor 中的线程中断触发场景如下:

| 触发场景 | 方法调用 | 中断范围 | 目的 |

|---|---|---|---|

| 显式关闭(优雅) | shutdown() |

仅空闲线程 | 让空闲线程检查池状态后退出,正在执行的任务不受影响。这一段不需要业务代码响应中断,只要 runWorker 内部的 take/pol 的响应中断机制和对中断异常的处理就透明地处理这些中断,空闲线程自然退出死亡 |

| 显式关闭(强制) | shutdownNow() |

所有线程(包括执行中) | 立即中断所有线程,尝试停止正在执行的任务。需要业务代码能够响应中断。 |

| 传播式关闭 | tryTerminate() |

一个空闲线程 | 终止条件满足但仍有线程时,中断一个空闲线程形成连锁反应 |

| 配置变更 | setCorePoolSize() 等 |

空闲线程 | 参数调小后回收多余的空闲线程 |

| 任务取消 | Future.cancel(true) |

执行该任务的线程 | 用户主动取消任务 |

关键区别:

1 | |

常见误解澄清:

| 误解 | 真相 |

|---|---|

❌ awaitTermination() 超时会中断线程 |

✅ 只是等待方法返回 false,不会触发任何中断 |

| ❌ 周期任务异常会中断线程 | ✅ 任务静默终止,线程继续存活处理其他任务 |

| ❌ 线程池饱和会中断线程 | ✅ 触发拒绝策略,不会中断已存在的线程 |

❌ tryTerminate() 会中断所有线程 |

✅ 只中断一个空闲线程,通过传播式关闭逐步终止 |

最佳实践:

1 | |

AbstractExecutorService

将执行任务的流程串联起来,保证下层实现只需关注 execute() 方法:

- 大部分任务接口在这一层有了实现,最终都调向 execute()

- 生命周期接口留给下层实现

详细实现原理(newTaskFor 工厂方法、任务包装机制、模板方法模式)见 AbstractExecutorService 详解 章节。

ThreadPoolExecutor

实现了 execute,围绕 execute 的批量和异步化给出了一个经典的线程池执行器实现。

将会一方面维护自身的生命周期,另一方面同时管理线程(Thread)和任务(Task,也就是 Runnable),使两者良好的结合从而执行并行任务。

execute 的三段式判断体现了生产者-消费者解耦模型:当 workerCount < corePoolSize 时创建核心线程,任务作为 firstTask 直接传递给 Worker;当队列未满时入队等待,阻塞队列成为生产者与消费者之间的桥梁;当核心线程数已满、队列已满(入队失败)且 workerCount < maximumPoolSize时创建非核心线程,同样以 firstTask 方式传递。无论哪种路径,真正的消费者都是 Worker 线程的 runWorker 循环——它先消费 firstTask,后续通过 getTask() 从队列持续消费。

ScheduledExecutorService 接口

ScheduledExecutorService 扩展了 ExecutorService 接口,专门用于支持延迟执行和周期性执行的任务调度。

1 | |

两种周期模式的时间计算差异:

| 方法 | 时间计算基准 | 任务耗时 > period 时的行为 | 适用场景 |

|---|---|---|---|

scheduleAtFixedRate |

上次开始时间 + period | 等待完成后立即执行下一次(追赶) | 心跳检测、定时采样 |

scheduleWithFixedDelay |

上次完成时间 + delay | 严格保证任务间隔 | 任务队列处理、限流场景 |

1 | |

核心特性:

- 支持一次性延迟执行

- 支持固定频率/固定延迟两种周期模式

- 返回 ScheduledFuture 用于任务控制和结果获取

实现类:

ScheduledThreadPoolExecutor是主要实现- 内部使用

DelayedWorkQueue(基于二叉堆的优先级队列) - 任务通过

ScheduledFutureTask封装,支持时间管理和周期计算

详细说明:关于内部实现机制、核心组件架构、任务调度原理等内容,请参阅第2章《ScheduledThreadPoolExecutor 详解》。

ScheduledThreadPoolExecutor 对 ThreadPoolExecutor 的扩展

ScheduledExecutorService 接口定义了定时调度的契约,而 ScheduledThreadPoolExecutor 是其主要实现。其类声明体现了双重设计:

1 | |

这形成了一个清晰的扩展层次:

- 接口层:ScheduledExecutorService 扩展 ExecutorService,新增定时调度契约

- 实现层:ScheduledThreadPoolExecutor 继承 ThreadPoolExecutor,复用线程池核心能力

核心扩展点:

| 扩展维度 | ThreadPoolExecutor | ScheduledThreadPoolExecutor |

|---|---|---|

| 队列 | 外部传入 BlockingQueue |

强制使用 DelayedWorkQueue(二叉堆) |

| 任务封装 | FutureTask |

ScheduledFutureTask(新增 time/period 字段) |

| execute() | 直接入队执行 | 重写为 schedule(command, 0, NANOSECONDS) |

| submit() | 通过 execute() | 同样走 schedule(0) 路径 |

| 新增方法 | 无 | schedule 系列、setRemoveOnCancelPolicy、decorateTask |

设计要点:

-

队列强制绑定:构造器不接受外部队列参数,在 super() 调用中硬编码 DelayedWorkQueue

-

任务周期管理:ScheduledFutureTask 通过 period 字段区分一次性任务(0)、fixed-rate(正数)、fixed-delay(负数)

-

线程池复用:完全继承 ThreadPoolExecutor 的 Worker 管理、状态机、拒绝策略机制

Worker 机制复用解析:延时线程池确实能够完全复用 ThreadPoolExecutor 的 Worker 机制,关键在于队列的阻塞语义。Worker 线程的

getTask()方法调用queue.take()获取任务,而DelayedWorkQueue.take()会阻塞直到队首任务到期。Worker 线程对此完全无感知——它只是在队列上等待,取到任务后执行。换言之,延时逻辑封装在队列层而非 Worker 层,这正是 ThreadPoolExecutor 将队列设计为可扩展组件的精妙之处:通过替换队列实现,无需修改 Worker 代码即可支持延时调度。TPE 扩展边界:要扩展 ThreadPoolExecutor,能够扩展的只有队列、线程工厂、拒绝策略以及 RunnableFuture/FutureTask 任务。Worker 控制了主循环(

runWorker()中的 while 循环),其行为是固定的:取任务→执行任务→循环。真正的扩展点在ftask.run()调用处——即任务执行环节。decorateTask()方法正是为此设计,允许子类包装任务对象,在run()方法前后插入自定义逻辑,调用自定义线程池重调度方法,这也是 ScheduledThreadPoolExecutor 实现周期调度的关键机制。任务提交路径:ScheduledThreadPoolExecutor 的

execute()和schedule()都没有调用父类的execute()。execute()被重写为schedule(command, 0, NANOSECONDS),而schedule()内部通过delayedExecute()直接调用super.getQueue().add(task)向队列投递任务,并调用ensurePrestart()确保有线程运行。这跳过了 ThreadPoolExecutor 原生的入队逻辑,强制所有任务走 DelayedWorkQueue。生产者-消费者解耦:Worker 线程的运行与

execute()/schedule()是解耦的。后者只是生产者,向队列投递任务;Worker 线程一旦启动,就在runWorker()的 while 循环中自主运行,通过getTask()从队列消费任务。两者通过队列连接,互不直接驱动。任务分配机制:多个 Worker 线程同时阻塞在

queue.take()或queue.poll()上。当任务入队后,哪个线程被唤醒并获取任务由阻塞队列的锁竞争和操作系统线程调度决定,而非 Java 层面的随机分配。以DelayedWorkQueue为例,其take()方法使用ReentrantLock保护,任务出队需要获取这把锁——竞争成功的线程获得任务,其他线程继续阻塞或重试。这是竞争性分配而非随机分配。 -

API 兼容:execute/submit 语义保持不变,内部转换为即时调度

API 主次之分:从设计意图看,

execute()和submit()都是通过schedule(0)路径实现的,本质上是"延时为 0 的调度",只是延时封装下的立即执行。真正体现 ScheduledExecutorService 定时调度能力的核心 API 是schedule()、scheduleAtFixedRate()和scheduleWithFixedDelay(),而后者两个周期调度方法永远不会被传统的 AbstractExecutorService 体系(execute/submit/invokeAll/invokeAny)调用。

1 | |

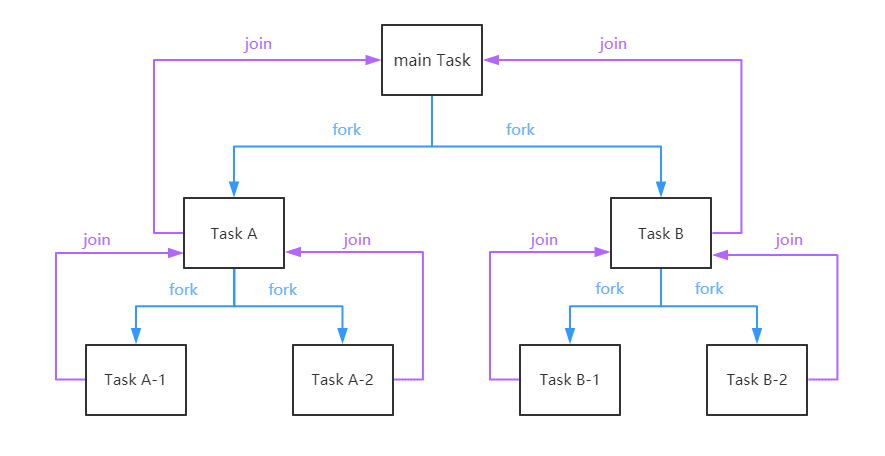

ForkJoinPool

这个线程池本身就是一个复杂框架,为 JDK 其他组件提供 yet another executor alternative。

这个框架有个特点:

- 产生的线程默认是守护线程,其他线程池产生的默认不是守护线程。

- 产生的线程会自动收缩-不存在空转的 core thread 问题。

- 公共线程池的名字一般叫“ForkJoinPool.commonPool-worker-1”。

这里就要讨论到一个很多人忽略的问题:我们如何决定何时使用守护类线程。这类线程可以用来执行一些:

- 临时执行的任务,这些任务之间如果存在父子关系更好。

- 后台监控类任务。

- 可以被中断的计算任务。

规范说明:根据Java Language Specification §12.8,守护线程的关键特性是"不阻止JVM退出"。因此判断是否使用守护线程的标准应该是:

- 任务是否可以在JVM退出时被安全中断

- 任务是否需要确保完成(如数据持久化、事务提交)

- 任务失败是否可以接受或能够重试恢复

- 典型的工作线程池包括两类:

- IO线程池:平台线程池的一种,专门处理IO密集型任务(如文件读写、网络请求),通常使用固定大小的线程池(如FixedThreadPool,本质是 ThreadPoolExecutor 的封装)。

- 计算线程池:平台线程池的一种,专门处理CPU密集型任务(如数值计算、数据处理),可使用ForkJoinPool等工作窃取线程池。

初始化这类线程池有一些简单的工厂方法,比原始构造器更加可用:Executors.newWorkStealingPool(int parallelism),其余工厂方法见后文。

ForkJoinPool 概述:

ForkJoinPool 是 Java 7 引入的另一种 ExecutorService 实现,与 ThreadPoolExecutor 走了完全不同的设计路线。它的核心特性包括:

- 工作窃取(Work-Stealing):每个工作线程拥有独立的双端队列(Deque),空闲线程会主动从繁忙线程的队列中"窃取"任务,实现自动负载均衡。

- 分治并行(Fork/Join):天然支持递归任务分解,通过

ForkJoinTask(RecursiveTask/RecursiveAction)实现分治算法。 - asyncMode 参数:控制工作队列的调度模式——LIFO(默认,适合递归分治)或 FIFO(适合事件驱动场景)。

- 固定并行度:线程数通常等于 CPU 核心数,不像

ThreadPoolExecutor那样动态扩缩容。

特性关系澄清:

这四个特性中,工作窃取是 ForkJoinPool 的核心基础设施,无论选择哪种 asyncMode 或任务类型,工作窃取机制都始终启用。工作窃取是调度层面的机制(如何分发任务),分治并行是任务层面的模式(如何分解任务),两者是正交关系——工作窃取可服务于非分治任务(如 newWorkStealingPool() 处理普通并行任务),分治算法理论上也可使用其他调度机制。在 ForkJoinPool 的实现中,工作窃取是分治并行的底层支撑,但这不代表两者在概念上存在从属关系。

JDK 提供了两种常用的获取方式:

ForkJoinPool.commonPool():全局共享的 ForkJoinPool 实例,parallelStream()和CompletableFuture默认使用。Executors.newWorkStealingPool(int parallelism):创建独立的工作窃取线程池。

关于 ForkJoinPool 的 asyncMode 参数详解、工作窃取机制原理、与 ThreadPoolExecutor 的核心差异对比、commonPool 的任务排队机制等深入内容,详见 ForkJoinPool 详解:分治并行的执行引擎 章节。

小结

本章介绍了 Java 线程池的核心接口体系,遵循“契约层 → 模板层 → 实现层 → 工厂层”的设计脉络:

- 契约层:Executor → ExecutorService → ScheduledExecutorService,逐层扩展执行、生命周期、定时调度契约(详见上文各接口章节)

- 模板层:AbstractExecutorService 为

submit/invokeAll/invokeAny提供默认实现,下层只需实现execute()(详见 AbstractExecutorService 详解) - 实现层:ThreadPoolExecutor(经典线程池)、ScheduledThreadPoolExecutor(定时调度)、ForkJoinPool(工作窃取)

- 工厂层:Executors 静态工厂方法集合(如

newFixedThreadPool、newCachedThreadPool、newWorkStealingPool)

AbstractExecutorService 详解

AbstractExecutorService 将执行任务的流程串联起来,保证下层实现只需关注 execute() 方法。这一层的大部分方法实现遵循以下模式:

- 把任务包装成 FutureTask

- 用 execute 执行这个 FutureTask

- 返回 FutureTask 实例供调用者使用

newTaskFor:任务包装的核心工厂方法

newTaskFor 是 AbstractExecutorService 的核心工厂方法,它负责将用户提交的任务(Runnable 或 Callable)包装成 RunnableFuture,默认返回 FutureTask 实例,但子类可以 override 提供自定义实现。关于 FutureTask 的内部结构(callable/outcome/run 的同级关系、状态机、RunnableAdapter 适配器等),详见 ThreadPoolExecutor 如何管理任务 章节。

方法签名

1 | |

Runnable 变成 Future,总要配一个 Value,这是一个好的设计模式。

封装关系:把什么东西封装成什么东西?

1 | |

默认实现

1 | |

为什么需要 newTaskFor?

-

解耦任务类型:

- 用户提交的是

Callable<T>或Runnable - Executor 接收的是

Runnable - Future 接口提供

get()获取结果 newTaskFor将这三者统一起来

- 用户提交的是

-

支持自定义扩展:

子类可以重写newTaskFor来添加自定义逻辑:

1 | |

- 统一任务包装:

所有高级方法都依赖newTaskFor:

1 | |

invokeAny 为什么返回 T 而不是 Future

与 submit 和 invokeAll 不同,invokeAny 直接返回结果值 T。这源于语义差异:

submit/invokeAll:提交任务后立即返回,调用者稍后通过 Future 获取结果——返回时任务可能未完成invokeAny:阻塞等待任意一个任务成功完成——返回时结果已确定,不存在"未来"需要等待

如果 invokeAny 返回 Future<T>,调用者必然要调用 get(),而此时 Future 已完成,这层包装毫无价值。直接返回 T 简化了 API 使用,符合"最少意外原则"。

这三个方法的实现透露了得到 future 的诀窍:因为 execute 返回 void,所以要保存 newTaskFor 的返回值引用,然后调用 execute 执行。可以说凡是需要 execute 的最底层,要得到 Future 都需要抓住 newTaskFor 的返回值。

像 invokeAll 和 submit 只是"封装 + execute"的门面,在创建 FutureTask 后、调用 execute 前,有机会对 FutureTask 进行额外处理(如加入列表追踪、设置超时等)。

封装的核心价值

| 输入 | 封装过程 | 输出 | 价值 |

|---|---|---|---|

Callable<T> |

newTaskFor() |

FutureTask<T> |

获得异步结果获取能力 |

Runnable + T |

newTaskFor() |

FutureTask<T> |

无返回值任务也能返回结果 |

| 计算逻辑 | 包装为 Runnable + Future |

可提交、可等待 | 统一的异步编程模型 |

设计模式:工厂方法模式

classDiagram

class AbstractExecutorService {

<<abstract>>

#newTaskFor(Callable~T~) RunnableFuture~T~

#newTaskFor(Runnable, T) RunnableFuture~T~

+submit(Callable~T~) Future~T~

+invokeAll(...) List~Future~T~~

}

class ThreadPoolExecutor {

#newTaskFor(Callable~T~) RunnableFuture~T~

#newTaskFor(Runnable, T) RunnableFuture~T~

}

class CustomExecutor {

#newTaskFor(Callable~T~) RunnableFuture~T~

}

class RunnableFuture {

<<interface>>

+run() void

}

class Future~T~ {

<<interface>>

}

class FutureTask {

+run()

+get() T

+cancel()

}

RunnableFuture --|> Future : extends

AbstractExecutorService <|-- ThreadPoolExecutor

AbstractExecutorService <|-- CustomExecutor

AbstractExecutorService ..> RunnableFuture : creates via

FutureTask ..|> RunnableFuture : implements要点

newTaskFor 是连接"同步任务"和"异步执行"的桥梁:

- 它将计算任务(Callable/Runnable)封装为可执行可等待的对象(FutureTask)

- 它是 AbstractExecutorService 所有高级方法的基础

- 它提供了扩展点,允许子类自定义任务包装逻辑,我们常见的自定义 traceId 传递的 newTask 匿名类内部,都有使用扩展的 FutureTask。

- 它体现了"模板方法模式":定义算法骨架,子类实现具体步骤

FutureTask:任务包装的标准实现

类型体系与设计定位

FutureTask 是 Java 并发框架中「可取消的异步计算」的核心实现(@since 1.5, @author Doug Lea)。它实现了 RunnableFuture<V> 接口,而 RunnableFuture 同时继承了 Runnable 和 Future——这两个接口一个面向线程池(对内执行),一个面向任务调用方(对外获取结果)。FutureTask 是 RunnableFuture 的两个经典实现之一(All Known Implementing Classes: FutureTask, SwingWorker),可以认为它是可执行 Future 的最忠实实现。

classDiagram

class FutureTask {

-callable: Callable~V~

-outcome: Object

-state: int

-runner: Thread

-waiters: WaitNode

+run() void

+get() V

+cancel(boolean) boolean

+isDone() boolean

}

note for FutureTask "@since 1.5"

class RunnableFuture {

<<interface>>

+run() void

}

note for RunnableFuture "@since 1.6"

class Runnable {

<<interface>>

+run() void

}

note for Runnable "@since 1.0"

class Future {

<<interface>>

+get() V

+cancel(boolean) boolean

+isDone() boolean

}

note for Future "@since 1.5"

class Callable {

<<interface>>

+call() V

}

note for Callable "@since 1.5"

FutureTask ..|> RunnableFuture : implements

RunnableFuture --|> Runnable : extends

RunnableFuture --|> Future : extends

FutureTask o-- Callable : has

FutureTask o-- Object : stores

FutureTask o-- Thread : referencesFutureTask 本身不是 Callable,但包含 Callable。它的双重身份是设计的关键:

- 作为 Runnable:可以被提交给 Executor 执行

- 作为 Future:提供结果获取、取消、状态查询能力

核心语义约束:

- 单次执行原则:任务只能执行一次,一旦进入终态(NORMAL/EXCEPTIONAL/CANCELLED/INTERRUPTED)就不可重启。

- 阻塞语义:

get()在任务完成前会阻塞调用线程,这是 Future 模式的核心价值。 - 不可逆取消:一旦取消成功,任务即使尚未开始也不会再执行。

- runAndReset 是例外:专为周期性任务设计,执行后重置状态但不设置结果。

执行环境无关性:FutureTask 的 run()、runAndReset() 及其状态机设计与执行环境完全解耦。不假定调用者是 ThreadPoolExecutor 的 Worker、用户线程还是 main 线程;不区分同步调用、异步提交或定时调度。runner = Thread.currentThread() 的语义是“谁调用就记录谁”,状态转换完全自包含,不依赖外部线程池状态。这是典型的关注点分离设计:FutureTask 只负责状态管理、结果存储、等待/唤醒协调,线程池只负责线程管理和任务调度,两者通过 Runnable 接口解耦。

1 | |

Javadoc 释义:

- 「cancellable asynchronous computation」:FutureTask 的核心定位是可取消的异步计算单元。

- 「base implementation of Future」:提供 Future 接口的基础实现,子类可扩展。

- 「get methods will block」:阻塞是获取异步结果的代价,这是 Future 模式的本质特征。

- 「wrap a Callable or Runnable」:适配器模式,统一两种任务类型-通过两种构造器的形式。实际上只能wrap一个 Callable,Runnable 必须适配成 Callable 放进来。

- 「protected functionality」:模板方法模式,

done()等钩子供子类定制。

成员字段与构造

FutureTask 有 5 个一级成员字段,它们之间构成了一个典型的「输入 → 执行 → 输出」模型:

1 | |

run() 方法的核心职责就是调用 callable.call() 获取返回值,然后通过 set(result) 将结果写入 outcome。callable 是输入,run() 是执行器(内建),outcome 是输出(内建)。

1 | |

FutureTask 提供两个构造器,支持 Callable 和 Runnable 两种任务类型。构造器中 state = NEW 写在最后,利用 volatile 捎带同步保证 callable 的可见性:

1 | |

当传入 Runnable 时,线程池使用 RunnableAdapter 将其适配为 Callable:

1 | |

这形成了清晰的封装层次:FutureTask.run() → callable.call()(可能是 RunnableAdapter.call(),也可能是普通的callable.call())→ task.run() → return result 设置 outcome → report outcome。整个链路将无返回值的 Runnable 转换为有返回值的 Future 模式。之所以这样设计,本质上是因为 Thread 类底层只支持 run(),不支持 call()。FutureTask 是能让 runnable 内部含有结果,而且可以借助一个输出接口输出结果的经典范例。

同级封装适配的设计动因:

| 方向 | 机制 | 核心约束 | 设计要点 |

|---|---|---|---|

| Callable → Runnable | FutureTask(实质上是 RunnableFuture) | run() 是 void,无法返回值 | run() 内部调用 call(),将返回值存入 outcome,通过 get() 暴露。get() 是带有延时和状态检查的 call():call() 立即执行并返回,get() 等待状态机达到终态后才返回 outcome |

| Runnable → Callable | RunnableAdapter(实质上是 Callable) | run() 无返回值,无法产出计算结果 | 只能提供预设的 result,call() 执行 run() 后直接返回预设值。若需计算结果,应直接使用 Callable |

简言之:Callable 封装成 Runnable 需要一个中间层(FutureTask-RunnableFuture)来“接住”返回值;Runnable 适配成 Callable 只能「带着结果进去」,无法「计算出结果」。

状态机

state 字段是 FutureTask 的核心状态机,使用 volatile int 而非枚举类型——这是 Doug Lea 的常见设计风格,核心考量是:配合 UNSAFE.compareAndSwapInt 实现无锁状态转换,volatile 保证可见性,整数比较性能更高。

1 | |

Javadoc 释义:

- 「initially NEW」:构造后初始状态为 NEW(0),这是唯一可以接受任务取消的状态

- 「terminal state」:终态包括 NORMAL/EXCEPTIONAL/CANCELLED/INTERRUPTED,不可逆转

- 「transient values」:COMPLETING/INTERRUPTING 是瞬态,主要用于设置 outcome 或执行中断的窗口期

- 「ordered/lazy writes」:使用

UNSAFE.putOrderedInt而非 volatile 写,因为终态唯一不可变

putOrderedInt 语义详解:putOrderedInt 是弱化版 volatile 写(又称 lazySet)。与 putIntVolatile 的区别在于内存屏障:

| 方法 | 写前屏障 | 写后屏障 |

|---|---|---|

putIntVolatile |

StoreStore | StoreLoad |

putOrderedInt |

StoreStore | 无 |

为什么叫 “ordered”:保证 store-store ordering,此写操作之前的所有写不会被重排序到此写之后(如 outcome = v 必然先于 state = NORMAL)。

为什么叫 “lazy”:省略了写后的 StoreLoad 屏障,写入可能滞留在 CPU 写缓冲区,其他线程最终会看到但不保证立即可见。在 x86 上,putOrderedInt 编译为普通 MOV 指令,而 putIntVolatile 需要 LOCK 前缀或 MFENCE。

适用场景:只需 happens-before 传递性不需即时可见性时使用。FutureTask 终态写入正是此场景:读到终态的线程必能读到 outcome,但不要求终态立即被观测到。JDK 9+ 的 VarHandle.setRelease() 是其替代 API。

FutureTask 状态转换图:

stateDiagram-v2

[*] --> NEW: 任务创建

NEW --> COMPLETING: call()执行完成

NEW --> CANCELLED: cancel(false)

NEW --> INTERRUPTING: cancel(true)

COMPLETING --> NORMAL: 正常结果设置完成

COMPLETING --> EXCEPTIONAL: 异常结果设置完成

INTERRUPTING --> INTERRUPTED: 中断完成

NORMAL --> [*]: 终态

EXCEPTIONAL --> [*]: 终态

CANCELLED --> [*]: 终态

INTERRUPTED --> [*]: 终态

note right of NEW: 初始状态,任务可被取消

note right of COMPLETING: 瞬态,正在设置结果

note right of INTERRUPTING: 瞬态,正在中断runner值得一提的是,任务的中间状态是一个瞬态,它非常的短暂。而且任务的中间态并不代表任务正在执行,而是任务已经执行完了,正在设置最终的返回结果,所以可以这么说:

只要 state 不处于 NEW 状态,就说明任务已经执行完毕。

注意,这里的执行完毕是指传入的 Callable 对象的 call 方法执行完毕,或者抛出了异常。所以这里的 COMPLETING 的名字显得有点迷惑性,它并不意味着任务正在执行中,而意味着 call 方法已经执行完毕,正在设置任务执行的结果。

换言之,只有 NEW 状态才是 cancellable 的。

状态查询方法:

1 | |

执行入口:run() 与 runAndReset()

run()

state == NEW 检查与 CAS 绑定 runner 共同保证 FutureTask 最多执行一次。

run() 是任务执行的入口-通常由线程池的 worker 调用,worker 最终也成为 runner。核心流程:state 检查 + CAS 绑定 runner 保证幂等 → 执行 callable.call() → 根据结果调用 set() 或 setException()(内部 CAS NEW→COMPLETING 进入中间态,再转为终态,这个转换在一个方法里全部完成,所以中间态是很短暂的)→ finally 中置空 runner 并处理可能的中断。

1 | |

runner 的生命周期

runner 字段记录了正在执行任务的线程引用,它的注入和使用流程如下:

sequenceDiagram

participant Caller as 调用方线程

participant Pool as 线程池

participant FutureTask

participant Worker as 线程池Worker

Caller->>Pool: submit(task)

Pool->>FutureTask: new FutureTask(task)

Note right of FutureTask: state = NEW, runner = null

Pool-->>Caller: return futureTask

Worker->>FutureTask: run()

FutureTask->>FutureTask: CAS设置 runner = Worker

Note right of FutureTask: Worker执行 callable.call()

Caller->>FutureTask: cancel(true)

FutureTask->>FutureTask: CAS NEW→INTERRUPTING

FutureTask->>Worker: runner.interrupt()

FutureTask->>FutureTask: state = INTERRUPTED

FutureTask->>FutureTask: finishCompletion()

Note over Worker: Worker收到中断信号

Worker->>FutureTask: run()的finally块

FutureTask->>FutureTask: runner = null

FutureTask->>FutureTask: handlePossibleCancellationInterrupt()

Note right of FutureTask: 若state==INTERRUPTING则自旋等待FutureTask 只执行一次,执行完成(无论成功、异常还是取消)后,runner 字段会被置为 null。

Thread.start → Worker.run → runWorker → FutureTask.run 调用关系辨析

线程池中任务的执行涉及多个层次的 run 方法调用,理解它们的包含关系是掌握线程池执行模型的关键。

调用链:

1 | |

runAndReset()

runAndReset() 专为周期性任务设计(典型应用场景是 ScheduledThreadPoolExecutor 中的定时任务)。与 run() 的关键区别:

| 维度 | run() |

runAndReset() |

|---|---|---|

| 结果设置 | 调用 set(result) 或 setException(ex) 清空 callable;runner 在 finally 块中清空 |

不设置结果,get() 永远阻塞或超时,无法获取中间结果。正常完成时不调用 set(),故不触发 finishCompletion(),callable 保留;runner 在 finally 块中清空 |

| 正常完成 | NEW → NORMAL(终态) | 状态保持 NEW,允许再次执行 |

| 异常/取消 | 进入终态 | 进入终态(与 run() 一致) |

| 可重复执行 | 否 | 仅正常完成时可重复 |

1 | |

Javadoc 释义:

- 「without setting its result」:执行但不产生可获取的结果

- 「resets this future to initial state」:重置的是状态而非 callable 引用

- 「failing to do so if…exception or cancelled」:异常和取消都会导致进入终态,不再可重置

- 「intrinsically execute more than once」:典型如定时任务、心跳任务等周期性场景

三类终态方法:set / setException / cancel

FutureTask 有三种进入终态的路径,它们都以 finishCompletion() 收尾:

set():正常完成

状态转换:NEW → COMPLETING → NORMAL。CAS 先设置中间态 COMPLETING 防止并发取消,中间态期间写入 outcome(可见性由后续的 volatile state 写入保证),然后用 putOrderedInt(懒写)写入终态 NORMAL。

1 | |

setException():异常完成

状态转换:NEW → COMPLETING → EXCEPTIONAL。与 set() 几乎相同,但 outcome 存储的是 Throwable。如果 CAS 失败(已被 cancel),异常信息丢失,这是设计折衷。

1 | |

cancel():取消/中断

从这个方法可以看出,中断也是 cancel 的一种。只能从 NEW 状态取消,返回 true 表示状态迁移成功,不保证任务实际停止。

1 | |

| 参数 | 状态转换 | 行为 |

|---|---|---|

cancel(false) |

NEW → CANCELLED | 仅标记取消,不中断执行线程 |

cancel(true) |

NEW → INTERRUPTING → INTERRUPTED | 标记取消并对 runner 线程调用 interrupt() |

主动取消任务的 API 总览:

| API | 作用范围 | 行为 |

|---|---|---|

Future.cancel(boolean) |

单任务级别 | 标记取消,可选中断执行线程 |

shutdownNow() |

线程池级别 | 中断所有 Worker,队列任务作为返回值 |

其他如 shutdown() 是关闭线程池入口,不取消已提交任务;setRemoveOnCancelPolicy(true) 是 cancel() 的队列行为优化,非独立取消方式。

cancel(true) vs cancel(false) 的语义差异

Future.cancel(boolean mayInterruptIfRunning) 的语义:一个 Future 对应一个任务,参数决定对该任务如何处理。

| 任务状态 | cancel(false) | cancel(true) |

|---|---|---|

| 尚未开始 | 取消成功,不执行 | 取消成功,不执行 |

| 正在执行 | 不中断,让任务完成 | 调用 Thread.interrupt() 尝试中断 |

实践中的状态分布:在典型线程池场景中,"尚未开始"是一个非常短暂的时间窗口——除非任务在队列中排队,否则线程池有空闲线程时任务几乎立即被执行。因此,cancel(false) 与 cancel(true) 的核心差异几乎只体现在任务正在执行时。

1 | |

关键洞察:mayInterruptIfRunning 参数仅在任务正在执行时产生差异。任务未开始时,两参数效果相同;任务执行后,只有 cancel(true) 会额外设置中断标志。

重要注意:

- 中断只是设置中断标志,任务代码必须检查

Thread.interrupted()或使用可中断方法才能真正终止 - 阻塞 IO、

synchronized锁等不一定响应中断 - 对于不可中断阻塞,需要使用底层超时机制(HTTP timeout、JDBC timeout 等)

cancel(true) 对线程池的影响:

cancel(true) 对线程池本身无直接影响——中断信号仅作用于任务内部逻辑,Worker 线程不会因此退出。原因如下:

-

FutureTask 是异常隔离层:无论

call()抛出什么异常(包括InterruptedException),都被捕获存储为outcome,不会传播到runWorker(),因此不会触发processWorkerExit()的异常退出路径。 -

线程池唯一感知的是

task.run()的返回:正常返回则 Worker 继续循环获取下一个任务;抛出异常则可能触发线程补充机制。FutureTask 保证task.run()不抛异常。 -

中断依赖协作:如果 command 内部不检查中断标志、不调用可中断方法,

cancel(true)对任务行为无影响。

为何需要 INTERRUPTING 中间态?

cancel(true) 分两步:CAS 进入 INTERRUPTING → 执行 t.interrupt() → 设置 INTERRUPTED。若直接 CAS 到 INTERRUPTED,存在时序竞争:

1 | |

若无 INTERRUPTING 中间态,run() 无法感知 cancel(true) 正在进行,可能在 t.interrupt() 执行前就返回,线程被复用执行新任务时收到这个“过期中断”——即中断泄漏。handlePossibleCancellationInterrupt() 通过自旋等待确保中断操作完成后 run() 才返回。

finishCompletion():终态收尾

不管是正常完成/异常完成/取消,最终都一定要调用到这个方法。

所有终态方法最终都调用 finishCompletion(),它负责三件事:唤醒所有等待线程、调用 done() 钩子、置空 callable 帮助 GC。

1 | |

LockSupport 补充:

LockSupport是 JUC 底层的线程阻塞/唤醒原语,基于许可证(permit)模型:park()消费许可证(无则阻塞),unpark()生产许可证(可提前发放,不可累加)。与Object.wait/notify的关键区别是无需持有监视器锁、unpark可在park之前调用、不会抛出InterruptedException。

结果获取:get() / awaitDone() / report()

get() 的逻辑分为两部分:阻塞等待交给 awaitDone(),结果解释交给 report()。

sequenceDiagram

participant Caller as 调用方线程

participant FutureTask

participant WaitNode

participant Runner as 执行线程(Worker)

Caller->>FutureTask: get()

FutureTask->>FutureTask: 检查 state <= COMPLETING?

alt state > COMPLETING

FutureTask->>FutureTask: report(state)

FutureTask-->>Caller: 返回结果或抛出异常

else state <= COMPLETING

FutureTask->>FutureTask: awaitDone(timed, nanos)

loop 多轮自旋

Note over FutureTask: 检查中断状态

alt 被中断

FutureTask->>FutureTask: removeWaiter(q)

FutureTask-->>Caller: 抛出 InterruptedException

end

alt state > COMPLETING

FutureTask-->>FutureTask: 返回终态

else state == COMPLETING

FutureTask->>FutureTask: Thread.yield()

else q == null

FutureTask->>WaitNode: new WaitNode()

Note right of WaitNode: 捕获当前线程引用

else !queued

FutureTask->>FutureTask: CAS 入栈(q.next=waiters, waiters=q)

else

FutureTask->>FutureTask: LockSupport.park(this)

Note over FutureTask: 线程挂起等待唤醒

end

end

Note over Runner: 任务执行完成

Runner->>FutureTask: set(result) 或 setException(ex)

FutureTask->>FutureTask: finishCompletion()

loop 遍历 waiters 栈

FutureTask->>WaitNode: 获取 thread 引用

FutureTask->>Caller: LockSupport.unpark(thread)

end

Note over Caller: 被唤醒,继续自旋

FutureTask->>FutureTask: 检测到 state > COMPLETING

FutureTask-->>FutureTask: awaitDone 返回终态

FutureTask->>FutureTask: report(state)

alt state == NORMAL

FutureTask-->>Caller: 返回 (V)outcome

else state >= CANCELLED

FutureTask-->>Caller: 抛出 CancellationException

else state == EXCEPTIONAL

FutureTask-->>Caller: 抛出 ExecutionException

end

end1 | |

awaitDone():自旋 + LockSupport.park 的阻塞等待

awaitDone 采用多轮自旋策略:第一轮创建 WaitNode,第二轮 CAS 入队,第三轮开始 park。中断时清除中断位并抛出 InterruptedException,超时后清理节点并返回当前状态。唤醒由 finishCompletion() 中的 LockSupport.unpark() 触发。

1 | |

WaitNode:Treiber Stack 节点

WaitNode 是用于记录等待 get() 结果的线程的单向链表节点,组织成 Treiber Stack(无锁并发栈)。

为什么需要 waiters/WaitNode:一个 FutureTask 可能被多个线程同时调用 get(),这些线程都会通过 LockSupport.park() 阻塞等待结果。JUC 的设计约束是:每个 park() 点都必须有对应的 unpark() 路径,否则线程会永久阻塞。因此 FutureTask 必须记录所有等待线程的引用,确保任务完成时 finishCompletion() 能遍历并 unpark() 每一个。详见《Java 并发编程笔记·JUC 的统一阻塞原语》。

为什么不用 AQS 而选择 Treiber Stack:

| 维度 | AQS CLH Queue 变种 | FutureTask Treiber Stack |

|---|---|---|

| 结构 | 双向链表(prev + next) | 单向链表(仅 next) |

| 入队顺序 | FIFO(先入先出) | LIFO(后入先出) |

| 节点摘除 | 支持任意节点 cancel 后摘除(需 prev 指针回溯) | 不支持中间节点摘除(只标记 thread=null) |

| 内存开销 | 较高(每节点 2 个指针 + waitStatus) | 较低(每节点 1 个指针) |

| 适用场景 | 锁竞争(需公平性、可取消) | 结果等待(无公平性要求、节点数少) |

为什么 AQS 是 CLH 的「变种」:经典 CLH 是单向链表 + 自旋,AQS 改为双向链表 + park/unpark,因为需要支持取消语义——取消的节点必须物理摘除,否则后续节点无法被唤醒。核心差异:AQS 是「传递唤醒」(中间断链会死锁),FutureTask 是「广播唤醒」(跳过无效节点即可)。详见AQS CLH Queue 与 FutureTask Treiber Stack 对比。

1 | |

removeWaiter():清理超时/中断的等待节点

移除因超时或中断而不再等待的节点。先置空 thread 标记为"待删除",然后遍历链表跳过这些节点。头节点用 CAS,内部节点直接修改 next 指针(因为 finishCompletion() 会跳过 thread == null 的节点,所以并发遍历无害)。

1 | |

report():终态到返回值/异常的转换

report() 根据终态将 outcome 解释为结果或异常。outcome 是 Object 类型,可能是结果 V 或 Throwable,由 state 决定如何解释。类型安全由状态机保证。

1 | |

| 终态 | report() 行为 | 调用方感知 |

|---|---|---|

| NORMAL | 返回 (V)outcome |

正常获取结果 |

| EXCEPTIONAL | 抛出 ExecutionException((Throwable)outcome) |

catch (ExecutionException) |

| CANCELLED / INTERRUPTED | 抛出 CancellationException |

catch (CancellationException) |

FutureTask 在线程池中的调用链路

每个线程池的 Worker 管理的实质上是 FutureTask。一个标准的可执行可等待任务是一个 RunnableFuture<V>,用成员变量来帮助 Runnable 保存一个 Callable 的返回值,以供 Future 使用。以 invokeAll 为例,完整的调用链路如下:

sequenceDiagram

participant User

participant AbstractExecutorService

participant ThreadPoolExecutor

participant WorkerThread

participant FutureTask

User->>AbstractExecutorService: invokeAll(tasks)

loop for each task

AbstractExecutorService->>AbstractExecutorService: newTaskFor(task)

AbstractExecutorService->>FutureTask: new FutureTask(task)

AbstractExecutorService->>ThreadPoolExecutor: execute(futureTask)

ThreadPoolExecutor->>WorkerThread: 分配任务

WorkerThread->>FutureTask: futureTask.run()

FutureTask->>FutureTask: callable.call()

FutureTask->>FutureTask: set(result)

end

AbstractExecutorService->>AbstractExecutorService: for each future: future.get()

loop for each future

AbstractExecutorService->>FutureTask: future.get()

alt 任务已完成

FutureTask-->>AbstractExecutorService: 立即返回结果

else 任务未完成

FutureTask-->>FutureTask: 挂起等待

FutureTask->>FutureTask: 任务完成后唤醒

FutureTask-->>AbstractExecutorService: 返回结果

end

end

AbstractExecutorService-->>User: 返回所有Future结果invokeAll

invokeAll 是有界的-有界来源于底层的 execute 是有界的,如果一次性提交了超过它界限的任务,即使这些任务是一瞬间执行的-invokeAll 也会触发拒绝,除非任务执行的速度比 for 循环调用底层的 execute 的速度还要快。

如果有得选,我们批量执行任务应该尽量采用 invokeAll,因为它带有这些特殊的代码块:

1 | |

sequenceDiagram

participant Caller as 调用方

participant AES as AbstractExecutorService

participant TPE as ThreadPoolExecutor

participant FT as FutureTask[]

Caller->>AES: invokeAll(tasks, timeout)

rect rgb(240, 248, 255)

Note over AES: 第一阶段:包装任务

loop 遍历 tasks

AES->>FT: newTaskFor(callable)

end

end

rect rgb(255, 248, 240)

Note over AES: 第二阶段:提交任务(有界性来源)

loop 遍历 futures

AES->>TPE: execute(futureTask)

Note right of TPE: 队列满则触发拒绝策略

AES->>AES: 检查超时

alt 已超时

AES-->>Caller: return futures(部分未提交)

end

end

end

rect rgb(240, 255, 240)

Note over AES: 第三阶段:等待完成

loop 遍历 futures

AES->>FT: f.get(remaining, NANOSECONDS)

alt 超时

AES-->>Caller: return futures(部分未完成)

end

end

end

AES->>AES: done = true

AES-->>Caller: return futures(全部完成)

Note over AES: finally: if (!done) cancel 所有任务两种针对 Runnable 的 submit

1 | |

这里面使用到了2种适配器:

1 | |

底层的 execute 本身要求一个包含 callable + result 的 runnbale - FutureTask(向底层的 execute api 适配,向外提供 Future 的 get、cancel 等能力),但是这样的 callable 最初又要经过 RunnableAdapter 从 Runnable 得来(向上向原始的没有返回值的 Runnable 适配)。

可以认为,RunnableAdapter 是一个对象适配器,原始类型是 Runnable,目标类型是 Callable。

我们得到一个 Runnable,要先经过 RunnableAdapter 转成普通 Callable,然后再经 FutureTask 转成 RunnableFuture。

两类底层调用链:

1 | |

sequenceDiagram

participant Caller as 调用方

participant AES as AbstractExecutorService

participant RA as RunnableAdapter

participant FT as FutureTask

participant TPE as ThreadPoolExecutor

rect rgb(240, 248, 255)

Note over Caller,TPE: 路径一:submit(Callable)

Caller->>AES: submit(callable)

AES->>FT: new FutureTask(callable)

AES->>TPE: execute(futureTask)

TPE->>FT: futureTask.run()

FT->>FT: callable.call()

Caller->>FT: future.get()

FT-->>Caller: 返回 callable 的结果

end

rect rgb(255, 248, 240)

Note over Caller,TPE: 路径二:submit(Runnable, result)

Caller->>AES: submit(runnable, result)

AES->>RA: Executors.callable(runnable, result)

Note right of RA: RunnableAdapter 封装

AES->>FT: new FutureTask(runnableAdapter)

AES->>TPE: execute(futureTask)

TPE->>FT: futureTask.run()

FT->>RA: runnableAdapter.call()

RA->>RA: runnable.run()

RA-->>FT: return result

Caller->>FT: future.get()

FT-->>Caller: 返回预设的 result

end至此,我们已经理解了执行器体系的继承关系、任务包装机制和调用链路。

相关适配器一览

newTaskFor 使用 FutureTask 将 Callable/Runnable 适配为 RunnableFuture,这是 ThreadPoolExecutor 体系的核心适配机制。JDK 中还有其他场景的任务适配器:

Executors.RunnableAdapter

RunnableAdapter 将 Runnable + result 适配为 Callable,用于 submit(Runnable, T result) 场景:

1 | |

ForkJoinTask 中的适配器

ForkJoinPool 要求任务必须是 ForkJoinTask 类型,因此需要不同的适配器:

1 | |

ForkJoinPool 中的 RunnableExecuteAdapter

JDK 较新版本中,ForkJoinPool 使用 RunnableExecuteAdapter 处理 execute(Runnable) 场景:

1 | |

适配器对比

| 适配器 | 所在类 | 输入 | 输出 | 使用场景 |

|---|---|---|---|---|

FutureTask |

AbstractExecutorService | Callable<T> 或 Runnable + T |

RunnableFuture<T> |

submit() 返回 Future |

RunnableAdapter |

Executors | Runnable + T |

Callable<T> |

submit(Runnable, T) 内部转换 |

AdaptedRunnable<T> |

ForkJoinTask | Runnable + T |

ForkJoinTask<T> |

ForkJoinPool 处理带返回值的 Runnable |

AdaptedRunnableAction |

ForkJoinTask | Runnable |

ForkJoinTask<Void> |

ForkJoinPool 处理无返回值 Runnable |

AdaptedCallable<T> |

ForkJoinTask | Callable<T> |

ForkJoinTask<T> |

ForkJoinPool 处理 Callable |

RunnableExecuteAdapter |

ForkJoinPool | Runnable |

ForkJoinTask<Void> |

ForkJoinPool.execute(Runnable) |

设计模式共性

这些适配器都遵循适配器模式,核心价值是:

- 接口统一:将不同形式的任务(Runnable、Callable、ForkJoinTask)适配为统一的执行格式

- 语义保持:适配过程中保持原任务的执行语义不变

- 功能增强:为原任务添加 Future 能力(取消、结果获取、状态查询)

classDiagram

%% ========== 接口层 ==========

class Runnable {

<<interface>>

+run() void

}

class Callable~T~ {

<<interface>>

+call() T

}

class Future~T~ {

<<interface>>

+get() T

+cancel(boolean) boolean

+isDone() boolean

}

class RunnableFuture~T~ {

<<interface>>

+run() void

}

class ForkJoinTask~T~ {

<<abstract>>

+exec() boolean

+getRawResult() T

+setRawResult(T) void

note: "增强Future:fork/join+工作窃取"

}

%% ========== 实现层:适配器 ==========

class RunnableAdapter~T~ {

-Runnable task

-T result

+call() T

}

class FutureTask~T~ {

-Callable~T~ callable

+run() void

+get() T

}

class AdaptedRunnable~T~ {

-Runnable runnable

-T resultOnCompletion

+exec() boolean

}

%% ========== 继承关系 ==========

RunnableFuture --|> Runnable

RunnableFuture --|> Future

ForkJoinTask --|> Future

AdaptedRunnable --|> ForkJoinTask

%% ========== 实现关系 ==========

RunnableAdapter ..|> Callable

FutureTask ..|> RunnableFuture

%% ========== 组合关系 ==========

RunnableAdapter o-- Runnable : wraps

FutureTask o-- Callable : wraps

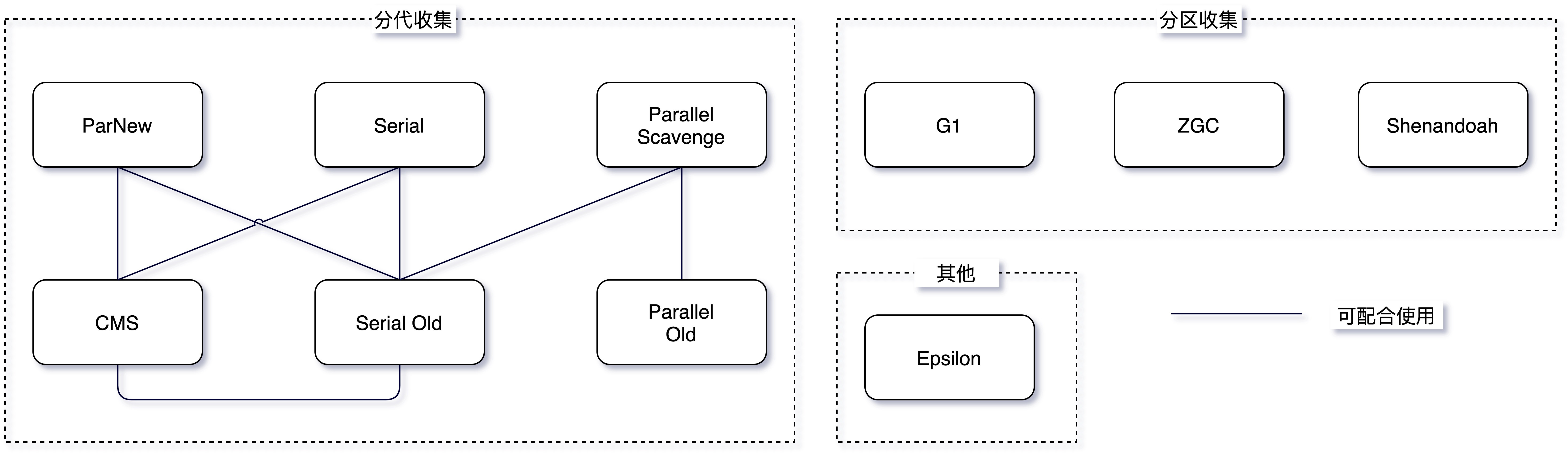

AdaptedRunnable o-- Runnable : wrapsThreadPoolExecutor

前置知识:本节内容依赖对 ThreadPoolExecutor 内部状态机制的理解。如对状态体系不熟悉,请先阅读 核心架构:ctl 与线程池状态机 章节。

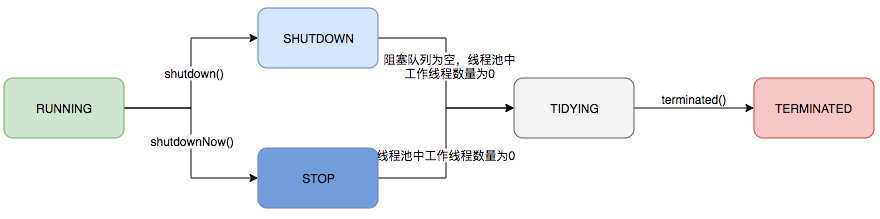

核心架构:ctl 与线程池状态机

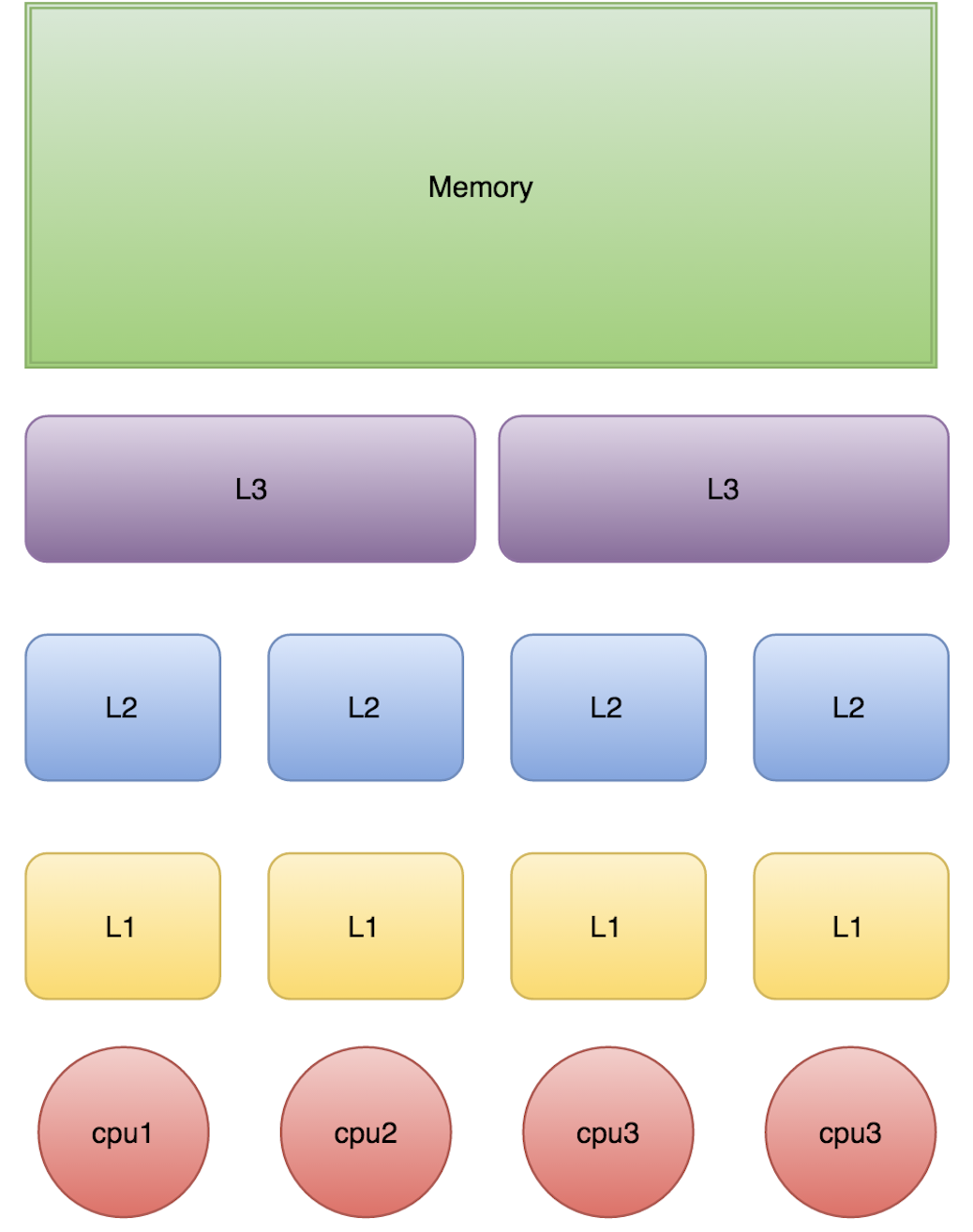

在深入 ThreadPoolExecutor 的状态维护机制之前,有必要先厘清线程池体系中涉及的多层状态体系。线程池架构中存在 4 层独立但相互关联的状态体系:

| 状态体系 | 层级 | 状态数量 | 状态类型 | 核心作用 |

|---|---|---|---|---|

| ThreadPoolExecutor 生命周期状态 | 池级别 | 5 种 | RUNNING → SHUTDOWN/STOP → TIDYING → TERMINATED | 控制线程池整体生命周期 |

| Worker 锁状态 | 工作线程级别 | 3 种 | -1 / 0 / 1 | 保护任务执行期间的中断控制(-1 是 Worker 自定义的初始化状态,0/1 是 AQS 标准锁状态) |

| Java Thread 状态 | 原生线程级别 | 6 种 | NEW / RUNNABLE / BLOCKED / WAITING / TIMED_WAITING / TERMINATED | JVM 线程调度与监控 |

| FutureTask 任务状态 | 任务级别 | 7 种 | NEW → COMPLETING → NORMAL/EXCEPTIONAL/CANCELLED/INTERRUPTED | 异步任务生命周期 |

这 4 层状态相互独立又相互影响。例如:线程池进入 STOP 状态会中断 Worker,Worker 被中断会导致其持有的 Java 线程状态变化;FutureTask 的状态变化则独立于线程池和 Worker,仅反映任务自身的执行进展。理解这些状态的层次关系,有助于在排查线程池问题时准确定位问题所在层级。

下面首先介绍 ThreadPoolExecutor 自身的生命周期状态维护机制。

线程池运行的状态,并不是用户显式设置的,而是伴随着线程池的运行,由内部来维护。线程池内部使用一个变量维护两个值:运行状态(runState)和线程数量(workerCount)。这种将多个字段打包到一个整型变量中的设计称为字段打包(Field Packing),是无锁编程中的一种惯用法。位运算只是实现手段,核心目的是将多个逻辑字段打包到一个物理字段中,实现单次CAS原子更新。

JDK中Field Packing应用案例:

| 类 | 字段 | 打包内容 | 设计目的 |

|---|---|---|---|

ThreadPoolExecutor |

ctl |

高3位runState + 低29位workerCount | 原子更新状态与线程数 |

ForkJoinPool |

ctl |

高16位runState + 中间位workerCount + 其他标志 | 原子更新状态、线程数与并行度 |

ReentrantReadWriteLock.Sync |

state |

高16位读锁计数 + 低16位写锁计数 | 原子更新读写锁计数 |

StampedLock |

state |

高24位版本戳 + 第8位写锁标志 + 低7位读锁计数 | 乐观读锁与版本校验 |

LongAdder.Cell |

状态字 | 竞争标志 + 计数值 | 高并发累加优化 |

在具体实现中,线程池将运行状态(runState)、线程数量(workerCount)两个关键参数的维护放在了一起,如下代码所示:

1 | |

ctl这个AtomicInteger类型,是对线程池的运行状态和线程池中有效线程的数量进行控制的一个字段,它同时包含两部分的信息:线程池的运行状态(runState)和线程池内有效线程的数量(workerCount),高3位保存runState,低29位保存workerCount,两个变量之间互不干扰。

原子更新机制:线程数放低位的设计使得ctl.getAndIncrement()可直接原子增加线程数而不影响高位状态,但必须校验workerCount < CAPACITY防止溢出污染状态位(不要忘记,CAPACITY 作为掩码是一个大整数)。状态变更则需要通过ctl.compareAndSet(oldCtl, ctlOf(newState, workerCountOf(oldCtl)))复合更新,一次CAS同时更新两个字段。

用一个变量去存储两个值,可避免在做相关决策时,出现不一致的情况,不必为了维护两者的一致,而占用锁资源。通过阅读线程池源代码也可以发现,经常出现要同时判断线程池运行状态和线程数量的情况。线程池也提供了若干方法去供用户获得线程池当前的运行状态、线程个数,均使用位运算实现:

1 | |

各状态的二进制表示(Java 7+ 支持 0b 前缀的二进制字面量):

1 | |

位分布示意:

1 | |

状态值按数值大小排列:RUNNING(-1) < SHUTDOWN(0) < STOP(1) < TIDYING(2) < TERMINATED(3),这使得 runStateAtLeast(c, state) 可通过数值比较判断状态是否达到或超过某阈值。

1 | |

| 运行状态 | 状态描述 |

|---|---|

| RUNNING | 能接受新提交的任务,并且也能处理阻塞队列中的任务。 |

| SHUTDOWN | 关闭状态,不再接受新提交的任务,但却可以继续处理阻塞队列中已保存的任务。 |

| STOP | 不能接受新任务,也不处理队列中的任务,会中断正在处理任务的线程。增加了两条措施,是一个更严厉的状态,理论上只要线程被中断完,线程池就可以走向关闭 |

| TIDYING | 所有的任务都已终止了,workerCount (有效线程数) 为0,这个状态的意思不是整理中,而是整理完了。 |

| TERMINATED | 在terminated() 方法执行完后进入该状态。 |

其中 running 既是初始态,也是中间态,所以才有private final AtomicInteger ctl = new AtomicInteger(ctlOf(RUNNING, 0));作为初始化块的一部分。

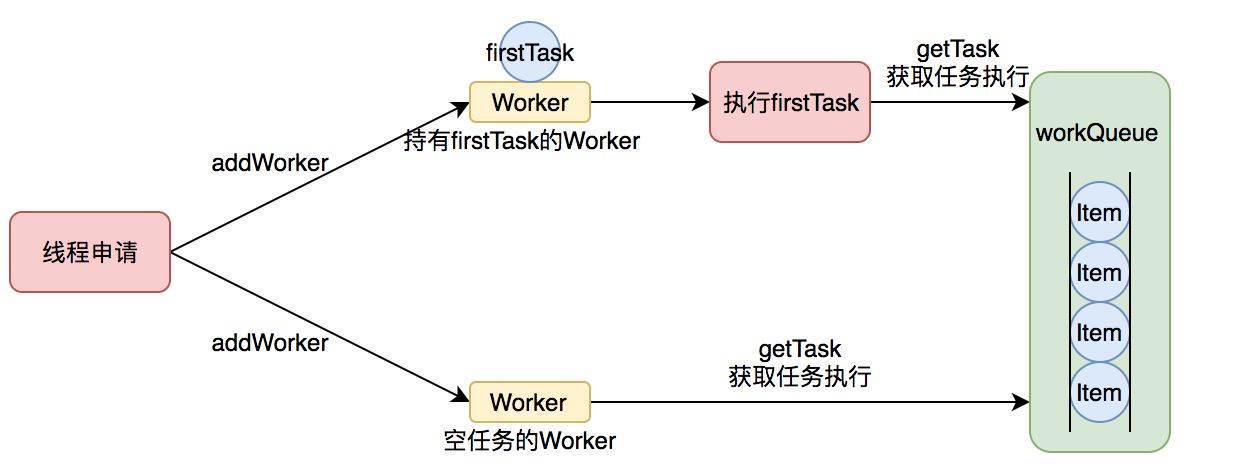

ThreadPoolExecutor 如何管理任务

设计哲学:任务与线程解耦

线程池的本质是对任务和线程的管理,而做到这一点最关键的思想就是将任务和线程两者解耦,不让两者直接关联,才可以做后续的分配工作。线程池采用生产者消费者模式,通过阻塞队列实现任务缓冲。

任务执行存在两种路径:

| 路径 | 触发条件 | 机制 |

|---|---|---|

| firstTask 路径 | 创建新 Worker 时(核心线程未满,或队列满但非核心线程未满) | 任务作为 firstTask 直接传入 Worker,省去入队再出队的开销 |

| 队列路径 | 任务入队后 | 空闲 Worker 通过 getTask() 从队列 poll/take 获取任务 |

1 | |

任务提交入口:submit 与 execute

submit 方法(AbstractExecutorService 提供):

1 | |

execute 方法(ThreadPoolExecutor 核心):

图中空任务的 worker 看下面对 execute 的入队分支的注释。

1 | |

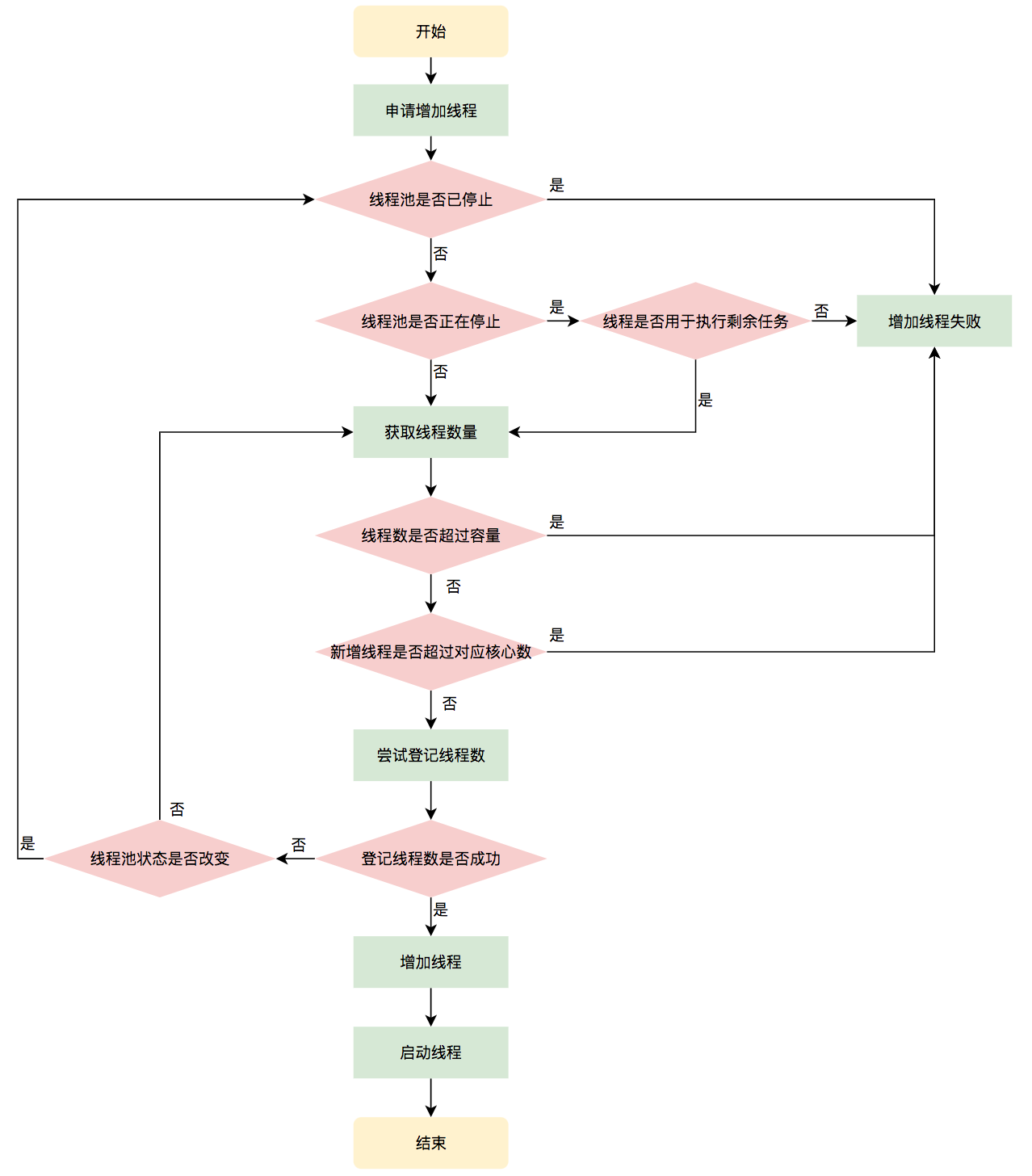

创建工作线程:addWorker

addWorker 是 execute 三步调度策略的核心支撑方法,负责创建并启动工作线程。

Worker 可以被认为是线程和锁的结合体,它的使命就是不断地把 runnable/command/task 从缓冲队列里拿出来,放在自己的 thread 里执行:

1 | |

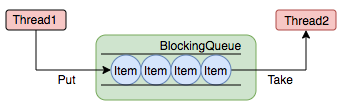

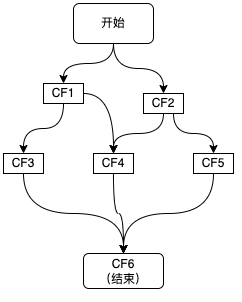

任务缓冲:阻塞队列

阻塞队列(BlockingQueue)是一个支持两个附加操作的队列。这两个附加的操作是 (阻塞的本质即为此):在队列为空时,获取元素的线程会等待队列变为非空。当队列满时,存储元素的线程会等待队列可用。 阻塞队列常用于生产者和消费者的场景,生产者是往队列里添加元素的线程,消费者是从队列里拿元素的线程。阻塞队列就是生产者存放元素的容器,而消费者也只从容器里拿元素。

| 名称 | 描述 |

|---|---|

| ArrayBlockingQueue | 一个用数组实现的有界阻塞队列,此队列按照先进先出(FIFO)的原则对元素进行排序。支持公平锁和非公平锁。 |

| DelayQueue | 一个基于 PriorityQueue(非阻塞)实现延迟获取的无界队列,元素必须实现 Delayed 接口。在创建元素时可指定延迟时间,只有延时期满后才能从队列中获取元素。 |

| LinkedBlockingDeque | 一个由链表结构组成的双向阻塞队列。队列头部和尾部都可以添加和移除元素,多线程并发时,可以将锁的竞争最多降到一半。 |

| LinkedBlockingQueue | 一个由链表结构组成的有界队列,此队列按照先进先出(FIFO)的原则对元素进行排序。此队列的默认长度为Integer.MAX_VALUE,所以默认创建的该队列有容量危险。 |

| LinkedTransferQueue | 一个由链表结构组成的无界阻塞队列,相当于其它队列,LinkedTransferQueue队列多了transfer和tryTransfer方法。 |

| PriorityBlockingQueue | 一个支持线程优先级排序的无界队列,默认自然序进行排序,也可以自定义实现compareTo()方法来指定元素排序规则,不能保证同优先级元素的顺序。 |

SynchronousQueue |

一个不存储元素的阻塞队列,每一个put操作必须等待take操作,否则不能添加元素。支持公平锁和非公平锁。SynchronousQueue的一个使用场景是在线程池里。Executors.newCachedThreadPool()就使用了SynchronousQueue,这个线程池根据需要(新任务到来时)创建新的线程,如果有空闲线程则会重复使用,线程空闲了60秒后会被回收。 |

DelayedWorkQueue |

ScheduledThreadPoolExecutor 的内部类,基于二叉堆实现。是延时线程池的刚需组件:只有通过 DelayedWorkQueue 的 take() 阻塞到任务到期,才能在复用 ThreadPoolExecutor Worker 机制的同时实现延时调度。不在公开 API 之列。 |

阻塞队列的详细选型指南(锁实现差异、使用示例、性能对比)见下文 阻塞队列选型指南 章节。

阻塞队列选型指南

锁实现差异分析:

各阻塞队列在锁策略上有本质差异,这直接影响并发性能和适用场景。

| 队列 | 锁策略 | 锁数量 | 设计原因 |

|---|---|---|---|

ArrayBlockingQueue |

单锁 | 1 把 ReentrantLock | 数组实现,put/take 需同时维护 count、head、tail,单锁保证原子性 |

LinkedBlockingQueue |

双锁(读写分离) | 2 把 ReentrantLock | 链表实现,写操作修改 tail,读操作修改 head,互不干扰 |

LinkedBlockingDeque |

单锁 | 1 把 ReentrantLock | 双端操作可能同时涉及头尾,无法分离 |

PriorityBlockingQueue |

单锁 | 1 把 ReentrantLock | 堆调整涉及整个数组,读写无法分离 |

DelayQueue |

单锁 | 1 把 ReentrantLock | 基于 PriorityBlockingQueue,堆操作无法分离 |

SynchronousQueue |

无锁 CAS | 无显式锁 | 不存储元素,直接传递,CAS 实现匹配 |

LinkedTransferQueue |

无锁 CAS | 无显式锁 | 链表 + 松弛操作,CAS 实现无锁算法 |

为什么 LinkedBlockingQueue 能用双锁?

1 | |

链表的物理结构决定了读写操作修改的是不同的内存位置:

- 写操作:修改

tail.next和tail引用 - 读操作:修改

head和head.next引用

两者互不干扰,因此可以分离锁。这是数据结构特性决定的。

为什么 ArrayBlockingQueue 不能用双锁?

1 | |

数组的环形结构导致读写操作存在共享状态:

- count 计数器:put 需要检查是否满(count == capacity),take 需要检查是否空(count == 0)

- 指针回绕:putIndex 和 takeIndex 都会在数组末尾回绕到 0,可能相遇

- 容量判断:判断满/空需要同时看到 count、takeIndex、putIndex 的一致状态

如果用双锁,put 和 take 同时修改 count,会出现竞态条件。即使使用 AtomicInteger,也无法保证 count 与指针的一致性。

SynchronousQueue 为什么不需要锁?

1 | |

SynchronousQueue 不存储任何元素,它的核心是"直接传递":

- 生产者线程将元素直接交给消费者线程

- 如果没有消费者,生产者等待

- 如果没有生产者,消费者等待

- 整个过程通过 CAS 操作完成线程间匹配,无需维护数据结构

选型建议:

| 场景 | 推荐队列 | 理由 |

|---|---|---|

| 通用生产消费(首选) | ArrayBlockingQueue | 预分配数组,缓存友好,无 GC 压力,实测性能稳定 |

| 高并发 + 队列长期非空 | LinkedBlockingQueue(指定容量) | 双锁优势显现,但须指定容量 |

| 任务直接执行,无缓冲 | SynchronousQueue | 无锁 CAS,直接传递 |

| 需要优先级 | PriorityBlockingQueue | 堆排序,无锁替代方案少 |

| 延迟调度 | DelayQueue | 时间排序,无可替代 |

flowchart TD

A[选择阻塞队列] --> B{是否需要存储元素?}

B -->|否| C[SynchronousQueue]

B -->|是| D{是否需要延迟/优先级?}

D -->|延迟| E[DelayQueue]

D -->|优先级| F[PriorityBlockingQueue]

D -->|否| G[ArrayBlockingQueue<br/>首选-缓存友好]

G --> H{需要双锁?}

H -->|否| I[使用 ArrayBlockingQueue]

H -->|是| J{LinkedBlockingQueue}

J --> K[指定容量-推荐]

J --> L[默认容量-OOM风险]

style C fill:#F0E68C

style E fill:#DDA0DD

style F fill:#FFB6C1

style G fill:#90EE90

style I fill:#90EE90

style K fill:#87CEEB

style L fill:#FF6347ThreadPoolExecutor 任务拒绝

当线程池的任务缓存队列已满并且线程池中的线程数目达到 maximumPoolSize 时,如果还有任务到来就会采取任务拒绝策略。

拒绝策略的两种触发场景:

| 触发场景 | 描述 | 常见原因 |

|---|---|---|

| 线程池饱和 | 队列已满 + 线程数达到 maximumPoolSize | 任务提交速率持续高于处理速率 |

| 线程池关闭 | 调用 shutdown() 或 shutdownNow() 后仍尝试提交任务 |

业务逻辑未正确检查线程池状态 |

常见误区:许多开发者认为拒绝策略只在"线程池满了"时触发,但实际上线程池关闭后尝试提交任务同样会触发拒绝策略。如果业务逻辑未正确检查线程池状态(通过

isShutdown()或isTerminated()),可能导致意外的任务丢失。

强制触发线程中断与拒绝的完整场景汇总:

根据Java线程池的实现,以下场景会强制触发线程中断或拒绝新任务:

主动触发(用户代码显式调用):

- shutdownNow():强制中断所有工作线程

- Future.cancel(true):强制中断指定任务的执行线程

系统被动触发(内部机制自动触发):

- 线程池饱和:队列满+达最大线程数 -> 触发 RejectedExecutionHandler

- awaitTermination超时:shutdown后等待超时 -> 强制关闭

- ScheduledFutureTask异常:周期任务未捕获异常 -> 终止调度

- tryTerminate自旋中断:线程池终止过程中 -> 中断空闲Worker

拒绝策略的四种内置实现:

- AbortPolicy:抛出 RejectedExecutionException

- CallerRunsPolicy:由调用者线程执行

- DiscardPolicy:静默丢弃

- DiscardOldestPolicy:丢弃最老任务

最佳实践:

- 不要依赖强制中断来停止任务,任务应支持检查中断标志

- 优先使用cancel(false)让任务自然完成

- 合理选择拒绝策略,根据业务对任务丢失的容忍度决定

1 | |

拒绝策略触发流程:

sequenceDiagram

participant Client as 客户端

participant TPE as ThreadPoolExecutor

participant Queue as 阻塞队列

participant Handler as RejectedExecutionHandler

Client->>TPE: execute(task)

TPE->>TPE: 检查线程数 < corePoolSize?

alt 线程数 < corePoolSize

TPE->>TPE: 创建核心线程执行

else 线程数 >= corePoolSize

TPE->>Queue: offer(task)

alt 队列未满

Queue-->>TPE: true

TPE-->>Client: 任务入队成功

else 队列已满

Queue-->>TPE: false

TPE->>TPE: 检查线程数 < maximumPoolSize?

alt 线程数 < maximumPoolSize

TPE->>TPE: 创建非核心线程执行

else 线程数 >= maximumPoolSize

TPE->>Handler: rejectedExecution(task, executor)

Note over Handler: 执行拒绝策略

end

end

end拒绝策略对比图:

graph TB

subgraph 拒绝策略对比

A[AbortPolicy] --> A1[抛出异常]

A1 --> A2[调用方感知]

A2 --> A3[适合:需要明确处理拒绝的场景]

B[CallerRunsPolicy] --> B1[调用者执行]

B1 --> B2[提供反压]

B2 --> B3[适合:不能丢弃任务的场景]

C[DiscardPolicy] --> C1[静默丢弃]

C1 --> C2[无感知]

C2 --> C3[适合:允许丢弃且无需感知]

D[DiscardOldestPolicy] --> D1[丢弃最老任务]

D1 --> D2[新任务优先]

D2 --> D3[适合:新任务更重要的场景]

end

style A fill:#FF6B6B

style B fill:#4ECDC4

style C fill:#95A5A6

style D fill:#F39C12ThreadPoolExecutor 如何管理线程

术语定义:线程回收 vs 资源回收

线程池文档中涉及两种"回收"概念,需明确区分:

| 术语 | 主体 | 行为 | 触发者 |

|---|---|---|---|

| 线程回收 | 线程池 | 从 workers 集合移除线程引用,让线程退出运行循环 | interruptIdleWorkers / getTask 超时 |

| 资源回收 | JVM/GC | 回收 Thread 对象及关联对象的内存 | 垃圾收集器 |

线程回收的本质:线程池层面的资源管理行为。线程池通过 interruptIdleWorkers() 发起回收请求,或 getTask() 超时返回 null 触发线程退出,最终由 processWorkerExit() 执行清理(移除 workers 引用、更新计数)。线程对象本身的内存回收是 JVM 的职责,不属于线程池"回收"范畴。

Javadoc 术语印证:ForkJoinPool 的 common pool 文档明确使用 “reclaim”:

“its threads are slowly reclaimed during periods of non-use, and reinstated upon subsequent use”

getTask() 返回 null 会让线程退出,走入 processWorkerExit。

ThreadPoolExecutor没有"核心线程"这种线程类型或线程属性。所有 Worker 结构相同,不存在标记某个线程为"核心"的字段。所谓的"核心线程"只是 workerCount 中属于 corePoolSize 范围内的计数——这是一个动态边界,同一个线程在不同时刻可能处于边界内或边界外。线程是否因 idle 退出是 getTask() 每次循环的动态决策:当 workerCount > corePoolSize 时使用 poll(keepAliveTime),超时返回 null 导致线程退出。可以认为这部分线程天然带超时,超时机制对其无条件生效,只受 keepAliveTime 控制。只要 getTask 得到 null,就不会回到 while 循环,而进入 processWorkerExit。当 workerCount <= corePoolSize 时使用 take() 无限阻塞,线程不会因 idle 退出。若 allowCoreThreadTimeOut=true,则所有线程均会因 idle 超时退出。

mainLock:线程池的全局互斥锁

ThreadPoolExecutor 使用 mainLock(ReentrantLock)保护线程池的核心数据结构和同步点。

mainLock 保护的对象:

| 保护对象 | 类型 | 原因 |

|---|---|---|

workers |

HashSet<Worker> |

HashSet 非线程安全,增删遍历需互斥 |

largestPoolSize |

int |

记录历史最大线程数,多线程更新需同步 |

completedTaskCount |

long |

任务完成总数累加,需原子性保证 |

termination |

Condition |

状态转换时的唤醒信号,需与锁配合 |

graph TB

mainLock[mainLock<br/>ReentrantLock]

subgraph 保护对象

workers[workers<br/>HashSet Worker]

largestPoolSize[largestPoolSize<br/>int]

completedTaskCount[completedTaskCount<br/>long]

termination[termination<br/>Condition]

end

subgraph 使用场景

addWorker[addWorker<br/>创建线程]

addWorkerFailed[addWorkerFailed<br/>创建失败]

processWorkerExit[processWorkerExit<br/>线程退出]

interruptIdleWorkers[interruptIdleWorkers<br/>中断空闲线程]

tryTerminate[tryTerminate<br/>状态转换]

getActiveCount[getActiveCount 等<br/>监控统计]

end

mainLock --> workers

mainLock --> largestPoolSize

mainLock --> completedTaskCount

mainLock --> termination

addWorker --> mainLock

addWorkerFailed --> mainLock

processWorkerExit --> mainLock

interruptIdleWorkers --> mainLock

tryTerminate --> mainLock

getActiveCount --> mainLockmainLock 的使用场景:

| 场景 | 方法 | 操作内容 |

|---|---|---|

| 创建线程 | addWorker() |

Worker 加入 workers、更新 largestPoolSize、状态重检 |

| 创建失败 | addWorkerFailed() |

从 workers 移除、回滚 workerCount |

| 线程退出 | processWorkerExit() |

累加 completedTaskCount、从 workers 移除 |

| 中断空闲线程 | interruptIdleWorkers() |

遍历 workers、tryLock 检测空闲 |

| 状态转换 | tryTerminate() |

TIDYING→TERMINATED、termination.signalAll() |

| 监控统计 | getActiveCount() 等 |

遍历 workers 统计活跃线程数 |

TOCTOU 问题与状态重检:

addWorker() 中,CAS 增加 workerCount 后、获取 mainLock 前,其他线程可能调用 shutdown() 或 shutdownNow() 改变状态。mainLock 作为同步点,允许加锁后重新检查状态,避免在 SHUTDOWN 后错误添加 Worker。

1 | |

为何不用读写锁:

workers的修改操作(增删 Worker)主要发生在线程创建、退出、关闭阶段- 遍历操作主要发生在监控方法(

getActiveCount、getPoolSize等)和关闭阶段 - 正常运行期间,这些操作竞争不频繁,读写锁的额外开销(维护读写状态、支持锁降级)不值得

mainLock 与 ctl 的分工:

ctl(AtomicInteger):高 3 位运行状态 + 低 29 位线程数,使用 CAS 无锁更新,自身保证原子性mainLock:保护以下三类对象:- 非线程安全数据结构:

workers(HashSet) - volatile 变量的复合操作:

largestPoolSize、completedTaskCount—— volatile 仅保证可见性,不保证复合操作(如max = Math.max(max, size))的原子性。实际上这种对 volatile 的复合操作需要使用同步块的设计大量遍布于 java 的日常实践中,是一种基础原则。 - 同步原语:

termination(Condition)—— 需与锁配合使用

- 非线程安全数据结构:

两者协调:CAS 先更新 ctl,成功后再获取 mainLock 修改受保护对象。若 mainLock 获取后状态检查失败,则回滚 ctl(decrementWorkerCount())。

线程数保量机制

corePoolSize 的三重语义

corePoolSize 在线程池中扮演三个角色:

- 创建阈值:

execute()方法中,当workerCount < corePoolSize时,优先创建新线程直接执行任务,绕过入队。 - 超时策略分界:

getTask()方法中,workerCount <= corePoolSize且allowCoreThreadTimeOut=false时使用take()无限阻塞(不会因超时返回 null,从而维持线程数量不低于corePoolSize);workerCount > corePoolSize时使用poll(keepAliveTime),超时则线程退出。 - 退出检查下限:

processWorkerExit()方法中,正常退出时以corePoolSize作为最小保有量检查,低于此值则补充线程。

线程增加路径

| 路径 | 触发点 | addWorker 参数 |

说明 |

|---|---|---|---|

| 正常增加-核心 | execute() 步骤1 |

(command, true) |

workerCount < corePoolSize 时 |

| 正常增加-非核心 | execute() 步骤3 |

(command, false) |

队列已满且 workerCount < maximumPoolSize 时 |

| 正常增加-补偿 | execute() 步骤2 |

(null, false) |

入队后发现 workerCount == 0 时 |

| 异常增加 | processWorkerExit() |

(null, false) |

异常退出后补充,保量 |

线程退出路径

| 路径 | 触发点 | 是否检查 min |

结果 |

|---|---|---|---|

| 正常退出 | getTask() 返回 null |

是 | 若 workerCount >= min 则不补充,否则补充 |

| 异常退出 | 任务抛未捕获异常 | 否 | 直接调用 addWorker(null, false) 补充 |

即时补偿机制:异常退出时(completedAbruptly=true),processWorkerExit() 跳过 min 检查,立即调用 addWorker(null, false) 尝试补充线程。这是即时补偿而非延迟补偿——不等待下次任务提交。

即时补偿不等于保证达成。addWorker 可能因以下原因失败:线程工厂返回 null、CAS 竞争失败、已达 maximumPoolSize。此外,allowCoreThreadTimeOut=true 时核心线程可因空闲超时退出,不触发补偿。因此 corePoolSize 是目标保有量而非硬性下限,线程池在任何时刻都不保证 workerCount >= corePoolSize。补偿失败时,线程数短暂低于 corePoolSize,由后续 execute() 步骤1(workerCount < corePoolSize 时优先创建)作为兜底策略。

allowCoreThreadTimeOut 的作用

allowCoreThreadTimeOut 是改变核心线程生命周期策略的关键也是唯一的开关:

getTask()中的timed变量:boolean timed = allowCoreThreadTimeOut || wc > corePoolSizeprocessWorkerExit()中的min变量:int min = allowCoreThreadTimeOut ? 0 : corePoolSize

当 allowCoreThreadTimeOut=true 时:

- 所有线程(无论是否达到

corePoolSize)都使用poll(keepAliveTime)等待任务 - 正常退出时

min=0,不强制保有核心线程 - 队列非空时

min=1,至少保留一个消费者

结论

corePoolSize 是目标保有量而非硬性下限。线程池在任何时刻都不保证 workerCount >= corePoolSize,原因包括:

allowCoreThreadTimeOut=true时核心线程可因空闲超时退出- 任务执行异常导致线程退出,

processWorkerExit()虽会补充但可能失败 - 线程工厂返回 null 导致

addWorker失败

graph TB

subgraph 增加路径[线程增加路径]

exec1["execute() 步骤1<br/>wc < corePoolSize"]

exec2["execute() 步骤2<br/>入队后 wc == 0"]

exec3["execute() 步骤3<br/>队列满"]

abrupt["processWorkerExit()<br/>异常退出"]

add1["addWorker(cmd, true)<br/>🆕 NEW → RUNNABLE"]

add2["addWorker(null, false)<br/>🆕 NEW → RUNNABLE"]

add3["addWorker(cmd, false)<br/>🆕 NEW → RUNNABLE"]

add4["addWorker(null, false)<br/>🆕 NEW → RUNNABLE"]

exec1 --> add1

exec2 --> add2

exec3 --> add3

abrupt --> add4

end

subgraph 退出路径[线程退出路径]

gettask["getTask() 返回 null<br/>🔚 即将 TERMINATED"]

process["processWorkerExit():<br/>if (!completedAbruptly) {<br/> min = allowCoreThreadTimeOut<br/> ? 0 : corePoolSize<br/> if (wc >= min) return;<br/>}<br/>addWorker(null, false)"]

result["补充成功: wc 恢复<br/>补充失败: wc < min<br/>☠️ TERMINATED"]

gettask --> process

process --> result

end

subgraph 配置影响[allowCoreThreadTimeOut 影响点]

timed["getTask(): timed = allowCoreThreadTimeOut || wc > corePoolSize"]

mincalc["processWorkerExit(): min = allowCoreThreadTimeOut ? 0 : corePoolSize"]

behavior_false["false (默认): workerCount <= corePoolSize 时使用 take() 无限阻塞<br/>⏳ WAITING"]

behavior_true["true: 所有线程使用 poll(timeout),核心线程可因空闲超时退出<br/>⏱️ TIMED_WAITING"]

end线程执行

线程的执行强依赖于 Worker 本身的实现。

Worker 类定义与锁状态

Worker 与 Thread 的关系:Worker 不是线程,它是一个包装器。

1 | |

newThread(this) 中,this 是 Worker 对象本身。因为 Worker 实现了 Runnable,所以 Worker 是 Thread 的 target。

| 概念 | 实际角色 |

|---|---|

| Worker | 包装器 + Runnable,封装任务获取和执行逻辑 |

| Worker.thread | 真正的线程对象,由 ThreadFactory 创建 |

| Worker 与 Thread | 组合关系:Worker 持有 Thread,同时也是 Thread 的 target |

| Worker 的锁 | 不可重入互斥锁,基于 AQS 实现 |

互相引用关系:

flowchart TB

subgraph Worker["Worker<br>extends AQS<br>implements Runnable"]

W_FIELDS["Worker 字段:"]

W_THREAD["- thread: Thread"]

W_TASK["- firstTask: Runnable"]

W_STATE["- state: int"]

W_COMPLETED["- completedTasks: long"]

W_METHODS["Worker 方法:"]

W_RUN["+ run() { runWorker(this) }"]

end

subgraph Thread["Thread"]

T_FIELDS["Thread 字段:"]

T_TARGET["- target: Runnable"]

T_METHODS["Thread 方法:"]

T_RUN["+ run() { target.run() }"]

end

%% Worker 持有 Thread 引用

W_THREAD -->|持有| T_TARGET

%% Thread.target 指向 Worker

T_TARGET -.->|指向| W_FIELDS

%% 构造流程

W_FIELDS@{ shape: braces}

subgraph Construction["构造流程"]

C1["new Worker(firstTask)"]

C2["setState(-1)"]

C3["this.thread = getThreadFactory.newThread(this)"]

C4["Thread.target = this"]

C1 --> C2 --> C3 --> C4

end

%% 执行链路

C4 -.->|启动| T_RUN

T_RUN -.->|调用| W_RUNWorker.thread → Thread(持有引用)

Thread.target → Worker(持有引用,因为 Worker 实现了 Runnable)

循环引用与 GC 回收分析:

flowchart LR

subgraph GC["GC Roots 可达性分析"]

APP["应用程序引用<br/>executor"] --> TPE["ThreadPoolExecutor"]

TPE --> WORKERS["workers"]

WORKERS --> W["Worker"]

W -->|"thread"| T["Thread"]

T -.->|"target"| W

end

Note1["循环引用不导致泄漏:JVM 用可达性分析,非引用计数"]

Note2["ThreadLocal 泄漏需警惕:任务结束务必调用 remove()"]

style Problem fill:#ffebee,stroke:#f44336,stroke-width:2px

style Solution fill:#e8f5e9,stroke:#4caf50,stroke-width:2px关键洞察:

- Worker-Thread 循环引用本身安全:GC 可达性分析能正确处理

- ThreadLocal 泄漏需要警惕:线程池中线程复用,ThreadLocal 数据可能残留

- 最佳实践:在线程池任务中使用 ThreadLocal 时,务必在

finally块中调用remove()

执行链路:

1 | |

这种设计让 Worker 既能控制线程的中断行为(通过 AQS 锁状态),又能将任务执行委托给线程池的 runWorker 方法。

1 | |

Worker 锁对中断的保护机制:

核心结论:Worker 继承 AQS,利用 state 字段区分空闲/忙碌状态,实现对执行中任务的中断保护。

| state | 线程状态 | tryLock | 是否被中断 |

|---|---|---|---|

| 1 | 执行任务中 | 失败 | 不中断(受保护) |

| 0 | 阻塞在 getTask() 等待任务 | 成功 | 可中断 |

所谓"空闲线程"即阻塞在队列上等待任务的线程。Worker线程只有两种状态:执行任务中,或阻塞在getTask()等待任务,不存在"空闲但不阻塞"的第三种状态。shutdown() 通过 tryLock() 识别空闲线程并发送中断,唤醒它们检查线程池状态后退出。执行中的线程因 tryLock 失败被跳过,任务得以正常完成。

Worker 类注释中提到"这可以防止本来用于唤醒等待任务的工作线程的中断,却错误地中断正在执行的任务"。具体保护机制如下:

shutdown() 调用 interruptIdleWorkers() 时,通过 tryLock() 检测 Worker 锁状态:

1 | |

tryLock() 调用 tryAcquire(),其实现决定了谁能被中断:

这就是注释所说的"防止错误中断":shutdown() 发送的中断信号只作用于空闲线程(唤醒它们检查池状态),不会干扰正在执行的任务。所谓唤醒,是唤醒阻塞在 getTask() 中的线程,让它们检查线程池状态后决定是否退出。被中断后,线程会检查 runState:若为 STOP 状态则直接退出;若为 SHUTDOWN 状态,队列为空时才退出,队列非空时可能继续处理完剩余任务。

Worker 生命周期状态图:

stateDiagram-v2

[*] --> Created: new Worker(firstTask)

Created --> Initialized: setState(-1)<br/>禁止中断

Initialized --> Started: thread.start()

Started --> Running: runWorker(this)

Running --> Unlocked: w.unlock()<br/>允许中断

state Running {

Unlocked --> WaitingTask: getTask()

WaitingTask --> GotTask: task != null

WaitingTask --> NoTask: task == null

GotTask --> Locked: w.lock()

Locked --> Executing: task.run()

Executing --> Unlocked: w.unlock()

}

NoTask --> Exiting: processWorkerExit()

Exiting --> [*]: 线程终止

note right of Created

Worker 构造时:

1. setState(-1) 禁止中断

2. 保存 firstTask

3. 通过 ThreadFactory 创建线程

end note

note right of WaitingTask

getTask() 返回 null 的情况:

1. 线程数 > maximumPoolSize

2. 线程池 STOP 状态

3. 线程池 SHUTDOWN 且队列空

4. 等待超时

end noteWorker 锁状态转换图:

graph TD

subgraph Worker锁状态

A[state = -1<br/>初始化状态] -->|w.unlock| B[state = 0<br/>空闲状态]

B -->|w.lock| C[state = 1<br/>执行任务中]

C -->|w.unlock| B

end

subgraph 锁状态含义

D[-1: 禁止中断<br/>Worker刚创建]

E[0: 允许中断<br/>Worker空闲等待任务]

F[1: 正在执行任务<br/>不应被中断]

end

subgraph 中断规则

G[interruptIfStarted] --> H{getState >= 0?}

H -->|是| I[可以中断]

H -->|否| J[不能中断]

end

style A fill:#FFB6C1

style B fill:#90EE90

style C fill:#87CEEBWorker 锁的三大功能:

- 状态标记:

isLocked()判断 Worker 是否正在执行任务 - 中断保护:

interruptIfStarted()检查state >= 0才允许中断 - 并发控制:

interruptIdleWorkers()用tryLock()判断是否可安全中断

为什么必须用不可重入锁?

关键在于 setCorePoolSize 等池控制方法内部会调用 interruptIdleWorkers:

1 | |

假设用户任务中调用线程池控制方法:

1 | |

如果用 ReentrantLock(可重入):

1 | |

使用 不可重入锁:

1 | |

不可重入的实现原理:

对比 Worker 与 ReentrantLock 的 tryAcquire 实现:

1 | |

不可重入的实现:就是不写 else if (current == getExclusiveOwnerThread()) 这段代码。Worker 的 tryAcquire 只有前半部分。

为什么选择 AQS 而非 volatile + CAS?

AQS 的 compareAndSetState 本质就是 volatile + Unsafe CAS:

1 | |

所以 Worker 实际上就在用 volatile int + CAS,AQS 只是做了封装。选择 AQS 是 Doug Lea 的工程风格——复用已有框架,避免手写 Unsafe 获取和反射。这不是"必须",是"够用且简洁"。AQS 的 exclusiveOwnerThread 对 Worker 来说不重要(不可重入锁不需要记录持有者)。

空闲线程的两种等待状态:

1 | |

| 场景 | 阻塞方法 | Java Thread 状态 | 唤醒条件 |

|---|---|---|---|

| 核心线程(不允许超时) | queue.take() |

WAITING | 队列有任务 或 被中断 |

| 非核心线程 / 允许超时 | queue.poll(timeout) |

TIMED_WAITING | 队列有任务 或 超时 或 被中断 |

shutdown vs shutdownNow 的中断策略对比:

两种关闭方法使用不同的中断函数,对 Worker 锁的态度截然不同:

| 方法 | 状态转换 | 中断函数 | 是否检查锁 | state=1 能否中断 |

|---|---|---|---|---|

shutdown() |

RUNNING → SHUTDOWN | interruptIdleWorkers() |

tryLock() 检查 |

否 |

shutdownNow() |

RUNNING → STOP | interruptWorkers() |

不检查 | 是 |

1 | |

Worker 中断决策流程图:

flowchart TD

subgraph shutdown决策

A1[shutdown()] --> B1[interruptIdleWorkers()]

B1 --> C1{w.tryLock()?}

C1 -->|state=0 成功| D1[t.interrupt()]

C1 -->|state=1 失败| E1[跳过,不中断]

D1 --> F1[空闲线程退出]

end

subgraph shutdownNow决策

A2[shutdownNow()] --> B2[interruptWorkers()]

B2 --> C2{state >= 0?}

C2 -->|state=0 或 1| D2[t.interrupt()]

C2 -->|state=-1| E2[跳过,未启动]

D2 --> F2[所有已启动线程中断]

end关键洞察:Worker 的 AQS 锁只保护 shutdown() 的优雅关闭,不保护 shutdownNow() 的强制关闭。STOP 状态的"更严厉"体现在:无视 Worker 锁,强制中断所有已启动线程。

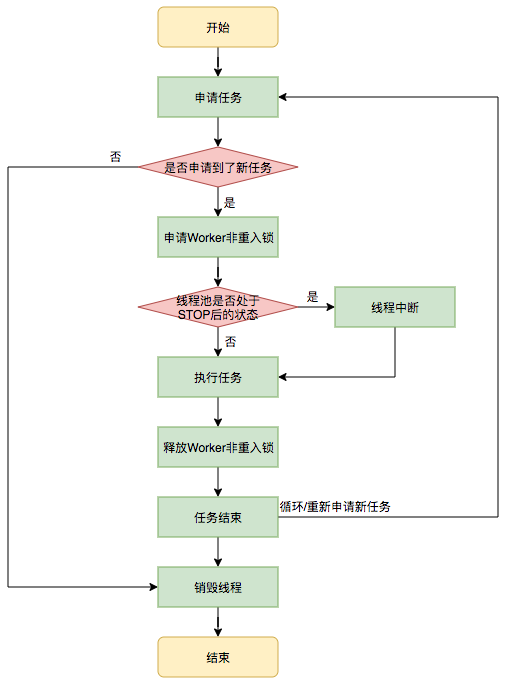

runWorker 执行流程详解:

sequenceDiagram

participant TPE as ThreadPoolExecutor

participant W as Worker

participant T as Thread

participant Q as BlockingQueue

Note over W: 构造函数: setState(-1)

TPE->>W: addWorker(task, core)

TPE->>T: thread.start()

T->>W: run()

W->>TPE: runWorker(this)

TPE->>W: w.unlock() // setState(0)

Note over W: 现在允许中断

loop 任务循环

alt 有 firstTask

TPE->>TPE: task = firstTask

else 无 firstTask

TPE->>Q: getTask()

Q-->>TPE: task 或 null

end

alt task != null

TPE->>W: w.lock() // setState(1)

Note over W: 执行期间不应中断

TPE->>TPE: beforeExecute(thread, task)

TPE->>T: task.run()

TPE->>TPE: afterExecute(task, thrown)

TPE->>W: w.unlock() // setState(0)

TPE->>W: completedTasks++

else task == null

Note over TPE: 退出循环

end

end

TPE->>TPE: processWorkerExit(w, completedAbruptly)

Note over W: Worker 生命周期结束runWorker 主循环

Worker 的 run 方法委托给线程池的 runWorker 执行。执行流程如图所示,包含以下关键步骤:

- 开始:线程启动-这个线程是在 addWorker 方法里被启动的。

- 申请任务:首次使用 firstTask,后续通过 getTask() 获取

- 是否申请到了新任务:判断 task 是否为 null

- 申请Worker非重入锁:w.lock(),state 从 0 → 1

- 线程池是否至少于STOP后状态:检查是否需要中断

- 执行任务:调用 task.run()

- 释放Worker非重入锁:w.unlock(),state 从 1 → 0

- 任务结束:完成一次任务,继续循环或退出

- 到线终线程:processWorkerExit()

- 结束:线程终止

1 | |

SHUTDOWN 与 STOP 是两种平行的关闭策略

| 状态 | 设计意图 | 任务处理 | 中断策略 |

|---|---|---|---|

| SHUTDOWN | 优雅关闭 | 处理完队列中的任务 | 仅中断空闲线程 |

| STOP | 立即关闭 | drainQueue() 并返回未执行任务 | 中断所有线程(包括执行中的) |

设计为平行状态的原因:

- 使用场景不同:优雅退出 vs 紧急终止

- shutdown() 无法中断正在执行的任务,shutdownNow() 则可以

- 用户根据业务需求选择:正常关闭用

shutdown(),异常/紧急情况用shutdownNow()

状态跃迁路径(按方法边界组织):

tryTerminate 触发关闭一个空闲线程,空闲线程退出时 processWorkerExit,又再触发 tryTerminate,周而复始。

问题在于,最初谁触发了 tryTerminate?

答案:ThreadPoolExecutor 消亡全景——tryTerminate() 驱动的传播式关闭

1 | |

ThreadPoolExecutor 消亡机制要点:

tryTerminate()是条件检查而非强制关闭:内部判断runState >= SHUTDOWN && workerCount == 0才执行终止。每次 workerCount 可能变为 0 的操作后都会调用它,形成多次检查、最终触发的模式tryTerminate()的所有调用点:shutdown():状态置为 SHUTDOWN 后,检查是否可立即终止(队列为空且无 Worker)shutdownNow():状态置为 STOP 且清空队列后,检查是否可立即终止(workerCount=0)processWorkerExit():每个 Worker 退出时,传播终止信号,检查是否最后一个 Worker——这是传播式关闭的核心addWorkerFailed():Worker 创建/启动失败时,workerCount 可能变为 0,检查终止条件purge():清理已取消的 Future 任务后,队列可能变空,SHUTDOWN 状态下可触发终止remove():从队列移除指定任务后,队列可能变空,SHUTDOWN 状态下可触发终止

drainQueue()的作用:shutdownNow()调用,将队列中所有未执行的任务通过BlockingQueue.drainTo()批量转移到 List 中返回,调用者可决定取消或重新提交interruptIdleWorkers()不一定导致线程退出:中断只是唤醒线程,线程被唤醒后在getTask()循环中检查状态:- SHUTDOWN + 队列非空 → 继续从队列取任务执行(不退出)

- SHUTDOWN + 队列空 →

return null,线程退出 - STOP(任意队列状态) →

return null,线程立即退出

interruptIdleWorkers(ONLY_ONE)为什么只中断一个?:这是tryTerminate()内部的补充机制。shutdown()已调用interruptIdleWorkers(false)中断所有空闲线程,此处处理后续仍有线程存活的情况。只中断一个的原因:避免唤醒风暴(批量中断导致大量线程同时苏醒竞争 mainLock)、锁持有时间短、链式反应保证最终终止。Javadoc 原文:“To guarantee eventual termination, it suffices to always interrupt only one idle worker.”- idle 线程如何响应中断?:idle 线程阻塞在

getTask()的workQueue.take()或workQueue.poll()上。中断后抛出InterruptedException,被 catch 捕获后 continue 回到循环开头,检查状态if (rs >= SHUTDOWN && (rs >= STOP || workQueue.isEmpty())),满足条件返回 null getTask()返回 null 后 Worker 如何退出?:runWorker()的while循环条件不满足 → 退出循环 →completedAbruptly = false→processWorkerExit()→ 从 workers 移除、更新统计、调用tryTerminate()→runWorker()方法返回,线程自然结束- 异常退出路径:

task.run()抛出未捕获异常时,completedAbruptly = true(默认值未被设为 false),processWorkerExit()中会decrementWorkerCount()(正常退出在getTask中减)并addWorker(null, false)补充一个 Worker - 关闭流程的本质:状态先变、退出分散的异步模式。

advanceRunState()后调用方立即返回,不会被阻塞等待。线程池进入关闭状态(不可逆),各线程在自然执行节点逐步感知状态变化并退出——这是最终一致性设计 - 最后一个退出的 Worker 触发 TIDYING → TERMINATED 转换。

tryTerminate()确保任何导致 workerCount 减少的操作都有机会触发终止检查,避免线程池永远卡在 SHUTDOWN 状态

尝试关闭 ThreadPoolExecutor

关闭流程的本质:状态先变、退出分散的异步模式。

advanceRunState(SHUTDOWN/STOP) 后,调用方立即返回,不会被阻塞等待。线程池进入关闭状态(不可逆),各线程在自然执行节点逐步感知状态变化并退出:

| 退出触发点 | 触发机制 | 说明 |

|---|---|---|

getTask() 阻塞中被中断 |

interruptIdleWorkers() 唤醒 |

检查状态后退出 |

getTask() 队列空返回 null |

自然感知 | SHUTDOWN + 队列空 → 退出 |

任务执行完毕后回到 getTask() |

自然感知 | 检查状态后退出 |

processWorkerExit() → tryTerminate() |

传播式关闭 | 中断下一个空闲线程 |

这是最终一致性设计:不强制同步等待,而是让线程在自然执行节点逐步退出。优点:调用方快速返回、降低峰值压力、自然处理边缘情况(SHUTDOWN 下长任务正常完成)。

1 | |

生命周期钩子方法:beforeExecute / afterExecute / terminated

ThreadPoolExecutor 提供了三个 protected 钩子方法,允许子类在任务执行的关键节点插入自定义逻辑。这是模板方法模式的经典应用。

钩子方法定义与调用时机

1 | |

调用时机与执行保证:

sequenceDiagram

participant TPE as ThreadPoolExecutor

participant W as Worker

participant T as Thread

participant Task as Runnable

TPE->>W: runWorker(this)

loop 任务循环

TPE->>TPE: getTask()

TPE->>W: w.lock()

Note over TPE: === 钩子调用开始 ===

TPE->>TPE: beforeExecute(thread, task)

Note right of TPE: 默认空实现<br/>可抛出异常终止任务

alt beforeExecute 正常完成

TPE->>Task: task.run()

Task-->>TPE: 正常返回或抛出异常

TPE->>TPE: afterExecute(task, thrown)

Note right of TPE: thrown = 捕获的异常<br/>正常完成时为 null

else beforeExecute 抛出异常

Note over TPE: 任务不会执行

TPE->>TPE: afterExecute(task, thrown)

Note right of TPE: thrown = beforeExecute 的异常

end

TPE->>W: w.unlock()

TPE->>W: completedTasks++

end

TPE->>TPE: processWorkerExit()

alt 线程池进入 TIDYING 状态

TPE->>TPE: terminated()

Note right of TPE: 仅调用一次<br/>所有 Worker 已退出

end典型应用场景

1. 任务执行时间监控与统计

1 | |

2. 线程上下文传递(如 TraceId)

1 | |

3. 任务优先级动态调整

1 | |

关键注意事项

1. 异常处理原则

1 | |

FutureTask 异常处理陷阱: 当提交的任务是 FutureTask(如 submit() 返回的对象)时,异常被封装在 ExecutionException 内部,afterExecute 收到的 Throwable t 参数可能为 null。

1 | |

原因分析: FutureTask.run() 内部捕获了所有异常并存储在 outcome 字段中,对外表现为正常完成。只有调用 Future.get() 时才会抛出封装后的 ExecutionException。

2. 阻塞风险

1 | |

3. 与 shutdown 的协作

1 | |

4. 入参操纵性说明

各钩子方法的参数操纵能力不同:

| 钩子方法 | 参数 | 可操纵性 | 修改的影响范围 |

|---|---|---|---|

beforeExecute(Thread t, Runnable r) |

Thread t | 高 | 影响即将执行的任务线程属性 |

| Runnable r | 中 | 可读取任务信息、修改自定义任务内部状态 | |

afterExecute(Runnable r, Throwable t) |

Runnable r | 低 | 任务已执行完,修改无运行时影响 |

| Throwable t | 低 | 参数是捕获结果的引用,修改不影响原异常传播 | |

terminated() |

无参数 | - | 可访问线程池字段进行清理 |

beforeExecute 入参操纵示例:

1 | |

关键约束:

beforeExecute中抛出异常会导致任务不执行,但afterExecute仍会被调用(异常传递给Throwable参数)- 钩子方法在 Worker 线程中同步执行,修改入参后应避免耗时操作

钩子方法与状态机的关系

stateDiagram-v2

[*] --> RUNNING: 创建线程池

RUNNING --> SHUTDOWN: shutdown()

RUNNING --> STOP: shutdownNow()

SHUTDOWN --> TIDYING: 队列为空且所有任务完成

STOP --> TIDYING: 所有任务完成

TIDYING --> TERMINATED: terminated() 执行完成

note right of RUNNING

beforeExecute / afterExecute

在每个任务执行前后调用

end note

note right of TIDYING

terminated() 调用点:

1. 所有 Worker 已退出

2. 队列已空

3. 仅调用一次

end note核心要点:

beforeExecute/afterExecute:每个任务执行前后调用,用于任务级监控和上下文管理terminated:线程池完全终止后调用一次,用于资源清理和最终统计- 所有钩子都在同步上下文中执行,应避免耗时操作

- 异常处理要完善,避免影响线程池正常运行

getTask 获取任务

1 | |

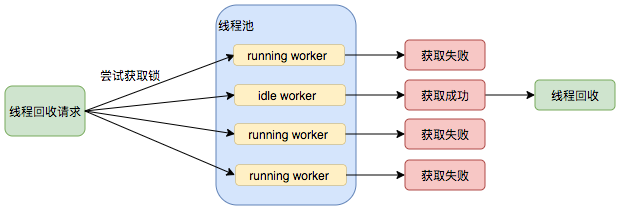

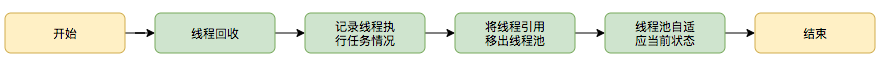

线程回收

中断空闲线程后,线程检查终止条件或配置变更,决定是否退出。

interruptIdleWorkers 中断空闲线程

共 6 个方法调用:

| 调用方 | 调用形式 | 触发条件 | 目的 |

|---|---|---|---|

shutdown() |

interruptIdleWorkers() |

显式关闭线程池 | 中断所有空闲线程,让它们检查池状态后退出 |

tryTerminate() |

interruptIdleWorkers(ONLY_ONE) |

终止条件满足但 workerCount > 0 | 传播式关闭,唤醒一个线程形成退出连锁反应 |

setCorePoolSize() |

interruptIdleWorkers() |

新值 < 当前线程数 | 回收超出新核心数的多余线程 |

setMaximumPoolSize() |

interruptIdleWorkers() |

新值 < 当前线程数 | 回收超出新最大数的多余线程 |

setKeepAliveTime() |

interruptIdleWorkers() |

超时时间变更 | 让空闲线程重新计算超时,可能触发回收 |

allowCoreThreadTimeOut() |

interruptIdleWorkers() |

超时策略变更 | 让核心线程也参与超时回收 |

设计动因:通过 tryLock() 检测 Worker 锁状态,仅中断空闲线程,保护正在执行的任务不被错误中断。

1 | |

线程销毁

processWorkerExit Worker 退出处理

1 | |

常见问题与替代方案

调参的核心原则

线程池的调参有几个难点:

- 如果核心线程数过小,则吞吐可能不够,遇到流量毛刺可能导致 RejectExecutionException;但值得警惕的是,如果核心线程数很大,可能导致频繁的上下文切换和过多的资源消耗(不管是 cpu 时间片还是操作系统的内核线程)。

- 如果队列过长,导致请求数量增加时,大量任务堆积在队列中,任务执行时间过长,最终导致下游服务的大量调用超时失败。

那么,如何计算这些参数呢?

有一个基本的原则是:

- 计算密集型的线程数本身应该尽量贴近 cpu 核数。

- io 密集型的线程数要注意伸缩,要配合阻塞队列使用,要有承受拒绝失败的的准备。

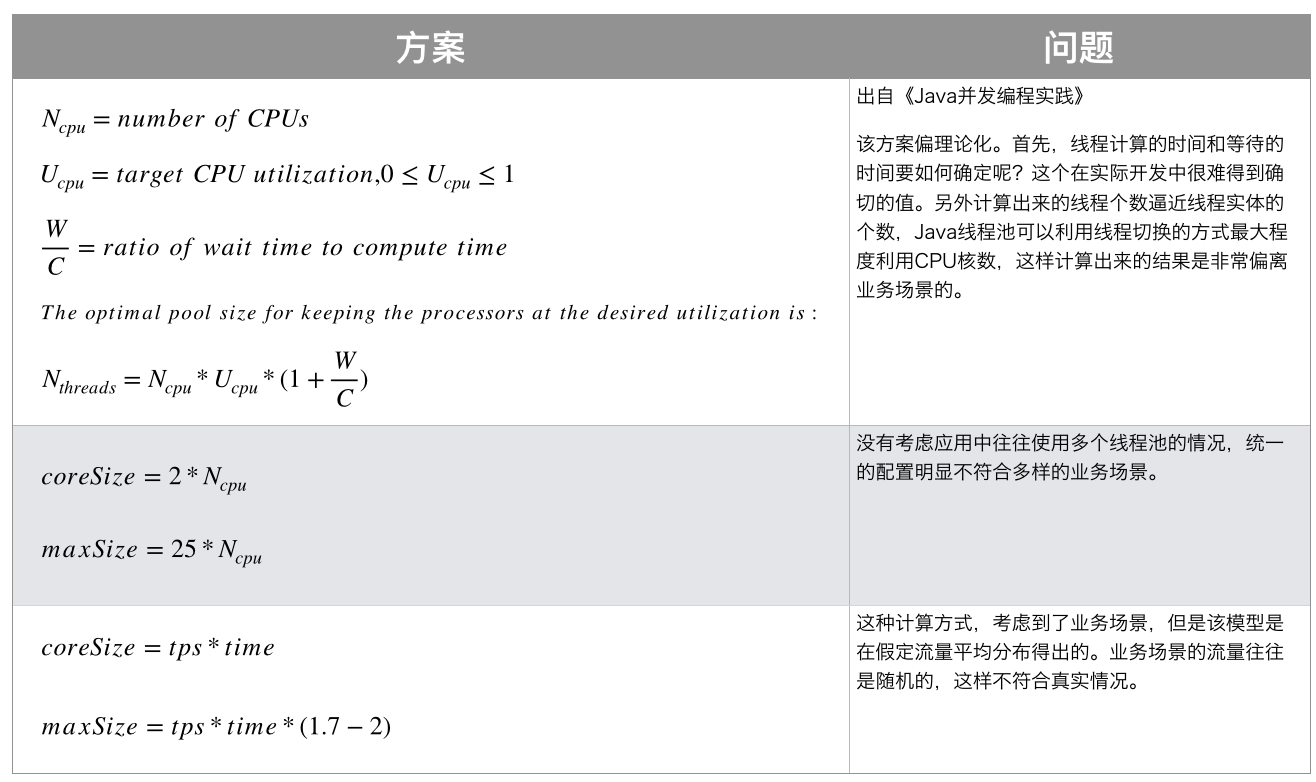

我们常见的计算方式主要来自于《Java Concurrency in Practice》§8.2(Sizing Thread Pools):

方案一(出自《Java并发编程实践》):

The optimal pool size for keeping the processors at the desired utilization is:

问题:该方案偏理论化。首先,线程计算的时间和等待的时间要如何确定呢?这个在实际开发中很难得到确切的值。另外计算出来的线程个数逼近线程实体的个数,Java线程池可以利用线程切换的方式最大程度利用CPU核数,这样计算出来的结果是非常偏离业务场景的。

方案二:

问题:没有考虑应用中往往使用多个线程池的情况,统一的配置明显不符合多样的业务场景。

方案三:

问题:这种计算方式,考虑到了业务场景,但是该模型是在假定流量平均分布得出的。业务场景的流量往往是随机的,这样不符合真实情况。

现实中可选的线程数计算公式最好是取一个并发 qps 数和 cpu 数的折中。通常可以认为 1000ms / 单任务RT(ms) 可以得到单一线程的吞吐数,目标QPS / 单线程吞吐数 可以得到相应的线程数。但这个方案没有考虑 cpu 核数和上下文切换的问题,所以这样算出来的线程数的实际 qps 表现应该低于理论 qps,但可以通过估算和压测不断让理论值逼近实际值。

替代方案对比

其他可替代方案,都不如线程池的调优方案成熟(在可以使用新技术的前提下,我们是否还有调优旧方案的魄力呢?):

传统替代方案对比

| 名称 | 描述 | 优势 | 劣势 |

|---|---|---|---|

| Disruptor框架 | 线程池内部是通过一个工作队列去维护任务的执行的,它有一个根本性的缺陷:连续争用问题。也就是多个线程在申请任务时,为了合理地分配任务要付出锁资源,对比快速的任务执行来说,这部分申请的损耗是巨大的。高性能进程间消息库LMAX使用了一个叫作环形缓冲的数据结构,用这种这个特殊的数据结构替代队列,将会避免申请任务时出现的连续争用状况。 | 避免连续争用,性能更佳 | 缺乏线程管理的能力,使用场景较少 |

| 协程框架 | 协程是一种用户态的轻量级线程,其拥有自己的寄存器上下文和栈,当调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存器上下文和栈。这种切换上下文的方式要小于线程的开销。在瓶颈侧重IO的情况,使用协程获得并发性要优于使用线程。 | 侧重IO情况时,性能更佳。与多线程策略无冲突,可结合使用 | 在Java中缺乏成熟的应用 |

| Actor框架 | Actor模型通过维护多个Actor去处理并发的任务,它放弃了直接使用线程去获取并发性,而是自己定义了一系列系统组件应该如何动作和交互的通用规则,不需要开发者直接使用线程。通过在原生的线程或协程的级别上做了更高层次的封装,只需要开发者关心每个Actor的逻辑即可实现并发操作。由于避免了直接使用锁,很大程度解决了传统并发编程模式下大量依赖悲观锁导致的资源竞争情况。 | 无锁策略,性能更佳,避免直接使用线程,安全性更高 | 在Java中缺乏成熟的应用,内部复杂,难以排查和调试 |

现代Java并发框架对比

根据Java并发编程实践和各框架的Javadoc文档,以下是主流并发框架的详细对比:

| 框架 | 适用场景 | 核心优势 | 主要劣势 | 典型应用 | 成熟度 |

|---|---|---|---|---|---|

| ThreadPoolExecutor | 通用任务调度、CPU/IO混合负载 | JDK内置、灵活配置、监控完善、社区成熟 | 配置复杂、需要调优经验 | Web服务、批处理、定时任务 | ⭐⭐⭐⭐⭐ |

| ForkJoinPool | CPU密集型分治任务、并行计算 | 工作窃取算法、自动负载均衡、递归任务优化 | 不适合阻塞操作、调试困难 | Stream.parallel()、大数据计算 | ⭐⭐⭐⭐ |