线程安全与锁优化

版本说明:本文主要基于 JDK 6 ~ JDK 14 的 HotSpot 虚拟机实现。需要注意的是,从 JDK 15 开始,偏向锁已被默认关闭并标记为废弃(JEP 374)。如果你使用的是 JDK 15+,文中关于偏向锁的内容仅作为历史参考。

线程安全

什么是线程安全

“当多个线程访问一个对象时,如果不用考虑这些线程在运行时环境下的调度和交替执行,也不需要进行额外的同步,或者在调用方法进行任何其他的协调操作,调用这个对象的行为都可以获得正确的结果,那么这个对象就是线程安全的。”

相对的线程安全,可以分成五个等级。但在深入讨论线程安全的分类之前,我们需要先理解 Java 内存模型——它是理解线程安全问题的理论基础。

Java 内存模型基础

Java 内存模型(Java Memory Model,JMM)是 Java 语言规范的一部分,定义了多线程程序中共享变量的访问规则。理解 JMM 是理解线程安全问题的基础。

为什么需要内存模型?

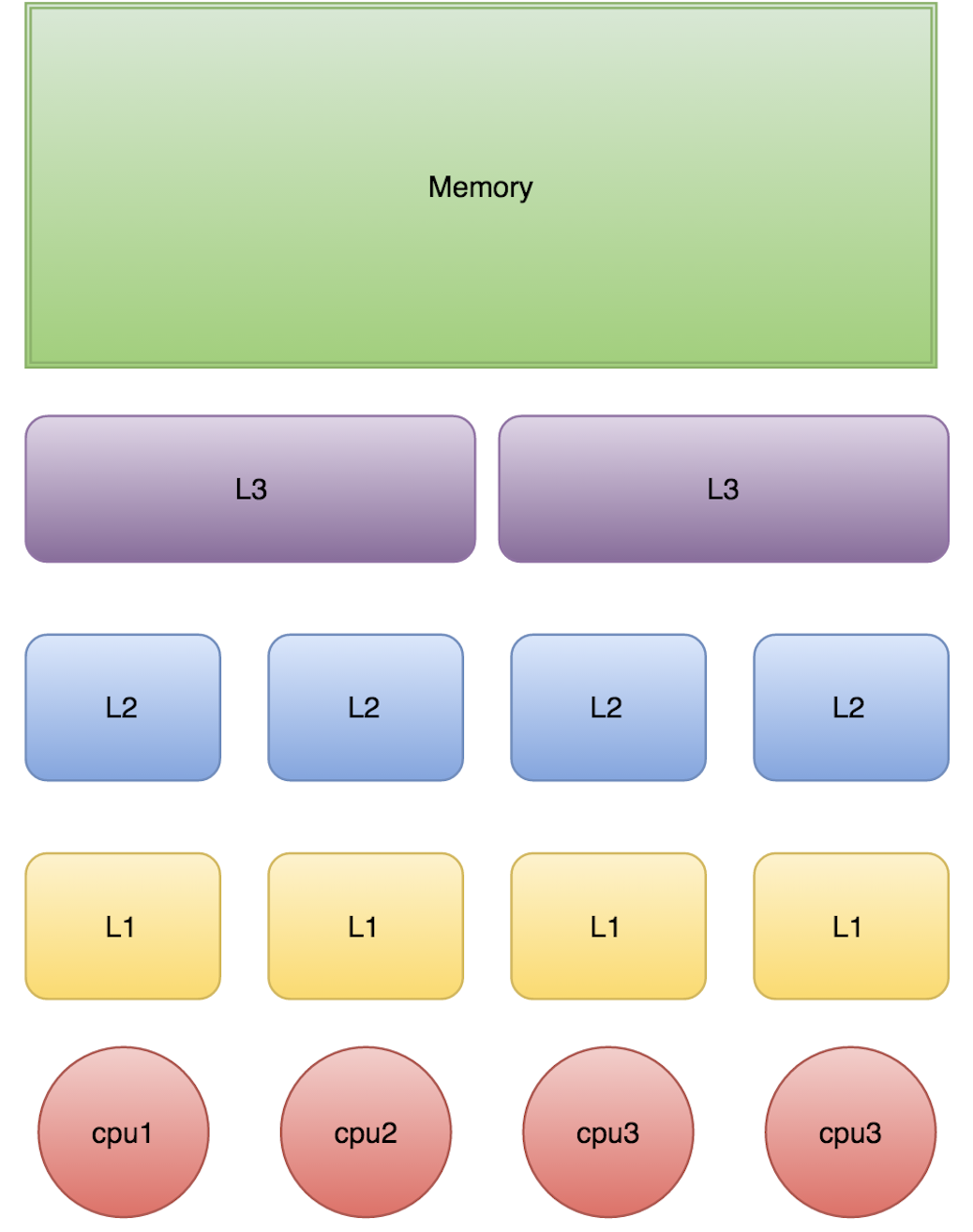

现代计算机系统中,CPU 与主内存之间存在巨大的速度差异。为了弥补这一差距,硬件层面引入了多级缓存(L1、L2、L3 Cache)。这带来了一个问题:当多个 CPU 核心同时操作同一块内存时,各自缓存中的数据可能不一致。

graph TB

subgraph "多核 CPU 的缓存架构"

direction TB

subgraph "CPU 0"

C0["Core 0"]

L1_0["L1 Cache"]

L2_0["L2 Cache"]

C0 --> L1_0 --> L2_0

end

subgraph "CPU 1"

C1["Core 1"]

L1_1["L1 Cache"]

L2_1["L2 Cache"]

C1 --> L1_1 --> L2_1

end

L3["L3 Cache(共享)"]

MEM["主内存(Main Memory)"]

L2_0 --> L3

L2_1 --> L3

L3 --> MEM

style C0 fill:#e1f5ff

style C1 fill:#e1f5ff

style L1_0 fill:#c8e6c9

style L1_1 fill:#c8e6c9

style L2_0 fill:#fff9c4

style L2_1 fill:#fff9c4

style L3 fill:#ffecb3

style MEM fill:#ffcdd2

end

note["问题:Core 0 修改了变量 x,<br/>Core 1 的缓存中可能还是旧值"]

style note fill:#fff9c4JMM 的作用就是屏蔽底层硬件差异,为 Java 程序员提供一套统一的内存访问规则。

JMM 的抽象模型

JMM 将内存分为两个层次:

graph TB

subgraph "JMM 抽象模型"

direction TB

subgraph "线程 1"

T1["线程 1"]

WM1["工作内存<br/>(Working Memory)<br/>━━━━━━━━━━━━━━━━━━━━<br/>变量 x 的副本<br/>变量 y 的副本"]

end

subgraph "线程 2"

T2["线程 2"]

WM2["工作内存<br/>(Working Memory)<br/>━━━━━━━━━━━━━━━━━━━━<br/>变量 x 的副本<br/>变量 y 的副本"]

end

MM["主内存(Main Memory)<br/>━━━━━━━━━━━━━━━━━━━━<br/>共享变量 x<br/>共享变量 y"]

T1 --> WM1

T2 --> WM2

WM1 <-->|"read/load<br/>store/write"| MM

WM2 <-->|"read/load<br/>store/write"| MM

style T1 fill:#e1f5ff

style T2 fill:#e1f5ff

style WM1 fill:#c8e6c9

style WM2 fill:#c8e6c9

style MM fill:#ffcdd2

end| 概念 | 说明 |

|---|---|

| 主内存(Main Memory) | 所有线程共享的内存区域,存储共享变量 |

| 工作内存(Working Memory) | 每个线程私有的内存区域,存储该线程使用的共享变量的副本 |

关键规则:

- 线程对共享变量的所有操作都必须在工作内存中进行,不能直接读写主内存

- 不同线程之间无法直接访问对方的工作内存,必须通过主内存传递

线程安全的三大特性

JMM 围绕三个核心特性来定义线程安全:

1. 原子性(Atomicity)

定义:一个操作要么全部执行完成,要么完全不执行,不会被其他线程中断。

问题示例:i++ 不是原子操作

1 | |

sequenceDiagram

participant T1 as 线程 1

participant M as 主内存 (i=0)

participant T2 as 线程 2

T1->>M: 读取 i=0

T2->>M: 读取 i=0

T1->>T1: 计算 0+1=1

T2->>T2: 计算 0+1=1

T1->>M: 写入 i=1

T2->>M: 写入 i=1

Note over M: 预期 i=2,实际 i=1<br/>(丢失更新)保证原子性的方式:

synchronized关键字java.util.concurrent.atomic包中的原子类Lock接口的实现类

2. 可见性(Visibility)

定义:当一个线程修改了共享变量的值,其他线程能够立即看到这个修改。

问题示例:没有可见性保证的循环

1 | |

为什么会看不到?

- 线程 1 可能将

running缓存在 CPU 寄存器或 L1 Cache 中 - 线程 2 的修改只写入了主内存,没有通知线程 1 刷新缓存

- 结果:线程 1 一直读取的是缓存中的旧值

保证可见性的方式:

volatile关键字synchronized关键字(进入和退出同步块时会刷新缓存)final关键字(对于不可变对象)

3. 有序性(Ordering)

定义:程序执行的顺序按照代码的先后顺序执行。

问题:编译器和处理器可能对指令进行重排序以优化性能。

1 | |

经典问题:双重检查锁定(DCL)的问题

1 | |

instance = new Singleton() 实际上是三个操作:

- 分配内存空间

- 初始化对象

- 将 instance 指向分配的内存

由于重排序,可能变成 1 → 3 → 2,导致其他线程看到一个未完全初始化的对象。

保证有序性的方式:

volatile关键字(禁止特定类型的重排序)synchronized关键字(同一时刻只有一个线程执行)- happens-before 规则

happens-before 规则

happens-before 是 JMM 的核心概念,它定义了操作之间的可见性关系。

定义:如果操作 A happens-before 操作 B,那么 A 的执行结果对 B 可见,且 A 的执行顺序在 B 之前。

注意:happens-before 不是指时间上的先后,而是指可见性的保证。

JMM 定义的 happens-before 规则

| 规则 | 说明 |

|---|---|

| 程序顺序规则 | 同一个线程中,前面的操作 happens-before 后面的操作 |

| 监视器锁规则 | 对一个锁的解锁 happens-before 对同一个锁的加锁 |

| volatile 变量规则 | 对 volatile 变量的写 happens-before 对同一变量的读 |

| 传递性规则 | 如果 A happens-before B,B happens-before C,则 A happens-before C |

| 线程启动规则 | Thread.start() happens-before 该线程中的任何操作 |

| 线程终止规则 | 线程中的任何操作 happens-before 其他线程检测到该线程终止 |

| 中断规则 | 对线程 interrupt() 的调用 happens-before 被中断线程检测到中断 |

| 对象终结规则 | 对象的构造函数执行完成 happens-before finalize() 方法的开始 |

graph LR

subgraph "happens-before 示例"

direction TB

subgraph "线程 1"

A["x = 1"]

B["unlock(m)"]

A -->|"程序顺序规则"| B

end

subgraph "线程 2"

C["lock(m)"]

D["读取 x"]

C -->|"程序顺序规则"| D

end

B -->|"监视器锁规则"| C

A -->|"传递性:x=1 对线程 2 可见"| D

style A fill:#c8e6c9

style B fill:#fff9c4

style C fill:#fff9c4

style D fill:#e1f5ff

endvolatile 关键字

volatile 是 Java 提供的最轻量级的同步机制,它保证了可见性和有序性,但不保证原子性。

volatile 的语义

- 可见性:对 volatile 变量的写入会立即刷新到主内存,读取会从主内存重新加载

- 有序性:禁止 volatile 变量与普通变量之间的重排序

volatile 的内存屏障

JVM 通过插入**内存屏障(Memory Barrier)**来实现 volatile 的语义:

| 屏障类型 | 说明 |

|---|---|

| LoadLoad | 确保 Load1 数据的装载先于 Load2 及后续装载指令 |

| StoreStore | 确保 Store1 数据对其他处理器可见先于 Store2 及后续存储指令 |

| LoadStore | 确保 Load1 数据装载先于 Store2 及后续存储指令刷新到内存 |

| StoreLoad | 确保 Store1 数据对其他处理器可见先于 Load2 及后续装载指令 |

graph TB

subgraph "volatile 写操作的内存屏障"

direction TB

SS1["StoreStore 屏障"]

VW["volatile 写"]

SL1["StoreLoad 屏障"]

SS1 --> VW --> SL1

note1["禁止上面的普通写<br/>与 volatile 写重排序"]

note2["禁止 volatile 写<br/>与下面的读/写重排序"]

SS1 -.-> note1

SL1 -.-> note2

style VW fill:#ffcdd2

end

subgraph "volatile 读操作的内存屏障"

direction TB

VR["volatile 读"]

LL1["LoadLoad 屏障"]

LS1["LoadStore 屏障"]

VR --> LL1 --> LS1

note3["禁止 volatile 读<br/>与下面的读重排序"]

note4["禁止 volatile 读<br/>与下面的写重排序"]

LL1 -.-> note3

LS1 -.-> note4

style VR fill:#c8e6c9

end深入理解内存屏障

上面我们介绍了 JVM 层面的四种内存屏障(LoadLoad、LoadStore、StoreLoad、StoreStore),但这只是冰山一角。要真正理解内存屏障的本质,我们需要深入到 CPU 和缓存的层面。

为什么需要内存屏障?

现代 CPU 为了提高性能,引入了多级缓存和各种优化机制,这些机制可能导致内存操作的可见性和顺序性问题:

graph TB

subgraph "CPU 的写操作优化"

direction TB

CPU["CPU Core"]

SB["Store Buffer<br/>(写缓冲区)<br/>━━━━━━━━━━━━━━━━━━━━<br/>暂存写操作<br/>异步刷新到缓存"]

L1["L1 Cache"]

L2["L2 Cache"]

MEM["主内存"]

CPU -->|"1. 写入"| SB

SB -->|"2. 异步刷新"| L1

L1 --> L2 --> MEM

note1["问题:写入 Store Buffer 后<br/>CPU 认为写操作完成<br/>但其他 CPU 还看不到"]

style SB fill:#ffcdd2

style note1 fill:#fff9c4

end

subgraph "CPU 的读操作优化"

direction TB

CPU2["CPU Core"]

IQ["Invalidate Queue<br/>(失效队列)<br/>━━━━━━━━━━━━━━━━━━━━<br/>暂存失效消息<br/>延迟处理"]

L1_2["L1 Cache"]

CPU2 -->|"读取"| L1_2

IQ -->|"延迟失效"| L1_2

note2["问题:失效消息在队列中<br/>但缓存行还未真正失效<br/>可能读到过期数据"]

style IQ fill:#ffcdd2

style note2 fill:#fff9c4

endStore Buffer(写缓冲区):

- CPU 执行写操作时,不会直接写入缓存,而是先写入 Store Buffer

- 这样 CPU 可以继续执行后续指令,不用等待缓存一致性协议完成

- 问题:其他 CPU 可能看不到 Store Buffer 中的数据

Invalidate Queue(失效队列):

- 当 CPU 收到缓存失效消息时,不会立即处理,而是放入 Invalidate Queue

- 这样 CPU 可以快速响应,不用等待缓存失效完成

- 问题:缓存行可能还未真正失效,读到过期数据

内存屏障的本质

内存屏障(Memory Barrier / Memory Fence)是 CPU 提供的指令,用于强制刷新 Store Buffer 或处理 Invalidate Queue:

| CPU 架构 | 写屏障指令 | 读屏障指令 | 全屏障指令 |

|---|---|---|---|

| x86/x64 | sfence |

lfence |

mfence |

| ARM | dmb st |

dmb ld |

dmb ish |

| POWER | lwsync |

lwsync |

sync |

graph LR

subgraph "内存屏障的作用"

direction TB

subgraph "写屏障(Store Barrier)"

WB["sfence / dmb st"]

WB_DESC["强制刷新 Store Buffer<br/>确保之前的写操作<br/>对其他 CPU 可见"]

end

subgraph "读屏障(Load Barrier)"

RB["lfence / dmb ld"]

RB_DESC["强制处理 Invalidate Queue<br/>确保读到最新数据"]

end

subgraph "全屏障(Full Barrier)"

FB["mfence / dmb ish"]

FB_DESC["同时具有读屏障和写屏障的效果<br/>最强的顺序保证"]

end

style WB fill:#c8e6c9

style RB fill:#e1f5ff

style FB fill:#ffcdd2

endJVM 如何映射内存屏障

JVM 的四种抽象屏障会根据不同的 CPU 架构映射到具体的指令:

| JVM 屏障 | x86/x64 | ARM | 作用 |

|---|---|---|---|

| LoadLoad | 空操作(x86 保证) | dmb ishld |

禁止读-读重排序 |

| StoreStore | 空操作(x86 保证) | dmb ishst |

禁止写-写重排序 |

| LoadStore | 空操作(x86 保证) | dmb ish |

禁止读-写重排序 |

| StoreLoad | mfence 或 lock 前缀 |

dmb ish |

禁止写-读重排序 |

为什么 x86 大部分屏障是空操作?

x86 架构采用强内存模型(TSO - Total Store Order),硬件层面已经保证了大部分顺序性,只有 StoreLoad 重排序需要显式屏障。这也是为什么 Java 在 x86 上的并发性能通常比 ARM 更好。

volatile 的底层实现

重要说明:JMM 规范与 JVM 实现的区别

在讨论 volatile 的实现之前,需要明确区分两个层次:

| 层次 | 定义者 | 内容 |

|---|---|---|

| JMM 规范 | JLS 17.4 | 定义 happens-before 语义,不规定具体实现 |

| JVM 实现 | HotSpot 等 | 使用内存屏障实现 JMM 语义,因架构而异 |

根据 JLS 17.4.4,volatile 变量的语义是:

- 对 volatile 变量的写操作 happens-before 后续对同一变量的读操作

- 这保证了可见性和有序性,但 JLS 并未规定必须使用哪种内存屏障

JSR-133 Cookbook 的实现指南(非规范,仅供参考):

当 JVM 编译 volatile 变量的读写时,会插入相应的内存屏障:

1 | |

1 | |

x86 架构的实际实现:

由于 x86 采用强内存模型(TSO),大部分屏障是空操作:

| 屏障类型 | x86 上的实现 | 原因 |

|---|---|---|

| StoreStore | 空操作 | x86 保证 Store-Store 顺序 |

| LoadLoad | 空操作 | x86 保证 Load-Load 顺序 |

| LoadStore | 空操作 | x86 保证 Load-Store 顺序 |

| StoreLoad | 需要显式屏障 | x86 允许 Store-Load 重排序 |

1 | |

lock 前缀会锁定缓存行(或总线),确保写操作对所有 CPU 可见。

关键理解:内存屏障是 JVM 实现 JMM 语义的手段,不是 JMM 规范本身。不同 JVM、不同 CPU 架构可能使用不同的屏障组合,只要最终满足 happens-before 语义即可。

内存屏障 vs GC 屏障:名字相同,本质不同

你可能听说过 G1、ZGC 也使用"屏障"(Barrier),但这与 CPU 内存屏障是完全不同的概念:

| 维度 | CPU 内存屏障 | GC 屏障 |

|---|---|---|

| 层次 | 硬件指令 | 软件代码 |

| 目的 | 保证内存操作的可见性和顺序性 | 维护 GC 的正确性(如记录引用变化) |

| 实现 | CPU 指令(mfence、dmb 等) | JIT 编译器插入的代码片段 |

| 性能影响 | 阻止 CPU 优化,有一定开销 | 每次引用操作都执行,开销更大 |

G1 的写屏障(Write Barrier)

G1 使用写屏障来维护 Remembered Set(记录跨 Region 引用):

1 | |

ZGC 的读屏障(Load Barrier)

ZGC 使用读屏障来实现并发重定位:

1 | |

graph TB

subgraph "两种'屏障'的对比"

direction LR

subgraph "CPU 内存屏障"

MB["mfence / dmb"]

MB_USE["用途:保证内存可见性"]

MB_WHEN["时机:volatile 读写、锁操作"]

MB_HOW["实现:CPU 指令"]

end

subgraph "GC 屏障"

GB["Write/Load Barrier"]

GB_USE["用途:维护 GC 正确性"]

GB_WHEN["时机:每次引用读写"]

GB_HOW["实现:JIT 插入的代码"]

end

style MB fill:#e1f5ff

style GB fill:#c8e6c9

end为什么都叫"屏障"?

两者都是在某个操作前后插入额外的逻辑,起到"拦截"或"保护"的作用,因此都被称为"屏障"。但它们解决的问题完全不同:

- CPU 内存屏障:解决多核 CPU 的缓存一致性问题

- GC 屏障:解决并发 GC 的正确性问题

MESI 协议:缓存一致性的基石

在讨论内存屏障时,我们提到了"缓存一致性"。那么 CPU 是如何保证多核之间缓存一致的呢?答案是 MESI 协议。

重要说明:MESI 协议不是 x86 专属的,而是一种通用的缓存一致性协议。它最初由 Intel 在 1980 年代提出,但被广泛应用于多种处理器架构:

| 处理器架构 | 使用的协议 | 说明 |

|---|---|---|

| x86/x64 | MESI、MESIF | Intel 使用 MESIF(增加 Forward 状态),AMD 使用 MOESI |

| ARM | MOESI、MESI 变体 | ARM 的 big.LITTLE 架构使用类似协议 |

| SPARC | MOESI | Sun/Oracle 的 SPARC 处理器 |

| PowerPC | MESI 扩展 | IBM 的 Power 系列处理器 |

| RISC-V | 可配置 | 支持多种一致性协议 |

本文以 MESI 为例讲解,因为它是最基础、最经典的缓存一致性协议,其他协议(如 MOESI、MESIF)都是在 MESI 基础上的扩展。

MESI 的四种状态

MESI 是一种缓存一致性协议,每个缓存行(Cache Line)都有四种状态:

| 状态 | 全称 | 含义 |

|---|---|---|

| M | Modified | 缓存行被修改,与主内存不一致,只有当前 CPU 有效副本 |

| E | Exclusive | 缓存行与主内存一致,只有当前 CPU 有副本 |

| S | Shared | 缓存行与主内存一致,多个 CPU 都有副本 |

| I | Invalid | 缓存行无效,需要从主内存或其他 CPU 重新加载 |

stateDiagram-v2

[*] --> I: 初始状态

I --> E: 本地读取(其他 CPU 无副本)

I --> S: 本地读取(其他 CPU 有副本)

I --> M: 本地写入

E --> S: 其他 CPU 读取

E --> M: 本地写入

E --> I: 其他 CPU 写入

S --> M: 本地写入(需先失效其他副本)

S --> I: 其他 CPU 写入

M --> S: 其他 CPU 读取(需先写回主内存)

M --> I: 其他 CPU 写入(需先写回主内存)

M --> E: 写回主内存MESI 的工作流程

上面的状态图展示了 MESI 协议的基本状态转换,但实际的 CPU 实现中还有两个关键组件:Store Buffer 和 Invalidate Queue。它们是性能优化的关键,也是导致内存可见性问题的根源。

graph TB

subgraph "CPU 0"

CPU0_CORE["CPU 0 Core"]

SB0["Store Buffer<br/>━━━━━━━━━━━━━━<br/>写入缓冲区<br/>暂存待写入的数据"]

CACHE0["L1 Cache<br/>━━━━━━━━━━━━━━<br/>MESI 状态管理"]

IQ0["Invalidate Queue<br/>━━━━━━━━━━━━━━<br/>失效队列<br/>暂存待处理的失效消息"]

CPU0_CORE -->|"1. 写入"| SB0

SB0 -->|"2. 刷新到缓存"| CACHE0

IQ0 -->|"4. 处理失效"| CACHE0

end

BUS["系统总线(Bus)"]

subgraph "CPU 1"

CPU1_CORE["CPU 1 Core"]

SB1["Store Buffer"]

CACHE1["L1 Cache"]

IQ1["Invalidate Queue"]

CPU1_CORE -->|"读取"| CACHE1

IQ1 -->|"处理失效"| CACHE1

end

CACHE0 <-->|"3. Invalidate 消息"| BUS

BUS <-->|"放入队列"| IQ1

CACHE1 <-->|"Read/Response"| BUS

style SB0 fill:#ffcdd2

style SB1 fill:#ffcdd2

style IQ0 fill:#fff9c4

style IQ1 fill:#fff9c4Store Buffer 和 Invalidate Queue 的作用:

| 组件 | 作用 | 带来的问题 |

|---|---|---|

| Store Buffer | CPU 写入时先写入 Store Buffer,不等待其他 CPU 确认,提高写入性能 | 写入可能延迟对其他 CPU 可见 |

| Invalidate Queue | CPU 收到 Invalidate 消息后先放入队列,不立即处理,提高响应速度 | 可能读到已被其他 CPU 修改的旧值 |

这就是为什么需要内存屏障的根本原因:

sequenceDiagram

participant CPU0 as CPU 0

participant SB0 as Store Buffer 0

participant C0 as Cache 0

participant BUS as 总线

participant IQ1 as Invalidate Queue 1

participant C1 as Cache 1

participant CPU1 as CPU 1

Note over CPU0,CPU1: 问题场景:没有内存屏障时

CPU0->>SB0: 写入 x = 1

Note over SB0: x = 1 暂存在 Store Buffer

CPU0->>CPU0: 继续执行其他指令

CPU1->>C1: 读取 x

Note over CPU1: 读到旧值 x = 0!

SB0->>C0: 稍后刷新到缓存

C0->>BUS: 发送 Invalidate

BUS->>IQ1: 放入 Invalidate Queue

Note over IQ1: 失效消息还在队列中...

Note over CPU0,CPU1: 解决方案:使用内存屏障

rect rgb(200, 230, 200)

Note over CPU0: Store Barrier(写屏障)

CPU0->>SB0: 强制刷新 Store Buffer

SB0->>C0: 立即写入缓存

end

rect rgb(200, 200, 230)

Note over CPU1: Load Barrier(读屏障)

CPU1->>IQ1: 强制处理 Invalidate Queue

IQ1->>C1: 使缓存行失效

CPU1->>C1: 读取 x

Note over CPU1: 读到新值 x = 1

end关键理解:

- MESI 协议本身是正确的,它最终会保证所有 CPU 看到一致的值

- 但 Store Buffer 和 Invalidate Queue 引入了延迟,导致"最终一致"而非"即时一致"

- 内存屏障的作用就是强制刷新这些缓冲区,确保写入立即可见

MESI 与 JMM 的关系

MESI 是硬件层面的缓存一致性协议,JMM 是语言层面的内存模型。两者的关系是:

graph TB

subgraph "层次关系"

direction TB

JMM["Java 内存模型(JMM)<br/>━━━━━━━━━━━━━━━━━━━━<br/>定义 happens-before 规则<br/>定义 volatile、synchronized 语义<br/>屏蔽底层硬件差异"]

JVM["JVM 实现<br/>━━━━━━━━━━━━━━━━━━━━<br/>将 JMM 语义映射到<br/>具体的内存屏障指令"]

CPU["CPU 硬件<br/>━━━━━━━━━━━━━━━━━━━━<br/>MESI 协议保证缓存一致性<br/>内存屏障指令控制顺序"]

JMM --> JVM --> CPU

style JMM fill:#e1f5ff

style JVM fill:#c8e6c9

style CPU fill:#fff9c4

end关键理解:

- MESI 保证最终一致性:通过 Invalidate 消息,MESI 最终会让所有 CPU 看到相同的值

- 但 MESI 不保证即时可见性:由于 Store Buffer 和 Invalidate Queue 的存在,写操作可能延迟可见

- 内存屏障弥补这个差距:强制刷新 Store Buffer 或处理 Invalidate Queue

“锁缓存”(Cache Line Locking)

你可能听说过"锁缓存"这个概念,它与 MESI 密切相关:

锁缓存是 x86 CPU 的一种优化机制:当执行带 lock 前缀的指令时,如果操作的数据在缓存中,CPU 不会锁定整个总线,而是只锁定对应的缓存行。

graph TB

subgraph "lock 前缀的两种实现"

direction LR

subgraph "总线锁(Bus Lock)"

BL["锁定整个总线"]

BL_WHEN["条件:数据跨缓存行<br/>或缓存行不在 M/E 状态"]

BL_COST["开销:非常大<br/>阻塞所有 CPU 的内存访问"]

end

subgraph "缓存锁(Cache Lock)"

CL["只锁定缓存行"]

CL_WHEN["条件:数据在单个缓存行内<br/>且缓存行在 M/E 状态"]

CL_COST["开销:较小<br/>只影响该缓存行的访问"]

end

style BL fill:#ffcdd2

style CL fill:#c8e6c9

endCAS 操作与缓存锁:

1 | |

lock cmpxchg 指令会:

- 如果数据在缓存中且满足条件,使用缓存锁

- 将缓存行状态设为 M(Modified)

- 发送 Invalidate 消息给其他 CPU

- 其他 CPU 的对应缓存行变为 I(Invalid)

这就是 CAS 能保证原子性的硬件基础。

为什么有了 MESI 还需要内存屏障?

这是一个常见的困惑。答案是:MESI 保证一致性,但不保证可见性的时机。

graph TB

subgraph "MESI 的局限性"

direction TB

WRITE["CPU 0 执行写操作"]

SB["写入 Store Buffer"]

MESI["MESI 协议开始工作<br/>(发送 Invalidate 消息)"]

IQ["CPU 1 收到消息<br/>放入 Invalidate Queue"]

DELAY["延迟处理..."]

INVALID["缓存行真正失效"]

WRITE --> SB --> MESI --> IQ --> DELAY --> INVALID

note1["问题:在 DELAY 期间<br/>CPU 1 可能读到旧值"]

style SB fill:#ffcdd2

style IQ fill:#ffcdd2

style note1 fill:#fff9c4

endStore Buffer 和 Invalidate Queue 是性能优化,它们让 CPU 不用等待 MESI 协议完成就能继续执行。但这也带来了可见性延迟。

内存屏障的作用就是在需要时强制等待这些异步操作完成:

- 写屏障:等待 Store Buffer 刷新

- 读屏障:等待 Invalidate Queue 处理

synchronized 与内存屏障

JLS 17.4.4 对 synchronized 的规范定义:

根据 JLS 规范,synchronized 的内存语义通过 happens-before 关系定义:

- 对一个 monitor 的解锁操作 happens-before 后续对同一 monitor 的加锁操作

这意味着:在解锁之前的所有写操作,对于后续获取同一锁的线程都是可见的。

JVM 实现层面(非规范,仅供理解):

1 | |

JSR-133 Cookbook 建议的屏障(实现指南,非规范):

| 操作 | 建议屏障 | 语义 |

|---|---|---|

| monitorenter 之后 | LoadLoad + LoadStore | 获取语义(acquire) |

| monitorexit 之前 | StoreStore + StoreLoad | 释放语义(release) |

实际实现因架构而异:

| 架构 | monitorenter 实现 | monitorexit 实现 |

|---|---|---|

| x86 | lock cmpxchg(隐含全屏障) |

lock 前缀指令或普通写 |

| ARM | dmb + ldrex/strex |

dmb + 普通写 |

| AArch64 | ldaxr/stxr(acquire) |

stlr(release) |

关键理解:JLS 规定的是 happens-before 语义,具体使用哪种内存屏障是 JVM 的实现细节。在 x86 上,由于其强内存模型,lock 前缀指令已经提供了足够的内存屏障语义。

这就是为什么 synchronized 能保证可见性:释放锁时的 StoreLoad 屏障确保所有写操作对获取锁的线程可见。

小结

| 概念 | 层次 | 作用 |

|---|---|---|

| MESI 协议 | 硬件 | 保证多核缓存的最终一致性 |

| Store Buffer / Invalidate Queue | 硬件 | 性能优化,但导致可见性延迟 |

| CPU 内存屏障 | 硬件指令 | 强制刷新缓冲区,保证可见性时机 |

| JMM 内存屏障 | JVM 抽象 | 屏蔽硬件差异,提供统一语义 |

| volatile / synchronized | Java 语言 | 通过内存屏障实现可见性和有序性 |

| GC 屏障 | JVM 软件 | 维护 GC 正确性,与内存屏障无关 |

理解这些概念的层次关系,有助于:

- 正确理解 volatile 和 synchronized 的底层原理

- 区分不同"屏障"概念,避免混淆

- 理解为什么 Java 在不同 CPU 架构上的并发行为可能不同

volatile 的正确使用场景

适用场景:

- 状态标志(如上面的

running变量) - 一次性安全发布(配合 final 字段)

- 双重检查锁定(DCL)的修复

修复后的 DCL:

1 | |

为什么 synchronized 不能替代 volatile?

有人可能会问:synchronized 不是也保证可见性吗?为什么还需要 volatile?

关键在于:第一次检查 if (instance == null) 发生在 synchronized 块外部。

sequenceDiagram

participant T1 as 线程 1

participant T2 as 线程 2

participant instance as instance 变量

Note over T1,instance: 没有 volatile 的问题场景

T1->>T1: 进入 synchronized

T1->>instance: instance = new Singleton()

Note over T1,instance: 对象可能未完全初始化<br/>但引用已经非 null

T1->>T1: 退出 synchronized

T2->>instance: 第一次检查:instance == null?

Note over T2,instance: 在 synchronized 外部读取!<br/>可能看到部分构造的对象

T2->>T2: instance != null,跳过 synchronized

T2->>T2: 使用未完全初始化的对象 💥具体分析:

| 检查位置 | 是否在 synchronized 内 | 可见性保证 |

|---|---|---|

第一次检查 if (instance == null) |

❌ 否 | 无保证,可能看到部分构造的对象 |

第二次检查 if (instance == null) |

✅ 是 | 有保证,synchronized 提供可见性 |

volatile 的作用:

- 禁止指令重排序:确保

new Singleton()的三个步骤(分配内存、初始化、赋值引用)不会被重排序 - 保证可见性:确保第一次检查(在 synchronized 外部)也能看到完全初始化的对象

如果所有访问都在 synchronized 内部呢?

如果你能保证所有对 instance 的访问都通过 getInstance() 方法,并且都进入 synchronized 块,那么理论上 synchronized 的可见性就足够了。但 DCL 的设计目的就是避免每次都进入 synchronized,所以第一次检查必须在锁外部,这就需要 volatile。

不适用场景:

- 复合操作(如

i++) - 需要原子性保证的场景

synchronized 与 volatile 的对比

| 特性 | synchronized | volatile |

|---|---|---|

| 原子性 | 保证 | 不保证 |

| 可见性 | 保证 | 保证 |

| 有序性 | 保证 | 保证(部分) |

| 阻塞 | 会阻塞 | 不会阻塞 |

| 性能 | 较重 | 较轻 |

| 使用场景 | 复合操作、临界区 | 状态标志、一次性发布 |

关于"一致性"的说明

本文多处提到"一致性"这个词,需要特别说明:一致性(Consistency)不是 JMM 的专有属性。

JMM 的三大核心属性是:

- 原子性(Atomicity)

- 可见性(Visibility)

- 有序性(Ordering)

而"一致性"在不同上下文中有不同含义:

| 术语 | 含义 | 所属领域 |

|---|---|---|

| 缓存一致性(Cache Coherence) | 多核 CPU 缓存之间的数据一致 | 硬件/MESI 协议 |

| 内存一致性模型(Memory Consistency Model) | 定义多处理器系统中内存操作的可见顺序 | 硬件/操作系统 |

| 顺序一致性(Sequential Consistency) | 最强的内存模型,所有操作按全局顺序执行 | 理论模型 |

| 数据一致性(Data Consistency) | 分布式系统中数据副本的一致 | 分布式系统/ACID |

| 最终一致性(Eventual Consistency) | 数据最终会达到一致状态 | 分布式系统/BASE |

JMM 与一致性的关系:

- JMM 通过 happens-before 规则定义了操作之间的可见性关系

- JMM 提供的是一种弱于顺序一致性的内存模型(允许一定程度的重排序)

- JMM 的目标是在性能和正确性之间取得平衡

final 字段的内存语义

除了 volatile 和 synchronized,final 字段也是 JMM 的重要组成部分。final 字段的内存语义保证了不可变对象的线程安全发布。

final 字段的写入语义

当构造函数完成时,JVM 会在 final 字段写入之后插入一个 StoreStore 屏障,确保:

- final 字段的写入不会被重排序到构造函数之外

- 其他线程在看到对象引用时,一定能看到 final 字段的正确值

sequenceDiagram

participant T1 as 线程 1(构造)

participant MEM as 主内存

participant T2 as 线程 2(读取)

Note over T1: 构造函数开始

T1->>MEM: 写入 final 字段 x = 42

Note over T1: StoreStore 屏障

T1->>MEM: 发布对象引用 obj = this

Note over T1: 构造函数结束

T2->>MEM: 读取 obj 引用

T2->>MEM: 读取 obj.x

Note over T2: 保证看到 x = 42final 字段的读取语义

当首次读取包含 final 字段的对象引用时,JVM 会在读取 final 字段之前插入一个 LoadLoad 屏障,确保:

- 先读取对象引用,再读取 final 字段

- 不会读取到 final 字段的默认值(如 0 或 null)

正确使用 final 的示例

1 | |

final 语义的限制

重要:final 的内存语义有一个前提条件——对象引用必须被正确发布。如果在构造函数中将 this 引用泄露出去,final 的语义保证将失效:

1 | |

final vs volatile vs synchronized

| 特性 | final | volatile | synchronized |

|---|---|---|---|

| 可见性 | 构造完成后保证 | 每次读写都保证 | 临界区内保证 |

| 有序性 | 禁止构造函数内外重排序 | 禁止读写重排序 | 禁止临界区内外重排序 |

| 原子性 | 不保证(只写一次) | 不保证 | 保证 |

| 适用场景 | 不可变对象 | 状态标志、DCL | 复合操作 |

| 性能开销 | 最低(只在构造时) | 较低 | 较高 |

小结

理解 JMM 是理解 Java 并发编程的基础:

- JMM 的作用:屏蔽硬件差异,提供统一的内存访问规则

- 三大特性:原子性、可见性、有序性(注意:不包括"一致性")

- happens-before:定义操作之间可见性关系的核心规则

- volatile:轻量级同步机制,保证可见性和有序性

- final:不可变对象的安全发布保证

- synchronized:重量级同步机制,保证原子性、可见性和有序性

有了这些基础知识,我们就可以更好地理解后续章节中的线程安全分类和锁优化技术。

线程安全的分类

不可变(Immutable)

不可变的数据,都是线程安全的。不可变的对象引用,加上所有field都是不可变的。如果有得选,尽量连方法都是final的。

绝对线程安全(Absolute Thread Safety)

Vector 不是绝对线程安全的。它也会出现并发修改时 Out of Range 的异常(注意,不是 ConcurrentModification 的异常)。

相对线程安全(Relative Thread Safety)

需要保证对这个对象的单独操作是线程安全的,在调用的时候不需要加上额外的保障措施。对于特定顺序的连续操作,就需要额外的同步来保证调用的正确性了。

线程对立

Vector 是相对线程安全的。

线程兼容(Thread Compatible)

可以通过特殊手段做到线程安全的普通类,绝大部分类都属于线程兼容的。

线程对立(Thread Hostile)

线程对立,是不管调用端是否采取了同步措施,都无法在多线程环境中使用的代码。常见的线程对立的操作还有 suspend(),resume(), System.setIn(),System.setOut()和System.runFinalizerOnExit()。

线程安全的实现

互斥同步(Mutual Exclusion & Synchronization)

这是最常见(也是我们在考虑并发问题的时候,首先应该考虑的万能解决方案,也是《Java并发编程实践》和《Thinking in Java 》中最推荐的做法。)的保障并发正确性的手段。同步(Synchronization)是指协调多个线程的执行,保证共享数据在同一时刻只被一条(或使用信号量时多条)线程访问。互斥(Mutual Exclusion)是实现同步的一种手段,临界区(Critical Section)、互斥量(Mutex)和信号量都是实现互斥的常见方式。互斥是因,同步是果;互斥是方法,同步是目的。这两个概念源自操作系统理论(Dijkstra 1965 年提出信号量时引入),同样出现在 OS 层面。同步的终极目标是将并发的乱序转化为类似无并发时的有序。

[辨析] 临界区、同步块与锁保护区域

这三个概念经常被混淆,但实际上是层次关系:

-

临界区(Critical Section):通用并发编程领域的抽象概念,指"访问共享资源的代码段"。例如:

x = 1; y = 2;这段代码如果需要互斥访问,它就是一个临界区。 -

同步块(Synchronized Block):Java 语言层面的语法结构,是临界区的一种实现方式。例如:

synchronized (lock) { x = 1; },其中的{ x = 1; }是临界区,synchronized (lock) { }是同步块。 -

锁保护区域(Lock-Protected Region):运行时概念,指实际被

synchronized或ReentrantLock保护的具体代码区域。例如:当线程执行到synchronized (lock)内的代码时,这块正在执行的代码就是锁保护区域。

层次关系图:

graph TD

A[临界区 Critical Section<br/>抽象概念<br/>访问共享资源的代码段] --> B[同步块 Synchronized Block<br/>Java 语法结构<br/>临界区的实现方式]

B --> C[锁保护区域 Lock-Protected Region<br/>运行时实例<br/>被锁保护的具体代码]

style A fill:#e1f5ff

style B fill:#fff4e1

style C fill:#e8f5e9关键区别:

- 临界区是抽象概念,描述"需要保护什么"

- 同步块是语法工具,描述"如何保护"

- 锁保护区域是运行时实例,描述"当前正在保护什么"

在 Java 里面,最基本的互斥手段就是 synchronized 关键字。它经过编译后,会转化为 monitorenter 和 monitorexit 这两个字节码指令(bytecode instructions)。在执行这两个字节码指令之前,需要先将锁对象的引用压入操作数栈,指令会从栈顶获取这个引用来确定加锁/解锁的对象。这个引用不是一个普通对象实例,就是一个 Class 对象(对于 synchronized 静态方法)。

根据虚拟机规范,在执行 monitorenter 指令时,首先尝试获取对象的锁(实际上就是去用线程信息写 markword)。如果这个对象没有被锁定,或者当前线程已经拥有了那个对象的锁,那么把锁的计数器加1。相应地,在执行 monitorexit 时,会对计数器减1,当计数器为0时,锁就被释放了。从某种意义上来讲,这种设计可以在分布式场景下用 Redis 实现。如果获取锁失败了,那么就会进入阻塞状态,直到对象锁被释放为止。虚拟机规范对 monitorenter 和 monitorexit 两条指令的行为描述中,有两点是需要特别注意的。首先,synchronized同步块对同一条线程来说是可重入的,不会出现自己把自己锁死(阻塞)的情况。其次,同步块在已进入的线程执行完之前,会阻塞后面其他线程的进入。对于映射到操作系统原生进程的实现,不管是阻塞还是唤醒线程,都需要操作系统的调用帮忙,也就会牵涉到用户态转变入核心态的问题(系统控制权从用户空间转入内核空间)。这种切换需要消耗很多 CPU 时间。这也是为什么它是昂贵的原因,时间是最昂贵的。对于很多简单的getter()、setter()操作,花在状态切换上的时间,甚至会多过用户代码执行的时间。甚至可以认为,这样的状态切换需要使用很多的汇编指令代码,以至于要使用很多的 cpu 时钟周期。因此synchronized本身是一种重量级(Heavyweight)操作。JVM(注意,不是Java语言) 本身可能会对重量锁进行优化,使用偏向锁/轻量级锁/锁自旋而非阻塞来避免频繁地切入核心态之中(自旋难道就不浪费CPU 时间了吗?)。

J.U.C包里专门提供了Reentrantlock来实现同步。它同样具有 synchronized 具有的可重入、阻塞其他求锁者的特性。但它还具有三个额外的特点,支持某些场景下的任务调度需求:

- 等待可中断。Lock 接口有实现类可以实现试锁,超时试锁等功能,各种接口都有 interruptibly 版本。这样 synchronized中,其他求锁线程傻等的情况可以避免。

- 公平锁。公平锁指的是按照求锁顺序来分配锁(求锁也是有顺序的,fifo 天然就是公平的)。默认的锁(synchronized 和 ReentrantLock 的默认构造函数)是非公平的,随机给予锁,这样性能更好。synchronized 本身并不内置公平锁,AQS 的非公平锁通过允许插队(新来的线程可以直接尝试 CAS 获取锁,不用排队),来减少 cpu 时间片花在调度/cpu上下文切换上的开销,来获得更高的吞吐。非公平锁的吞吐会更好,而公平锁可避免线程饥饿。ReentrantLock 默认使用非公平锁。

- 绑定多个条件。在 synchronized 的时代,多个 condition 就意味着多层 synchronized。

为什么需要可中断锁?使用场景分析

lock() 不支持中断,线程会一直阻塞直到获取锁。这与原始的 synchronized 行为一致:一旦进入等待,就无法中途退出。而 lockInterruptibly() 的引入,让加解锁不再是单一的对称重复操作,提供了更灵活的控制。

可中断锁的核心价值:让线程在等待锁的过程中能够响应外部中断信号,提前退出等待状态。

典型使用场景

场景 1:线程池优雅关闭

1 | |

为什么场景 1 需要可中断锁?

- 线程池调用

shutdownNow()时,会对所有工作线程调用interrupt() - 如果工作线程使用

lock()阻塞在锁上,无法响应中断,会一直傻等到获取锁 - 使用

lockInterruptibly(),线程会立即抛出InterruptedException,可以快速响应关闭

场景 2:任务超时取消

1 | |

为什么场景 2 需要可中断锁?

- 任务可能因为锁竞争严重而长时间无法获取锁

- 外部调用者可能因为超时需要取消任务

- 使用

lockInterruptibly()或tryLock(timeout),可以让任务快速响应取消

场景 3:分布式锁的锁续期失败

1 | |

为什么场景 3 需要可中断锁?

- 分布式锁可能因为网络问题、Redis 故障等原因续期失败

- 需要快速放弃锁持有,避免其他节点长时间等待

- 可中断锁可以让线程快速响应异常情况

可中断锁 vs 不可中断锁

| 特性 | lock() |

lockInterruptibly() |

|---|---|---|

| 响应中断 | ❌ 不响应 | ✅ 响应 |

| 中断时行为 | 继续阻塞 | 抛出 InterruptedException |

| 适用场景 | 简单互斥,不需要取消 | 需要快速响应外部取消信号 |

| 底层实现 | AQS acquire() |

AQS acquireInterruptibly() |

| 线程状态 | BLOCKED 或 WAITING |

WAITING(可被中断唤醒) |

synchronized 为什么不支持中断?

synchronized 不支持中断是历史设计和 JVM 实现限制的结果:

- 历史原因:

synchronized是 Java 1.0 就存在的语言特性,当时还没有考虑线程中断机制 - JVM 实现:

synchronized的monitorenter指令直接映射到操作系统的互斥锁,无法在中途取消等待 - 语义设计:

synchronized设计为"简单的互斥",ReentrantLock设计为"高级的同步工具"

总结:

- 优先使用

synchronized:对于简单的互斥场景,synchronized的性能和可读性都更好 - 需要可中断时使用

lockInterruptibly():线程池关闭、任务取消、超时控制等场景 - 需要超时时使用

tryLock(timeout):避免长时间等待锁

这种设计体现了 Java 并发库的渐进式复杂度:简单场景用简单工具,复杂场景用高级工具。

synchronized 的性能屡屡被 JVM 的实现者改进,因此还是优先要使用synchronized(《TIJ》、《Java 并发实践》和《深入理解 Java 虚拟机》到此达到了同一结论)。

synchronized 的公平性深入分析

synchronized 是一个非公平锁,这一特性源于其底层实现机制。理解 synchronized 的非公平性,需要从 JVM 的 ObjectMonitor 实现说起。

为什么 synchronized 是非公平的

flowchart TB

subgraph "synchronized 获取锁的竞争过程"

T_NEW["新到达的线程"]

T_QUEUE["队列中等待的线程"]

LOCK["锁(ObjectMonitor)"]

T_NEW -->|"1. 直接尝试 CAS"| LOCK

T_QUEUE -->|"2. 被唤醒后尝试"| LOCK

RESULT{"谁先成功?"}

LOCK --> RESULT

RESULT -->|"新线程先 CAS 成功"| WIN_NEW["新线程获得锁"]

RESULT -->|"队列线程先成功"| WIN_QUEUE["队列线程获得锁"]

style T_NEW fill:#ffcdd2

style T_QUEUE fill:#c8e6c9

style WIN_NEW fill:#ffcdd2

endsynchronized 的非公平性体现在以下几个层面:

| 层面 | 非公平行为 | 原因 |

|---|---|---|

| 偏向锁 | 偏向第一个获取锁的线程 | 优化单线程场景 |

| 轻量级锁 | 自旋竞争,先 CAS 成功者获胜 | 避免线程阻塞开销 |

| 重量级锁 | 新线程可直接尝试获取,不必排队 | 减少上下文切换 |

ObjectMonitor 的 EntryList 竞争机制

当 synchronized 升级为重量级锁后,底层使用 ObjectMonitor 管理等待线程。ObjectMonitor 维护两个队列:

graph TB

subgraph "ObjectMonitor 结构"

OWNER["_owner<br/>当前持有锁的线程"]

subgraph "EntryList"

E1["等待线程 1"]

E2["等待线程 2"]

E3["等待线程 3"]

end

subgraph "cxq (Contention Queue)"

C1["新竞争线程 A"]

C2["新竞争线程 B"]

end

NEW_THREAD["新到达的线程"]

NEW_THREAD -->|"1. 先尝试直接获取"| OWNER

NEW_THREAD -->|"2. 失败则进入 cxq"| C1

OWNER -->|"释放锁时"| WAKE["唤醒策略"]

WAKE -->|"可能唤醒"| E1

WAKE -->|"也可能唤醒"| C1

end

style NEW_THREAD fill:#fff9c4

style OWNER fill:#c8e6c9关键点:当锁被释放时,JVM 并不保证 EntryList 中等待最久的线程一定能获得锁。新到达的线程可以"插队"直接尝试获取锁,这就是非公平的本质。

synchronized 与 ReentrantLock 公平性对比

graph LR

subgraph "synchronized(非公平,不可配置)"

S_NEW["新线程"] -->|"直接 CAS"| S_LOCK["锁"]

S_QUEUE["队列线程"] -->|"被唤醒后竞争"| S_LOCK

end

subgraph "ReentrantLock(可配置)"

subgraph "非公平模式(默认)"

NF_NEW["新线程"] -->|"直接 CAS"| NF_LOCK["锁"]

NF_QUEUE["队列线程"] -->|"被唤醒后竞争"| NF_LOCK

end

subgraph "公平模式"

F_NEW["新线程"] -->|"检查队列"| F_CHECK{"队列空?"}

F_CHECK -->|"否"| F_ENQUEUE["必须排队"]

F_CHECK -->|"是"| F_LOCK["锁"]

F_QUEUE["队列线程"] -->|"按顺序获取"| F_LOCK

end

end| 特性 | synchronized | ReentrantLock(非公平) | ReentrantLock(公平) |

|---|---|---|---|

| 公平性 | 非公平 | 非公平 | 公平 |

| 可配置 | 否 | 是 | 是 |

| 吞吐量 | 高 | 高 | 较低 |

| 线程饥饿风险 | 存在 | 存在 | 无 |

| 适用场景 | 通用 | 高吞吐优先 | 顺序敏感场景 |

非公平锁的性能优势

非公平锁的设计是一个经过深思熟虑的权衡。其性能优势来源于:

- 减少线程唤醒开销:新线程可能在队列线程被唤醒之前就获得锁并完成工作

- 减少上下文切换:避免不必要的线程状态转换

- 提高 CPU 缓存命中率:刚释放锁的线程再次获取锁时,相关数据可能还在缓存中

sequenceDiagram

participant T1 as 线程1(持有锁)

participant T2 as 线程2(队列中)

participant T3 as 线程3(新到达)

participant Lock as 锁

Note over T1,Lock: 非公平锁场景

T1->>Lock: 释放锁

T3->>Lock: 同时到达,直接 CAS

T3->>Lock: CAS 成功,获得锁

Note over T3: T3 执行临界区(很短)

T3->>Lock: 释放锁

Lock->>T2: 唤醒 T2

T2->>Lock: 获得锁

Note over T1,Lock: 如果是公平锁

Note over T3: T3 必须等待 T2 先执行

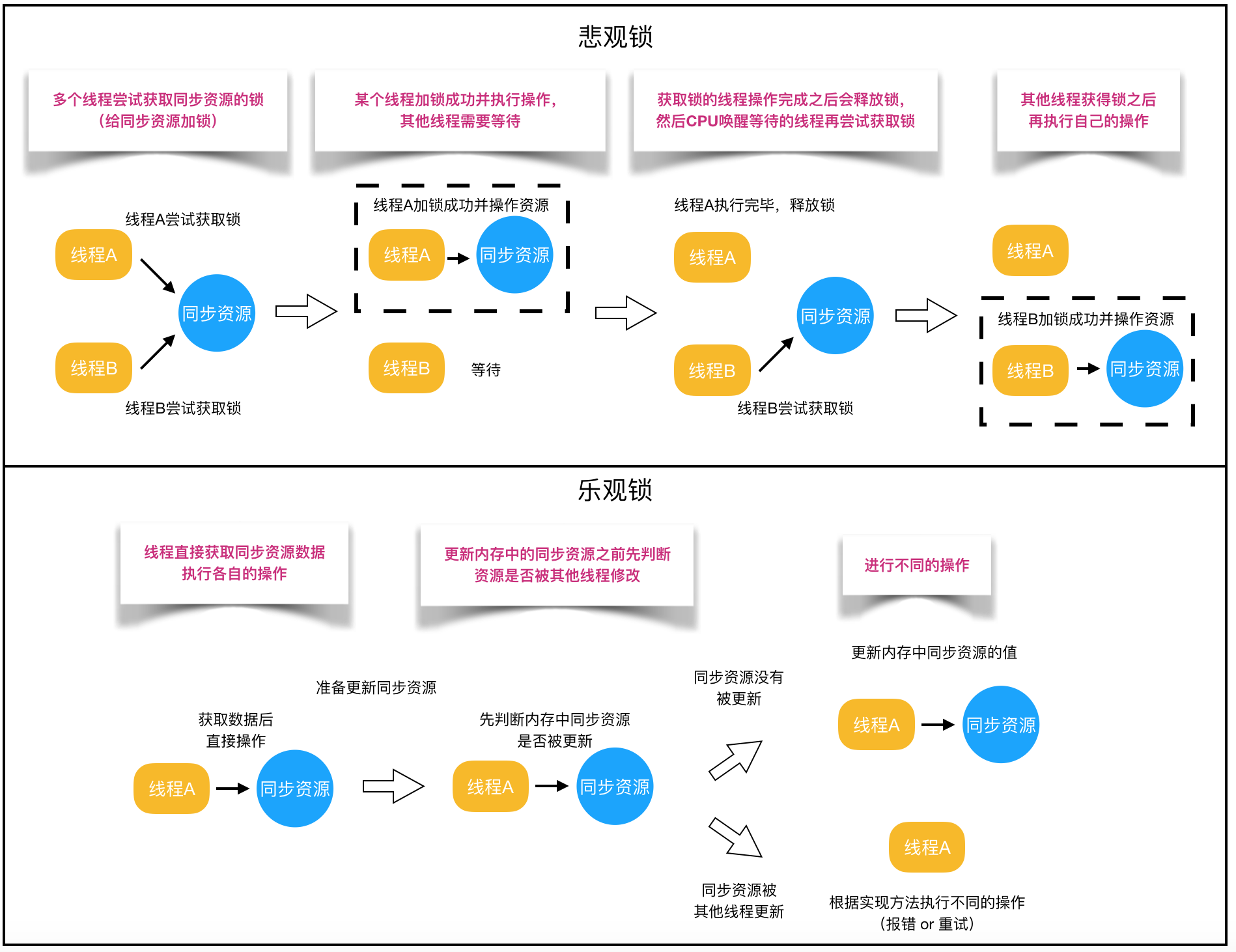

Note over T3: 增加了一次上下文切换非阻塞同步(Non-Blocking Synchronization)

也就是我们常说的乐观策略。不需要加锁,也就不需要负担线程状态切换的代价。但代价是,如果真的发生了冲突,乐观操作需要付出的代价就是补偿(compensation)。最常见的补偿,应该就是不断重试(又要引入自旋了)。乐观锁的核心基石,实际上是 CAS(CompareAndSet或者 CompareAndSwap),这两个操作必须是原子化操作,这就要求现代的处理器提供这样的指令原语(instruction primitive)。JVM 虚拟机里,专门通过 Unsafe 包来向上层提供这种原语的语义。

CAS操作有一个很讨厌的 ABA 问题。虽然 ABA 问题本身在大部分情况下不会引起问题,但J.U.C还是提供了一个 AtomicStampedReference操作来避免这个问题(所以说,带版本的原子值才是最安全的)。在大多数情况下,进入互斥同步,还比用这些鸡肋功能要高效。所有自旋都满足如下规律:低度竞争自旋优于真正的 mutex 互斥锁定,高度竞争自旋会浪费 cpu-低度竞争适合线程活跃等待,高度竞争适合线程阻塞等待。

无同步方案

可重入代码(Reentrant Code)

也叫纯代码(Pure Code)。在它执行的任意时刻中断它,转而去执行另一段代码,再切换上下文回来以后,不会发生任何错误。所有可重入的代码都是线程安全的,但并非所有线程安全的代码都是可重入的。

可重入代码的特征:

- 不依赖任何非常量的全局变量或静态变量

- 不修改自身的代码

- 不调用不可重入的函数

- 所有数据都通过参数传递或使用局部变量(栈封闭)

这类似于函数式编程里的纯函数,函数的行为完全由输入参数决定,结果可预测,不依赖也不修改外部状态。这也是为什么函数式编程在高并发下是安全的,它们天然满足栈封闁的标准。

线程本地存储(Thread Local Storage)

请参阅专题文章:ThreadLocal 的设计模式

对象头

需要参考:

在 32 位虚拟机里:

1 | |

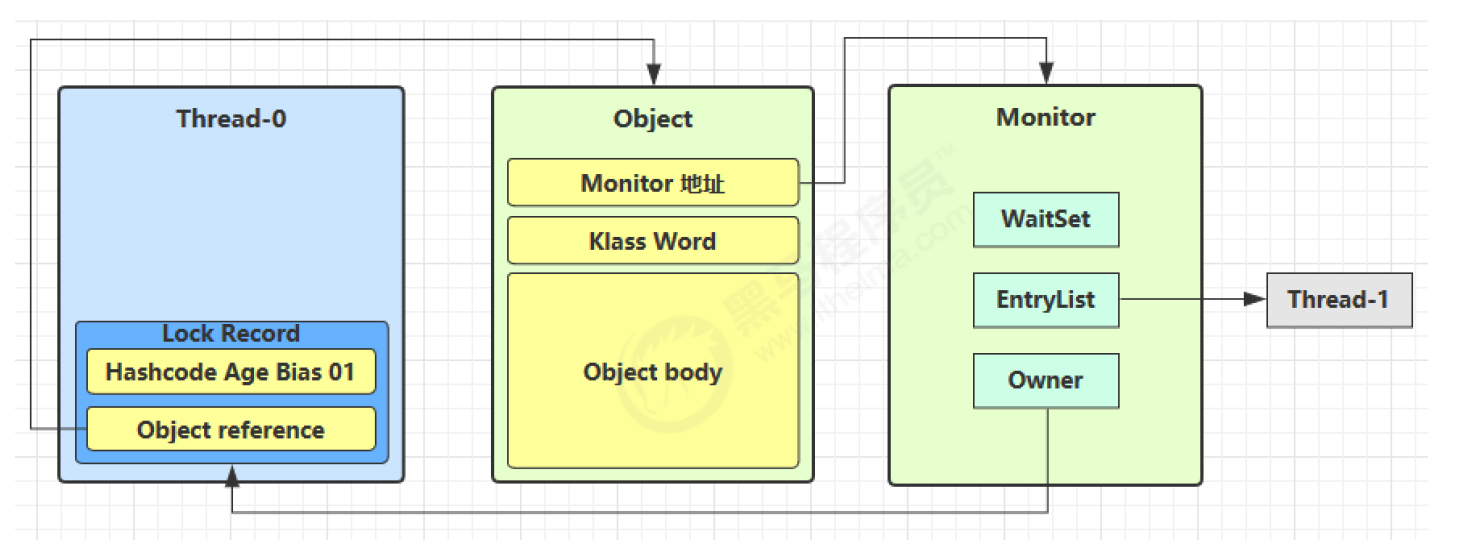

我们大致上认为一个对象应该分为 object header 和 object body,然后再把 header 分为 Mark Word 和 Klass Pointer。

为什么叫 Mark Word?

- Mark = 标记/标志,因为这个字段用于存储对象的各种运行时标记信息

- Word = 机器字长(32 位或 64 位),表示它占用一个机器字的空间

- 存储内容(根据锁状态动态变化):

- 无锁状态:对象的 hashCode、GC 分代年龄(age)、锁标志位

- 偏向锁状态:偏向线程 ID、epoch、GC 分代年龄、锁标志位

- 轻量级锁状态:指向栈中 Lock Record 的指针

- 重量级锁状态:指向 Monitor 对象的指针

- GC 标记状态:用于垃圾回收

为什么叫 Klass Word(类型字)?

- Klass 是 HotSpot 虚拟机中对 Java 类元数据的 C++ 表示(注意不是 Class,而是 Klass,这是 HotSpot 源码中的命名约定)

- Word = 机器字长(32 位或 64 位),表示它占用一个机器字的空间

- 本质上是一个指针,指向方法区中该对象所属类的元数据(Klass 对象)

- 存储内容:指向方法区中

InstanceKlass(普通对象)或ArrayKlass(数组对象)的指针 - 作用:JVM 通过这个指针确定对象是哪个类的实例,从而找到类的方法表、字段布局等信息

术语说明:在不同的技术文档中,你可能会看到 Klass Word 和 Klass Pointer 两种叫法,它们指的是同一个东西。Klass Word 强调它占用一个机器字的空间(与 Mark Word 对应),Klass Pointer 强调它的本质是一个指针。本文统一使用 Klass Word 以与对象头结构图保持一致。

Klass Pointer 与类元数据的关系

Klass Pointer 指向的究竟是什么?当 .class 文件被类加载器加载进 JVM 后,字节码中的类型信息会被解析并存储在方法区(JDK 8+ 为 Metaspace)中,形成 HotSpot 内部的 C++ 数据结构——Klass。

图:从 .class 文件到对象实例的完整链路

graph TB

subgraph "编译期"

JAVA["Java 源文件<br/>━━━━━━━━━━━━━━━━━━━━<br/>MyClass.java"]

JAVAC["javac 编译器"]

CLASS["字节码文件<br/>━━━━━━━━━━━━━━━━━━━━<br/>MyClass.class<br/>(魔数、版本、常量池、<br/>字段表、方法表...)"]

JAVA --> JAVAC --> CLASS

style JAVA fill:#e8f5e9

style CLASS fill:#fff9c4

end

subgraph "运行期 - 类加载"

CL["类加载器<br/>ClassLoader"]

CLASS --> CL

end

subgraph "方法区 / Metaspace"

direction TB

subgraph "Klass 层次结构(C++ 对象)"

KLASS["Klass(抽象基类)<br/>━━━━━━━━━━━━━━━━━━━━<br/>所有类元数据的基类"]

IK["InstanceKlass<br/>━━━━━━━━━━━━━━━━━━━━<br/>普通类的元数据<br/>• vtable(虚方法表)<br/>• itable(接口方法表)<br/>• 字段布局信息<br/>• 常量池引用<br/>• 方法字节码"]

AK["ArrayKlass<br/>━━━━━━━━━━━━━━━━━━━━<br/>数组类的元数据"]

OAK["ObjArrayKlass<br/>━━━━━━━━━━━━━━━━━━━━<br/>对象数组<br/>如 String[]"]

TAK["TypeArrayKlass<br/>━━━━━━━━━━━━━━━━━━━━<br/>基本类型数组<br/>如 int[], byte[]"]

KLASS --> IK

KLASS --> AK

AK --> OAK

AK --> TAK

end

MIRROR["java.lang.Class 对象<br/>(Mirror 对象)<br/>━━━━━━━━━━━━━━━━━━━━<br/>Java 层面的类对象<br/>MyClass.class"]

IK <-->|"双向引用"| MIRROR

style KLASS fill:#e1f5ff

style IK fill:#c8e6c9

style AK fill:#fff9c4

style OAK fill:#ffecb3

style TAK fill:#ffecb3

style MIRROR fill:#f3e5f5

end

CL -->|"解析字节码<br/>创建 Klass"| IK

subgraph "堆(Heap)"

direction TB

subgraph "普通对象实例"

OBJ1["对象实例 obj1<br/>━━━━━━━━━━━━━━━━━━━━<br/>Object Header:<br/>┌─────────────────┐<br/>│ Mark Word (8B) │<br/>├─────────────────┤<br/>│ Klass Ptr (4/8B)│───────<br/>└─────────────────┘<br/>━━━━━━━━━━━━━━━━━━━━<br/>Instance Data"]

end

subgraph "数组对象实例"

ARR["数组实例 arr<br/>━━━━━━━━━━━━━━━━━━━━<br/>Object Header:<br/>┌─────────────────┐<br/>│ Mark Word (8B) │<br/>├─────────────────┤<br/>│ Klass Ptr (4/8B)│───────<br/>├─────────────────┤<br/>│ Array Length(4B)│<br/>└─────────────────┘<br/>━━━━━━━━━━━━━━━━━━━━<br/>Array Elements"]

end

style OBJ1 fill:#e1f5ff

style ARR fill:#fff9c4

end

OBJ1 -->|"Klass Pointer"| IK

ARR -->|"Klass Pointer"| OAK

note1["关键理解:<br/>1. Klass 是 HotSpot 中类元数据的 C++ 表示<br/>2. InstanceKlass 对应普通 Java 类<br/>3. ArrayKlass 对应数组类型<br/>4. 每个对象的 Klass Pointer 指向其类型的 Klass<br/>5. java.lang.Class 是 Klass 在 Java 层的镜像"]

style note1 fill:#fff9c4图:Klass Pointer 的指针压缩

graph LR

subgraph "64 位 JVM - 未压缩"

OH1["Object Header<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word: 8 bytes<br/>Klass Ptr: 8 bytes<br/>━━━━━━━━━━━━━━━━━━━━<br/>总计: 16 bytes"]

style OH1 fill:#ffcdd2

end

subgraph "64 位 JVM - 压缩指针(默认)"

OH2["Object Header<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word: 8 bytes<br/>Klass Ptr: 4 bytes<br/>━━━━━━━━━━━━━━━━━━━━<br/>总计: 12 bytes<br/>(+ 4 bytes padding = 16)"]

style OH2 fill:#c8e6c9

end

OH1 -->|"-XX:+UseCompressedClassPointers<br/>(堆 < 32GB 时默认开启)"| OH2

note["压缩指针原理:<br/>• 将 64 位指针压缩为 32 位<br/>• 通过左移 3 位还原(8 字节对齐)<br/>• 可寻址 32GB 的 Metaspace"]

style note fill:#fff9c4核心概念澄清:

| 概念 | 层面 | 说明 |

|---|---|---|

| Klass | C++ (HotSpot 内部) | 类元数据的抽象基类,是 HotSpot 对 Java 类型系统的内部表示 |

| InstanceKlass | C++ (HotSpot 内部) | 普通 Java 类的元数据,包含 vtable、字段布局、方法字节码等 |

| ArrayKlass | C++ (HotSpot 内部) | 数组类型的元数据,分为 ObjArrayKlass 和 TypeArrayKlass |

| java.lang.Class | Java | Klass 在 Java 层的"镜像"对象,通过 MyClass.class 获取 |

| Klass Pointer | 对象头 | 每个对象实例中指向其 Klass 的指针,占 1 个机器字(可压缩) |

为什么叫 Klass 而不是 Class?

这是 HotSpot 源码的命名约定。由于 C++ 中 class 是保留关键字,无法用作类名,因此 HotSpot 开发者使用 Klass 来表示 Java 类的元数据。这个命名也体现了它与 Java 层 java.lang.Class 的区别——Klass 是 VM 内部的 C++ 对象,而 Class 是 Java 层的反射对象。

为什么放在对象头?

- 这两个信息是 JVM 管理对象的核心元数据,每个对象都必须携带

- Mark Word 支持 synchronized 锁机制和 GC

- Klass Word 支持方法调用(虚方法表查找)和类型检查(instanceof)

两个 Word 的结构特性差异:

在不同的 JVM 实现中(32 位 vs 64 位),这两个 Word 都是固定的机器字长(32 bits 或 64 bits),但它们的结构可变性完全不同:

| 字段 | 大小 | 结构是否可变 | 说明 |

|---|---|---|---|

| Mark Word | 32/64 bits | 可变 | 根据锁状态动态变化,像 C 语言的 union,同一块内存在不同状态下存储不同含义的数据 |

| Klass Word | 32/64 bits | 固定 | 始终是一个指向方法区类元数据的指针,结构从不改变 |

这种设计体现了不同的职责:

- Klass Word 是静态的:对象的类型在创建后就确定了,永远不会改变,所以 Klass Word 只需要存储一个固定的指针

- Mark Word 是动态的:对象的运行时状态(锁状态、GC 年龄、hashCode 等)会随着程序执行而变化,所以 Mark Word 需要能够"变形"来适应不同的场景

锁升级时原始信息去哪了?

Mark Word 的各种状态是互斥的,锁升级时原始信息(hashCode、age 等)会被转移保存。关于三种锁对 Mark Word 的详细处理策略,请参见下文偏向锁章节的"三种锁对 Mark Word 的处理策略"。

这也解释了为什么轻量级锁解锁时必须用 CAS 把 Displaced Mark Word 写回——就是为了恢复原始的 Mark Word 信息。如果 CAS 失败,说明锁已膨胀,原始信息已转移到 ObjectMonitor 中。

Mark Word 本身在对象生命周期里面表现得像 union 一样可变,是让研究 synchronized 的人最头痛的。

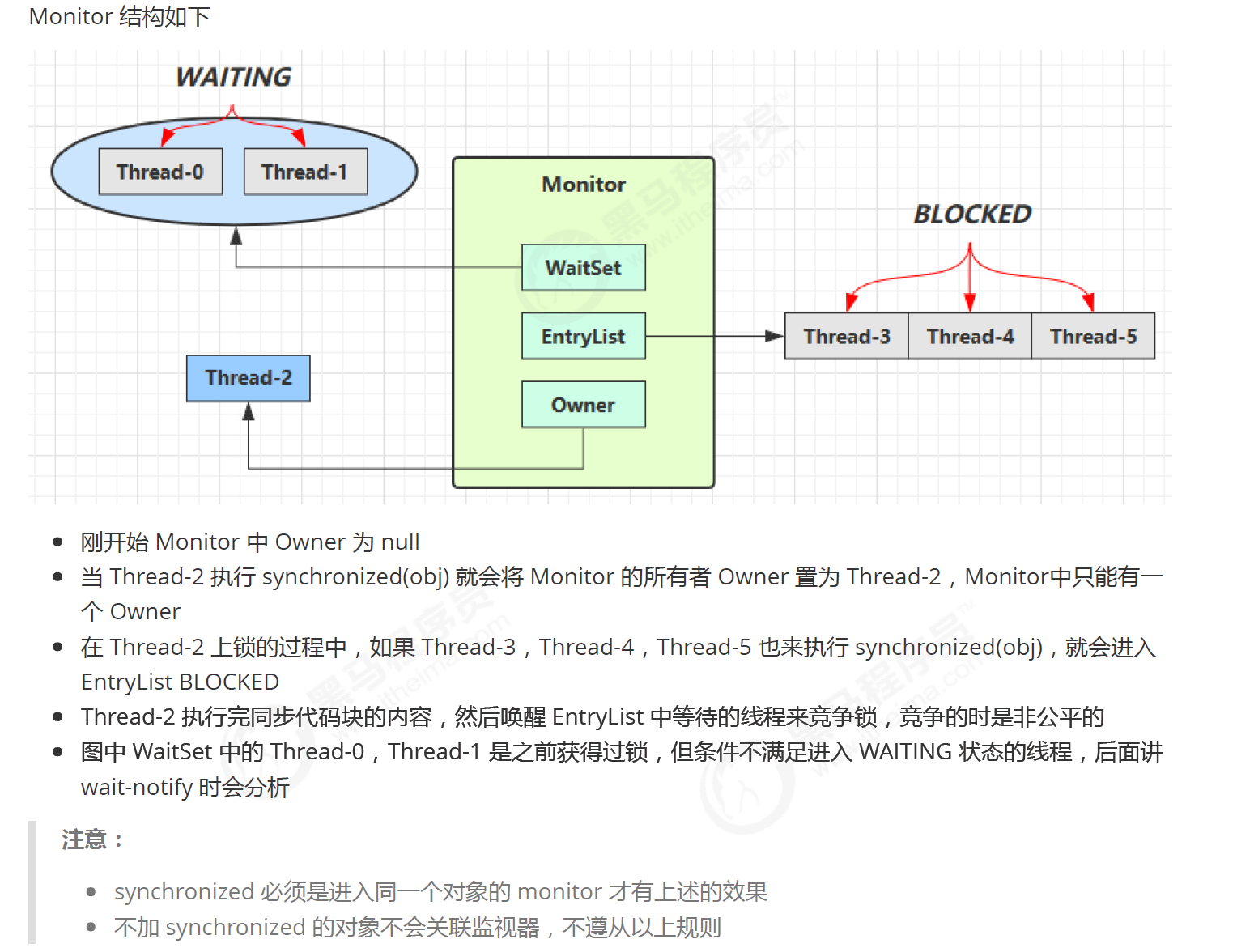

通常我们可以看到 thread 会维护 lock record/monitor record;monitor 会维护两种 set 和 owner(aqs 原理的原型),似乎可以被看成操作系统的 mutext lock 在 jvm 里的句柄;object 本身使用一个 object header。

Mark Word 与 Monitor 的关系

核心要点:Mark Word 只保存 Monitor 的引用(指针),而不保存 Monitor 的具体信息。

虽然 Mark Word 是一个多变的数据结构(根据锁状态动态变化),但在重量级锁状态下,它会保存指向 Monitor 对象的指针。而真正的锁管理信息——包括 Owner(当前持有锁的线程)、EntryList(阻塞等待锁的线程队列)、WaitSet(调用 wait() 后等待的线程集合)——都存储在 Monitor 这个独立的数据结构中。

Monitor(ObjectMonitor)的核心字段:

| 字段 | 类型 | 说明 |

|---|---|---|

_header |

markOop | 保存对象原始的 Mark Word(用于锁释放时恢复) |

_owner |

void* | 指向当前持有锁的线程 |

_EntryList |

ObjectWaiter* | 阻塞在 synchronized 入口处的线程链表 |

_WaitSet |

ObjectWaiter* | 调用 wait() 后进入等待状态的线程集合 |

_recursions |

intptr_t | 锁的重入次数 |

_count |

volatile intptr_t | 等待获取锁的线程数 |

图1:锁对象、Mark Word 与 Monitor 的引用关系

graph TB

subgraph "Java 对象"

OBJ[Object]

subgraph "Object Header"

MW[Mark Word<br/>64 bits]

KP[Klass Pointer]

end

BODY[Object Body<br/>实例数据]

OBJ --> MW

OBJ --> KP

OBJ --> BODY

end

subgraph "Monitor 对象(ObjectMonitor)"

MON[ObjectMonitor]

HEADER["_header<br/>原始 Mark Word 备份"]

OWNER["_owner<br/>当前持锁线程"]

ENTRY["_EntryList<br/>阻塞等待队列"]

WAIT["_WaitSet<br/>wait() 等待集合"]

REC["_recursions<br/>重入次数"]

MON --> HEADER

MON --> OWNER

MON --> ENTRY

MON --> WAIT

MON --> REC

end

subgraph "线程"

T1[Thread-1<br/>持有锁]

T2[Thread-2<br/>阻塞等待]

T3[Thread-3<br/>wait 等待]

end

MW -->|"重量级锁状态<br/>ptr_to_heavyweight_monitor"| MON

OWNER -->|指向| T1

ENTRY -->|包含| T2

WAIT -->|包含| T3

style MW fill:#e1f5ff

style MON fill:#fff4e6

style HEADER fill:#e8f5e9

style OWNER fill:#ffcdd2

style ENTRY fill:#fff9c4

style WAIT fill:#e1bee7图2:不同锁状态下 Mark Word 的内容变化

graph TB

subgraph "无锁状态 (01)"

MW1["Mark Word<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>unused:25 | hashcode:31 | unused:1 | age:4 | 0 | 01<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>直接存储 hashCode 和 GC 年龄"]

style MW1 fill:#c8e6c9

end

subgraph "偏向锁状态 (01)"

MW2["Mark Word<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>thread:54 | epoch:2 | unused:1 | age:4 | 1 | 01<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>存储偏向线程 ID,无需 Monitor"]

style MW2 fill:#fff9c4

end

subgraph "轻量级锁状态 (00)"

MW3["Mark Word<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>ptr_to_lock_record:62 | 00<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>指向线程栈帧中的 Lock Record<br/>原始 Mark Word 保存在 Lock Record 中"]

LR["Lock Record<br/>(线程栈帧中)<br/>━━━━━━━━━━━━<br/>Displaced Mark Word<br/>(原始 Mark Word 备份)"]

MW3 -.->|指向| LR

style MW3 fill:#bbdefb

style LR fill:#e3f2fd

end

subgraph "重量级锁状态 (10)"

MW4["Mark Word<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>ptr_to_heavyweight_monitor:62 | 10<br/>━━━━━━━━━━━━━━━━━━━━━━━━━━━━<br/>只存储 Monitor 指针!<br/>所有锁信息都在 Monitor 中"]

MON4["ObjectMonitor<br/>━━━━━━━━━━━━━━━━━━━━<br/>_header: 原始 Mark Word<br/>_owner: 持锁线程<br/>_EntryList: 阻塞队列<br/>_WaitSet: 等待集合<br/>_recursions: 重入次数"]

MW4 -.->|指向| MON4

style MW4 fill:#ffcdd2

style MON4 fill:#ffebee

end

MW1 -->|"第一次加锁<br/>(无竞争)"| MW2

MW2 -->|"出现竞争<br/>撤销偏向"| MW3

MW3 -->|"竞争激烈<br/>锁膨胀"| MW4图3:重量级锁下 Monitor 的工作机制

sequenceDiagram

participant T1 as Thread-1

participant OBJ as 锁对象

participant MW as Mark Word

participant MON as ObjectMonitor

participant T2 as Thread-2

participant T3 as Thread-3

Note over OBJ,MON: 初始状态:无锁

T1->>OBJ: synchronized(obj)

OBJ->>MW: 检查锁状态

MW->>MON: 锁膨胀,创建 Monitor

Note over MW: Mark Word 变为<br/>ptr_to_monitor | 10

MON->>MON: _owner = Thread-1

Note over T1,MON: Thread-1 成功获取锁

T2->>OBJ: synchronized(obj)

OBJ->>MW: 检查锁状态

MW->>MON: 获取 Monitor 引用

MON->>MON: 检查 _owner != null

MON->>MON: Thread-2 加入 _EntryList

Note over T2: Thread-2 阻塞等待

T1->>MON: obj.wait()

MON->>MON: Thread-1 移入 _WaitSet

MON->>MON: _owner = null

MON->>MON: 从 _EntryList 唤醒 Thread-2

MON->>MON: _owner = Thread-2

Note over T2,MON: Thread-2 获取锁

T3->>MON: obj.notify()

MON->>MON: 从 _WaitSet 移出 Thread-1

MON->>MON: Thread-1 加入 _EntryList

Note over T1: Thread-1 等待重新竞争锁图4:锁状态转换与数据存储位置

graph LR

subgraph "锁状态"

UNLOCK[无锁<br/>01]

BIASED[偏向锁<br/>01]

LIGHT[轻量级锁<br/>00]

HEAVY[重量级锁<br/>10]

end

subgraph "原始信息存储位置"

IN_MW["在 Mark Word 中"]

IN_LR["在 Lock Record 中<br/>(线程栈帧)"]

IN_MON["在 Monitor 的<br/>_header 字段中"]

end

subgraph "锁管理信息"

NO_LOCK["无需管理"]

THREAD_ID["线程 ID 在 Mark Word"]

LR_PTR["Lock Record 指针在 Mark Word"]

MON_ALL["Owner/EntryList/WaitSet<br/>全部在 Monitor 中"]

end

UNLOCK -->|hashCode/age| IN_MW

UNLOCK -->|锁信息| NO_LOCK

BIASED -->|hashCode/age| IN_MW

BIASED -->|锁信息| THREAD_ID

LIGHT -->|hashCode/age| IN_LR

LIGHT -->|锁信息| LR_PTR

HEAVY -->|hashCode/age| IN_MON

HEAVY -->|锁信息| MON_ALL

UNLOCK -->|首次加锁| BIASED

BIASED -->|竞争| LIGHT

LIGHT -->|膨胀| HEAVY

style UNLOCK fill:#c8e6c9

style BIASED fill:#fff9c4

style LIGHT fill:#bbdefb

style HEAVY fill:#ffcdd2

style IN_MW fill:#e8f5e9

style IN_LR fill:#e3f2fd

style IN_MON fill:#ffebee关键理解:

-

Mark Word 是"指针容器"而非"数据容器":在轻量级锁和重量级锁状态下,Mark Word 不再直接存储 hashCode 等原始信息,而是存储指向其他数据结构的指针。

-

Monitor 是独立的数据结构:ObjectMonitor 是 JVM 在 C++ 层面实现的对象,它独立于 Java 对象存在。当锁膨胀为重量级锁时,JVM 会创建(或复用)一个 ObjectMonitor 对象,并将其地址写入 Mark Word。

-

原始信息的"流转":

- 无锁/偏向锁:原始信息直接在 Mark Word 中

- 轻量级锁:原始信息被拷贝到线程栈帧的 Lock Record 中

- 重量级锁:原始信息被保存到 Monitor 的

_header字段中

-

解锁时的恢复:无论是轻量级锁还是重量级锁,解锁时都需要将原始的 Mark Word 恢复回去。这就是为什么轻量级锁解锁时需要 CAS 操作——它要把 Lock Record 中保存的 Displaced Mark Word 写回对象头。

Monitor 与操作系统同步原语的关系

什么是原语(Primitive)?

在讨论锁的底层实现之前,我们需要先理解一个核心概念:原语(Primitive)。

原语的定义:

原语是指由若干条机器指令组成的、用于完成特定功能的不可分割的基本操作。"不可分割"意味着原语的执行过程不会被中断——要么全部执行完成,要么完全不执行,不存在执行到一半的中间状态。

原语的层次结构:

在计算机系统中,原语存在于不同的层次,它们之间有明确的依赖关系:

graph TB

subgraph "应用层"

JAVA["Java 同步机制<br/>━━━━━━━━━━━━━━━━━━━━<br/>synchronized<br/>ReentrantLock<br/>Semaphore"]

style JAVA fill:#c8e6c9

end

subgraph "JVM 层"

JVM["JVM 同步原语<br/>━━━━━━━━━━━━━━━━━━━━<br/>ObjectMonitor<br/>Parker<br/>Unsafe.park/unpark"]

style JVM fill:#fff9c4

end

subgraph "操作系统层"

OS["操作系统同步原语<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mutex(互斥量)<br/>Semaphore(信号量)<br/>Condition Variable(条件变量)<br/>Futex(Linux 快速用户态互斥)"]

style OS fill:#ffcc80

end

subgraph "硬件/CPU 层"

CPU["CPU 指令原语<br/>━━━━━━━━━━━━━━━━━━━━<br/>CAS(Compare-And-Swap)<br/>LL/SC(Load-Linked/Store-Conditional)<br/>Memory Barrier(内存屏障)<br/>LOCK 前缀指令(x86)"]

style CPU fill:#ffcdd2

end

JAVA -->|"依赖"| JVM

JVM -->|"依赖"| OS

OS -->|"依赖"| CPU

note1["关键理解:<br/>上层原语由下层原语组合实现<br/>最底层是 CPU 提供的原子指令"]

style note1 fill:#e1f5ffCPU 指令原语(Instruction Primitives):

CPU 指令原语是最底层的原子操作,由硬件直接保证其原子性。常见的 CPU 指令原语包括:

| 指令原语 | 架构 | 功能 | 在 Java 中的体现 |

|---|---|---|---|

| CAS(Compare-And-Swap) | x86: CMPXCHGARM: LDREX/STREX |

比较并交换:如果内存值等于预期值,则更新为新值 | Unsafe.compareAndSwapInt()AtomicInteger.compareAndSet() |

| LOCK 前缀 | x86 | 锁定总线或缓存行,确保后续指令的原子性 | CAS 指令的底层实现 |

| Memory Barrier | 所有架构 | 防止指令重排序,确保内存可见性 | volatile 的底层实现 |

| XCHG | x86 | 原子交换两个值 | 自旋锁的底层实现 |

操作系统同步原语(OS Synchronization Primitives):

操作系统基于 CPU 指令原语,提供了更高级的同步机制:

| OS 原语 | 功能 | 特点 | 对应的 Java 机制 |

|---|---|---|---|

| Mutex(互斥量) | 保证同一时刻只有一个线程进入临界区 | 阻塞式,需要系统调用 | synchronized(重量级锁) |

| Semaphore(信号量) | 控制同时访问资源的线程数量 | 可以允许多个线程同时访问 | java.util.concurrent.Semaphore |

| Condition Variable(条件变量) | 线程等待特定条件成立 | 必须与 Mutex 配合使用 | Object.wait()/notify() |

| Futex(Fast Userspace Mutex) | Linux 特有的快速互斥量 | 无竞争时在用户态完成,有竞争时才进入内核 | JVM 在 Linux 上的锁实现 |

指令原语与操作系统原语的关系:

graph LR

subgraph "CPU 指令原语"

CAS["CAS 指令"]

LOCK["LOCK 前缀"]

BARRIER["Memory Barrier"]

end

subgraph "操作系统原语"

MUTEX["Mutex"]

FUTEX["Futex"]

COND["Condition Variable"]

end

CAS -->|"构建"| FUTEX

CAS -->|"构建"| MUTEX

LOCK -->|"保证原子性"| CAS

BARRIER -->|"保证可见性"| MUTEX

MUTEX -->|"配合使用"| COND

note["OS 原语 = CPU 原语 + 线程调度 + 等待队列<br/>OS 原语提供了线程阻塞/唤醒的能力<br/>CPU 原语只能自旋等待"]

style note fill:#fff9c4为什么需要操作系统原语?

CPU 指令原语(如 CAS)只能实现自旋等待——线程不断循环检查条件是否满足。这种方式在等待时间短时效率很高,但如果等待时间长,会浪费大量 CPU 资源。

操作系统原语(如 Mutex)提供了阻塞等待的能力——线程可以被挂起,不占用 CPU,等条件满足时再被唤醒。这需要操作系统内核的支持,因为只有内核才能控制线程的调度。

| 等待方式 | 实现基础 | CPU 占用 | 适用场景 |

|---|---|---|---|

| 自旋等待 | CPU 指令原语(CAS) | 高(持续占用 CPU) | 等待时间极短(< 几微秒) |

| 阻塞等待 | OS 原语(Mutex) | 低(线程挂起) | 等待时间较长(> 几微秒) |

这也解释了为什么 JVM 的锁优化策略是"先自旋,后阻塞"——先用 CPU 原语尝试快速获取锁,如果失败再退化到 OS 原语进行阻塞等待。

核心问题:ObjectMonitor 是如何实现线程阻塞和唤醒的?

前面我们知道,重量级锁的核心是 ObjectMonitor,它管理着 Owner、EntryList、WaitSet 等数据结构。但 ObjectMonitor 本身只是一个 JVM 层面的 C++ 对象,它无法直接让线程阻塞或唤醒——这些操作必须依赖操作系统提供的同步原语。

图1:从 synchronized 到操作系统的完整调用链

graph TB

subgraph "Java 层"

SYNC["synchronized(obj)"]

style SYNC fill:#c8e6c9

end

subgraph "JVM 层(HotSpot C++)"

INTERP["字节码解释器<br/>monitorenter/monitorexit"]

OBJMON["ObjectMonitor<br/>━━━━━━━━━━━━━━━━━━━━<br/>enter() / exit()<br/>wait() / notify()"]

PARKER["Parker<br/>━━━━━━━━━━━━━━━━━━━━<br/>park() / unpark()<br/>每个线程一个 Parker 实例"]

INTERP --> OBJMON

OBJMON -->|"竞争失败<br/>需要阻塞"| PARKER

style INTERP fill:#fff9c4

style OBJMON fill:#ffcc80

style PARKER fill:#ffab91

end

subgraph "操作系统层"

subgraph "Linux"

FUTEX["futex()<br/>━━━━━━━━━━━━━━━━━━━━<br/>Fast Userspace Mutex<br/>用户态/内核态混合"]

PTHREAD_L["pthread_mutex_t<br/>pthread_cond_t"]

FUTEX --> PTHREAD_L

style FUTEX fill:#e1bee7

style PTHREAD_L fill:#ce93d8

end

subgraph "macOS/BSD"

PTHREAD_M["pthread_mutex_t<br/>pthread_cond_t"]

style PTHREAD_M fill:#ce93d8

end

subgraph "Windows"

CRITICAL["CRITICAL_SECTION<br/>WaitForSingleObject"]

style CRITICAL fill:#90caf9

end

end

PARKER -->|"Linux"| FUTEX

PARKER -->|"macOS"| PTHREAD_M

PARKER -->|"Windows"| CRITICAL

note1["关键洞察:<br/>ObjectMonitor 不直接调用 OS 原语<br/>而是通过 Parker 这个中间层<br/>Parker 封装了跨平台的阻塞/唤醒逻辑"]

style note1 fill:#e1f5ff图2:ObjectMonitor 内部的同步机制

graph TB

subgraph "ObjectMonitor 内部结构"

direction TB

subgraph "数据字段"

OWNER["_owner<br/>当前持锁线程"]

ENTRY["_EntryList<br/>阻塞等待队列"]

WAIT["_WaitSet<br/>wait() 等待集合"]

CXQUEUE["_cxq<br/>竞争队列(新来的线程)"]

style OWNER fill:#ffcdd2

style ENTRY fill:#fff9c4

style WAIT fill:#e1bee7

style CXQUEUE fill:#b2dfdb

end

subgraph "同步原语(平台相关)"

MUTEX["底层 Mutex<br/>━━━━━━━━━━━━━━━━━━━━<br/>保护 ObjectMonitor 自身<br/>的数据结构一致性"]

EVENT["Park/Unpark 事件<br/>━━━━━━━━━━━━━━━━━━━━<br/>用于线程阻塞/唤醒"]

style MUTEX fill:#ffcc80

style EVENT fill:#ffab91

end

end

subgraph "线程状态转换"

T_RUN["RUNNABLE<br/>运行中"]

T_BLOCK["BLOCKED<br/>阻塞等待锁"]

T_WAIT["WAITING<br/>wait() 等待"]

T_RUN -->|"获取锁失败<br/>park()"| T_BLOCK

T_BLOCK -->|"获取锁成功<br/>unpark()"| T_RUN

T_RUN -->|"调用 wait()<br/>park()"| T_WAIT

T_WAIT -->|"被 notify()<br/>unpark()"| T_BLOCK

style T_RUN fill:#c8e6c9

style T_BLOCK fill:#ffcdd2

style T_WAIT fill:#e1bee7

end

MUTEX -.->|"保护"| OWNER

MUTEX -.->|"保护"| ENTRY

MUTEX -.->|"保护"| WAIT

EVENT -.->|"阻塞/唤醒"| T_BLOCK

EVENT -.->|"阻塞/唤醒"| T_WAITObjectMonitor 与 OS 原语的对应关系:

| ObjectMonitor 操作 | 对应的 OS 原语 | 说明 |

|---|---|---|

enter() 获取锁失败 |

pthread_mutex_lock() 或 futex(FUTEX_WAIT) |

线程阻塞,进入 EntryList |

exit() 释放锁 |

pthread_mutex_unlock() 或 futex(FUTEX_WAKE) |

唤醒 EntryList 中的线程 |

wait() |

pthread_cond_wait() |

释放锁,进入 WaitSet,阻塞 |

notify() |

pthread_cond_signal() |

从 WaitSet 移动一个线程到 EntryList |

notifyAll() |

pthread_cond_broadcast() |

移动 WaitSet 中所有线程到 EntryList |

图3:Linux 上的 Futex 优化机制

graph TB

subgraph "Futex 的设计理念"

direction TB

subgraph "无竞争路径(Fast Path)"

FAST["用户态 CAS 操作<br/>━━━━━━━━━━━━━━━━━━━━<br/>直接修改 futex word<br/>不进入内核<br/>开销:≈ 几十个 CPU 周期"]

style FAST fill:#c8e6c9

end

subgraph "有竞争路径(Slow Path)"

SLOW["futex() 系统调用<br/>━━━━━━━━━━━━━━━━━━━━<br/>进入内核<br/>线程阻塞在内核等待队列<br/>开销:≈ 几千个 CPU 周期"]

style SLOW fill:#ffcdd2

end

end

subgraph "与 JVM 锁的对应"

LIGHT_LOCK["轻量级锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>类似 Futex Fast Path<br/>用户态 CAS + 自旋"]

HEAVY_LOCK["重量级锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>类似 Futex Slow Path<br/>进入内核阻塞"]

style LIGHT_LOCK fill:#fff9c4

style HEAVY_LOCK fill:#ffcc80

end

FAST -.->|"设计理念相同"| LIGHT_LOCK

SLOW -.->|"设计理念相同"| HEAVY_LOCK

note1["Futex = Fast Userspace Mutex<br/>核心思想:无竞争时在用户态解决<br/>有竞争时才进入内核<br/>这与 JVM 锁优化的思想一致!"]

style note1 fill:#e1f5ff图4:完整的锁获取流程(从 Java 到内核)

sequenceDiagram

participant Java as Java 代码

participant JVM as JVM (HotSpot)

participant Monitor as ObjectMonitor

participant Parker as Parker

participant OS as 操作系统内核

Java->>JVM: synchronized(obj)

JVM->>JVM: 检查 Mark Word

alt 偏向锁/轻量级锁成功

JVM->>Java: 获取锁成功(用户态完成)

else 需要重量级锁

JVM->>Monitor: 获取 ObjectMonitor

Monitor->>Monitor: 尝试 CAS 设置 _owner

alt CAS 成功

Monitor->>Java: 获取锁成功

else CAS 失败(有竞争)

Monitor->>Monitor: 自旋尝试

alt 自旋成功

Monitor->>Java: 获取锁成功

else 自旋失败

Monitor->>Parker: 调用 park()

Parker->>OS: futex(FUTEX_WAIT) / pthread_mutex_lock()

Note over OS: 线程阻塞在内核

OS-->>Parker: 被唤醒

Parker-->>Monitor: park() 返回

Monitor->>Monitor: 重新竞争锁

end

end

end为什么需要 Parker 这个中间层?

重要说明:Parker 不是 Java 类,而是 HotSpot JVM 中的 C++ 类,定义在

hotspot/src/share/runtime/park.hpp文件中。每个 Java 线程在 JVM 内部都有一个对应的Parker对象实例。你在 Java 代码中找不到Parker类,因为它完全存在于 JVM 的 native 层。

1 | |

Parker 的设计目的:

- 跨平台抽象:不同操作系统的阻塞原语不同(Linux 用 futex/pthread,Windows 用 Event),Parker 提供统一接口

- 性能优化:Parker 可以实现"先自旋再阻塞"的策略,减少不必要的系统调用

- 与 LockSupport 对接:Java 层的

LockSupport.park()/unpark()最终调用的就是 Parker

调用链路:

1 | |

关键理解:两层 Mutex 的区别

很多人容易混淆的一点是:ObjectMonitor 内部有一个 Mutex,操作系统也有 Mutex,它们是什么关系?

| 层级 | Mutex 用途 | 说明 |

|---|---|---|

| ObjectMonitor 内部 Mutex | 保护 ObjectMonitor 自身的数据结构 | 确保多线程并发修改 _owner、_EntryList 等字段时的一致性 |

| OS Mutex(通过 Parker) | 实现线程的阻塞和唤醒 | 当线程需要等待时,真正让 CPU 不再调度该线程 |

简单来说:

- ObjectMonitor 的 Mutex 是为了保护"锁的元数据"

- OS 的 Mutex/Futex 是为了实现"线程的阻塞"

这就像一个银行:

- 银行内部的保险柜锁(ObjectMonitor Mutex)保护的是"谁在排队、谁在办业务"的记录

- 银行大门的锁(OS Mutex)决定的是"顾客能不能进来"

锁对象复用陷阱: 由于一个对象在任意时刻只能被一个线程锁定(monitor 只有一个 owner),如果在不同的业务逻辑中复用同一个锁对象,会导致本来毫无关联的代码互相阻塞。例如:

1 | |

即使 methodA 和 methodB 的业务逻辑完全独立,它们也会互相阻塞,因为竞争的是同一个对象的 monitor。正确做法是为不相关的临界区使用不同的锁对象。这个问题同样适用于 ReentrantLock——锁的粒度由锁对象/Lock 实例的数量决定,一个锁对象 = 一把锁 = 同一时刻只能一个线程持有。

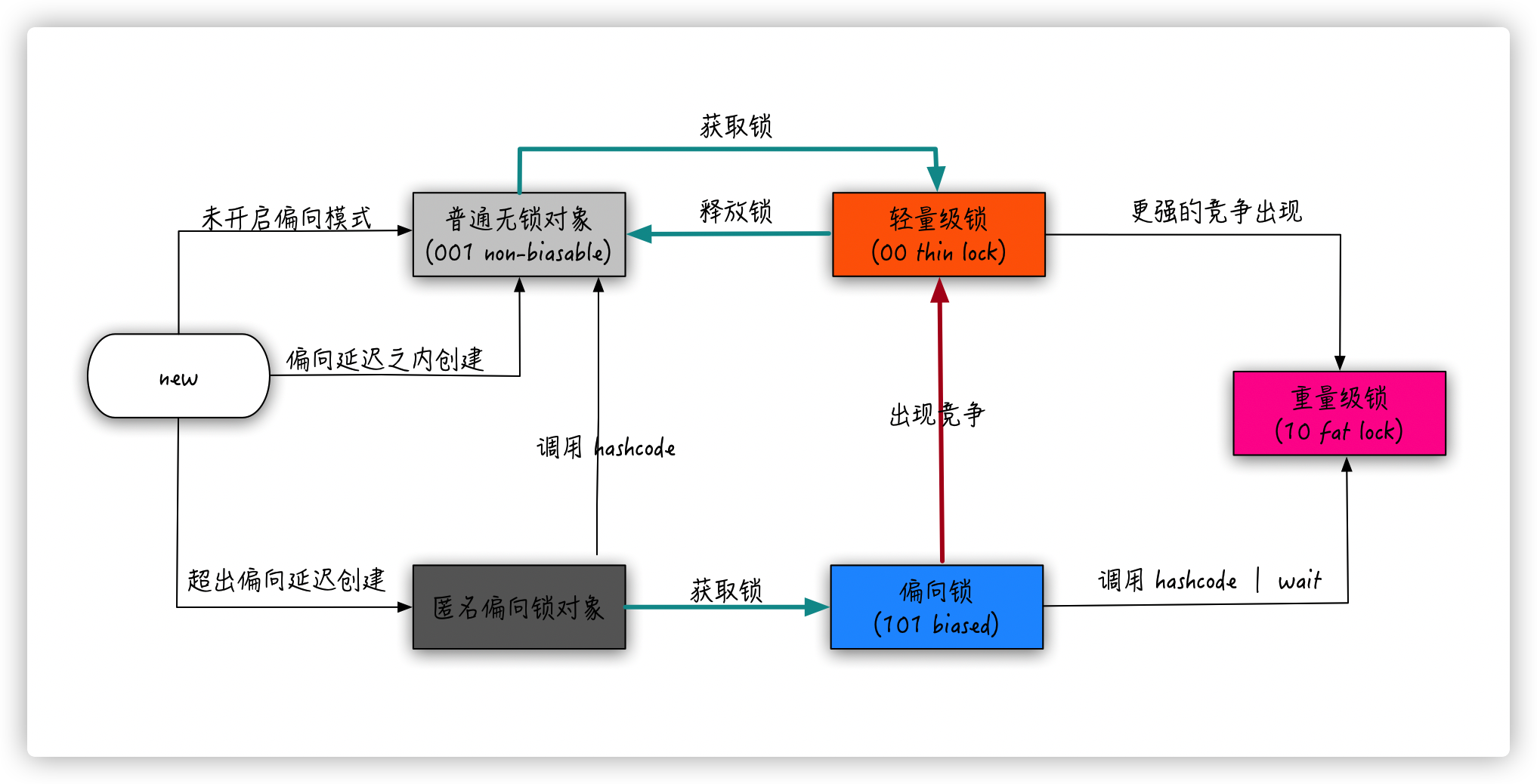

锁优化

所有的锁优化其实是 synchronized 优化。

锁优化的设计哲学:用户态锁 vs 内核态锁

核心思想:锁越轻,离底层 Mutex 机制越远,越能在 Java/JVM 内部的数据结构中解决;涉及的 JVM 外部/底层机制越少,开销就越小。

这个设计思想与 绿色线程(Green Thread)vs内核线程(Kernel Thread) 的设计理念高度相似:

| 对比维度 | 绿色线程 | 内核线程 | 轻量级锁 | 重量级锁 |

|---|---|---|---|---|

| 调度/管理者 | 用户态运行时(如 JVM、Go runtime) | 操作系统内核 | JVM(CAS + 自旋) | 操作系统(Mutex) |

| 切换开销 | 极低(不涉及内核) | 高(用户态/内核态切换) | 极低(用户态 CAS) | 高(系统调用) |

| 数据结构位置 | 用户空间 | 内核空间 | Java 栈帧(Lock Record) | 内核 Mutex + ObjectMonitor |

| 适用场景 | 大量轻量级并发 | 需要真正并行 | 低竞争同步 | 高竞争同步 |

可以说,偏向锁和轻量级锁就是"用户态锁",而重量级锁是"内核态锁"。

图:锁机制的分层架构——从用户态到内核态的渐进式下沉

graph TB

subgraph "用户态(User Space)"

subgraph "纯 Java 对象层"

BIAS["偏向锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word 存储线程 ID<br/>后续加锁:仅比较线程 ID<br/>开销:≈ 0"]

style BIAS fill:#c8e6c9

end

subgraph "Java 栈 + CAS 层"

LIGHT["轻量级锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word → Lock Record<br/>Lock Record 在线程栈帧中<br/>开销:CAS + 自旋"]

style LIGHT fill:#fff9c4

end

subgraph "JVM 运行时层"

MONITOR["ObjectMonitor<br/>━━━━━━━━━━━━━━━━━━━━<br/>JVM C++ 对象<br/>管理 Owner/EntryList/WaitSet"]

style MONITOR fill:#ffcc80

end

end

subgraph "内核态(Kernel Space)"

MUTEX["OS Mutex / Futex<br/>━━━━━━━━━━━━━━━━━━━━<br/>操作系统同步原语<br/>线程阻塞/唤醒<br/>开销:用户态/内核态切换"]

style MUTEX fill:#ffcdd2

end

BIAS -->|"出现竞争<br/>撤销偏向"| LIGHT

LIGHT -->|"竞争激烈<br/>自旋失败"| MONITOR

MONITOR -->|"阻塞线程<br/>系统调用"| MUTEX

note1["越往下,离 Java 越远,离 OS 越近<br/>开销越大,但能处理的竞争越激烈"]

style note1 fill:#e1f5ff锁升级的标志性事件

锁的状态转换不是随机发生的,而是由明确的、可识别的标志性事件触发。理解这些事件是理解锁优化的关键:

graph LR

subgraph "锁状态"

UNLOCKED["无锁状态<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word 存储:<br/>hashCode + age + 0|01"]

BIASED["偏向锁状态<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word 存储:<br/>ThreadID + epoch + 1|01"]

LIGHT["轻量级锁状态<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word 存储:<br/>Lock Record 指针 + 00"]

HEAVY["重量级锁状态<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word 存储:<br/>Monitor 指针 + 10"]

end

UNLOCKED -->|"事件①<br/>首次加锁"| BIASED

BIASED -->|"事件②<br/>第二个线程尝试获取锁"| LIGHT

LIGHT -->|"事件③<br/>CAS 竞争失败"| HEAVY

style UNLOCKED fill:#e8f5e9

style BIASED fill:#c8e6c9

style LIGHT fill:#fff9c4

style HEAVY fill:#ffcdd2锁升级的标志性事件详解:

| 事件 | 触发条件 | 状态转换 | 具体表现 | 为什么触发升级 |

|---|---|---|---|---|

| 事件①:首次加锁 | 对象第一次被 synchronized |

无锁 → 偏向锁 | CAS 将当前线程 ID 写入 Mark Word | 假设锁总是被同一线程获取 |

| 事件②:第二个线程尝试获取锁 | 另一个线程尝试获取已偏向的锁 | 偏向锁 → 轻量级锁 | 撤销偏向,两个线程都创建 Lock Record,CAS 竞争 | 偏向假设被打破,需要真正的同步机制 |

| 事件③:CAS 竞争失败 | 线程 CAS 设置 Lock Record 指针失败 | 轻量级锁 → 重量级锁 | 创建 ObjectMonitor,失败线程进入 EntryList 阻塞 | CAS 失败意味着存在真正的并发竞争 |

关键理解:什么是"竞争"?

在锁优化的语境下,"竞争"有精确的定义:

| 竞争类型 | 定义 | 锁状态 | 处理方式 |

|---|---|---|---|

| 无竞争 | 始终只有一个线程访问锁 | 偏向锁 | 仅记录线程 ID,无需同步 |

| 交替访问(无真正竞争) | 多个线程访问锁,但不同时 | 轻量级锁 | CAS 总能成功,无需阻塞 |

| 真正竞争 | 多个线程同时尝试获取锁 | 重量级锁 | CAS 失败,需要阻塞等待 |

偏向锁 vs 轻量级锁的本质区别:

| 对比维度 | 偏向锁 | 轻量级锁 |

|---|---|---|

| 假设场景 | 锁始终被同一个线程获取 | 锁被多个线程交替获取,但不同时 |

| 加锁操作 | 首次 CAS,后续仅比较线程 ID | 每次都需要 CAS |

| 数据结构 | 仅 Mark Word(存线程 ID) | Mark Word + Lock Record |

| 升级触发 | 第二个线程出现 | CAS 失败(真正竞争) |

| 适用场景 | 单线程反复进入同步块 | 多线程交替进入同步块 |

为什么这种分层设计是高效的?

观察 Mark Word 在不同锁状态下的内容变化,可以发现一个清晰的局部性原则:

| 锁状态 | 数据存储位置 | 依赖层级 | 涉及的外部机制 | 性能开销 |

|---|---|---|---|---|

| 无锁 | Mark Word 直接存储 hashCode、age | 纯 Java 对象 | 无 | 无额外开销 |

| 偏向锁 | Mark Word 存储线程 ID | 纯 Java 对象 | 无(仅首次 CAS) | ≈ 0 |

| 轻量级锁 | Mark Word → Lock Record(线程栈帧) | Java 栈 + CPU CAS 指令 | CPU 原子指令 | 用户态自旋 |

| 重量级锁 | Mark Word → ObjectMonitor → OS Mutex | 操作系统内核 | 系统调用、内核调度器 | 用户态/内核态切换 |

这种设计体现了"能在用户态解决的问题,就不要下沉到内核态"的优化原则:

-

偏向锁(纯用户态,零开销):假设锁总是被同一个线程获取,直接在 Mark Word 中记录线程 ID,后续加锁只需比较线程 ID,连 CAS 都省了。这是最乐观的假设,完全在 Java 对象层面解决,不涉及任何 JVM 外部机制。

-

轻量级锁(用户态,低开销):当出现竞争时,退而求其次,使用 CAS + 自旋的方式在用户态解决。Lock Record 存储在线程栈帧中,仍然是 Java 层面的数据结构。虽然 CAS 需要 CPU 提供原子指令支持,但不涉及操作系统调用,仍在用户态完成。

-

重量级锁(内核态,高开销):当竞争激烈、自旋无法快速获取锁时,才不得不"下沉"到操作系统层面,使用 Mutex/Futex 等同步原语。此时 Mark Word 指向 ObjectMonitor,而 ObjectMonitor 内部会调用操作系统的阻塞/唤醒机制,触发用户态/内核态切换。

与绿色线程的类比深化:

| 设计理念 | 绿色线程 | 轻量级锁 |

|---|---|---|

| 核心思想 | 用户态调度替代内核态调度 | 用户态同步替代内核态同步 |

| 实现方式 | M:N 模型,多个用户态线程映射到少量内核线程 | CAS + 自旋,在用户态完成锁的获取和释放 |

| 优势 | 避免内核态切换开销,支持大量轻量级并发 | 避免系统调用开销,支持低竞争场景的高效同步 |

| 局限性 | 无法利用多核并行(除非有内核线程支撑) | 无法处理高竞争场景(必须膨胀为重量级锁) |

| 典型实现 | Go goroutine、Erlang process、Java 虚拟线程 | JVM 偏向锁、轻量级锁 |

但有一个关键区别:绿色线程可以完全替代内核线程(如 Go 的 goroutine 在大多数场景下足够),而轻量级锁不能完全替代重量级锁——当竞争激烈时,自旋会浪费大量 CPU,必须膨胀为重量级锁让线程阻塞等待。

为什么锁只能升级不能降级?

这也解释了为什么锁只能升级不能降级:一旦发现竞争激烈到需要重量级锁,说明这个锁的使用场景确实存在高并发竞争,降级回轻量级锁反而会因为频繁的 CAS 失败和自旋浪费更多 CPU 资源。这就像一个服务发现单机处理不了流量后扩容到集群,即使流量下降也不会立即缩容——因为流量模式已经证明了需要更高的处理能力。

总结:锁优化的本质是"就近原则"

1 | |

离问题发生地越近的解决方案,开销越小。 这与计算机体系结构中的"局部性原理"一脉相承:CPU 缓存比内存快,内存比磁盘快,本地调用比远程调用快——同样,用户态同步比内核态同步快。

三种锁对 Mark Word 的处理策略

理解三种锁的本质差异,关键在于理解它们如何处理 Mark Word 中的原始信息(hashCode、GC age 等):

| 锁类型 | Mark Word 处理方式 | 原始信息存储位置 |

|---|---|---|

| 偏向锁 | 原地复用 Mark Word,用 threadId 替换 hashCode 字段 | 无需备份(但 hashCode 与偏向锁互斥) |

| 轻量级锁 | Mark Word 被替换为指向 Lock Record 的指针 | Lock Record 的 Displaced Mark Word 字段 |

| 重量级锁 | Mark Word 被替换为指向 ObjectMonitor 的指针 | ObjectMonitor 的 _header 字段 |

这个设计体现了一个核心权衡:

- 偏向锁是"原地操作",不需要额外的数据结构来保存原始 Mark Word,因此最轻量。代价是 hashCode 和 threadId 互斥,调用

hashCode()会导致偏向锁失效。 - 轻量级锁和重量级锁都是"指针替换",需要将原始 Mark Word 转移到别处保存(Lock Record 或 ObjectMonitor),解锁时再恢复。这也解释了为什么轻量级锁解锁时必须用 CAS 把 Displaced Mark Word 写回——就是为了恢复原始信息。

三种锁的数据结构对比

理解三种锁的本质差异,关键在于理解它们各自的数据结构:

graph TB

subgraph "偏向锁:最轻量,无额外数据结构"

direction TB

OBJ_BIAS["锁对象 obj<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word:<br/>threadId | epoch | age | 1 | 01<br/>━━━━━━━━━━━━━━━━━━━━<br/>直接在 Mark Word 中<br/>记录偏向线程 ID"]

THREAD_BIAS["偏向线程<br/>━━━━━━━━━━━━━━━━━━━━<br/>无需任何额外数据结构<br/>只需检查 Mark Word 中的<br/>threadId 是否是自己"]

OBJ_BIAS -.->|"threadId 记录在<br/>Mark Word 中"| THREAD_BIAS

style OBJ_BIAS fill:#e8f5e9

style THREAD_BIAS fill:#e8f5e9

endgraph TB

subgraph "轻量级锁:一个 Lock Record,无等待队列"

direction TB

OBJ_LIGHT["锁对象 obj<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word:<br/>ptr_to_lock_record | 00<br/>━━━━━━━━━━━━━━━━━━━━<br/>指向持锁线程栈上的<br/>Lock Record"]

LR_LIGHT["Lock Record(栈上)<br/>━━━━━━━━━━━━━━━━━━━━<br/>Displaced Mark Word<br/>(原始 Mark Word 备份)<br/>owner → obj<br/>━━━━━━━━━━━━━━━━━━━━<br/>无 WaitSet<br/>无 EntryList<br/>无 Mutex"]

THREAD_LIGHT["持锁线程<br/>━━━━━━━━━━━━━━━━━━━━<br/>Lock Record 在其栈帧中"]

OTHER_LIGHT["竞争线程<br/>━━━━━━━━━━━━━━━━━━━━<br/>CAS 自旋重试<br/>不阻塞、不排队"]

OBJ_LIGHT -->|"Mark Word 指向"| LR_LIGHT

LR_LIGHT -->|"在栈帧中"| THREAD_LIGHT

OTHER_LIGHT -.->|"CAS 失败后自旋"| OBJ_LIGHT

style OBJ_LIGHT fill:#e1f5ff

style LR_LIGHT fill:#e1f5ff

style THREAD_LIGHT fill:#c8e6c9

style OTHER_LIGHT fill:#fff9c4

endgraph TB

subgraph "重量级锁:完整的 Monitor 结构"

direction TB

OBJ_HEAVY["锁对象 obj<br/>━━━━━━━━━━━━━━━━━━━━<br/>Mark Word:<br/>ptr_to_monitor | 10<br/>━━━━━━━━━━━━━━━━━━━━<br/>指向 ObjectMonitor"]

MONITOR["ObjectMonitor(C++ 堆)<br/>━━━━━━━━━━━━━━━━━━━━<br/>_header: 原始 Mark Word<br/>_owner: → 持锁线程<br/>_recursions: 重入计数<br/>━━━━━━━━━━━━━━━━━━━━<br/>_cxq: 竞争队列<br/>_EntryList: 阻塞等待队列<br/>_WaitSet: wait() 等待队列<br/>━━━━━━━━━━━━━━━━━━━━<br/>底层同步原语"]

MUTEX["pthread_mutex_t<br/>(OS 互斥量)"]

COND["pthread_cond_t<br/>(条件变量)"]

OWNER["持锁线程<br/>━━━━━━━━━━━━━━━━━━━━<br/>_owner 指向它"]

WAITING["等待线程们<br/>━━━━━━━━━━━━━━━━━━━━<br/>在 _EntryList 中阻塞<br/>或在 _WaitSet 中等待"]

OBJ_HEAVY -->|"Mark Word 指向"| MONITOR

MONITOR -->|"_owner"| OWNER

MONITOR -->|"_EntryList / _WaitSet"| WAITING

MONITOR -->|"封装"| MUTEX

MONITOR -->|"封装"| COND

MUTEX -->|"系统调用"| KERNEL["内核态"]

style OBJ_HEAVY fill:#ffcdd2

style MONITOR fill:#ffcdd2

style MUTEX fill:#ffcdd2

style COND fill:#ffcdd2

style OWNER fill:#c8e6c9

style WAITING fill:#fff9c4

style KERNEL fill:#ffcdd2

end三种锁的本质区别总结:

| 维度 | 偏向锁 | 轻量级锁 | 重量级锁 |

|---|---|---|---|

| Mark Word 内容 | 偏向线程 ID | 指向 Lock Record 的指针 | 指向 ObjectMonitor 的指针 |

| 额外数据结构 | 无 | Lock Record(栈上,1个) | ObjectMonitor(C++ 堆,含多个队列) |

| 持锁线程记录 | Mark Word 中的 threadId | Mark Word 指向的 Lock Record 所在栈帧 | Monitor 的 _owner 字段 |

| 等待队列 | 无 | 无(自旋重试) | 有(_EntryList、_WaitSet、_cxq) |

| 底层同步原语 | 无 | CAS 指令 | OS Mutex + Condition Variable |

| 竞争失败处理 | 撤销偏向,升级 | CAS 自旋,超时则膨胀 | 阻塞,进入等待队列 |

| 适用场景 | 单线程反复获取同一把锁 | 多线程交替获取锁,竞争不激烈 | 多线程激烈竞争 |

关键理解:

-

偏向锁:最轻量,直接在 Mark Word 中记录偏向线程 ID,无任何额外数据结构。相当于"这把锁归你了,以后你来就直接进"。

-

轻量级锁:Mark Word 指向持锁线程栈上的 Lock Record。Lock Record 只保存原始 Mark Word 的备份,不包含任何等待队列。竞争失败的线程只能 CAS 自旋重试,不会被阻塞。

-

重量级锁:Mark Word 指向 ObjectMonitor,Monitor 是一个完整的同步结构,包含:

_owner:指向持锁线程_EntryList:阻塞等待获取锁的线程队列_WaitSet:调用wait()后等待被notify()的线程队列_cxq:竞争队列(新来的竞争者先进这里)- 底层封装了 OS 的 Mutex 和 Condition Variable

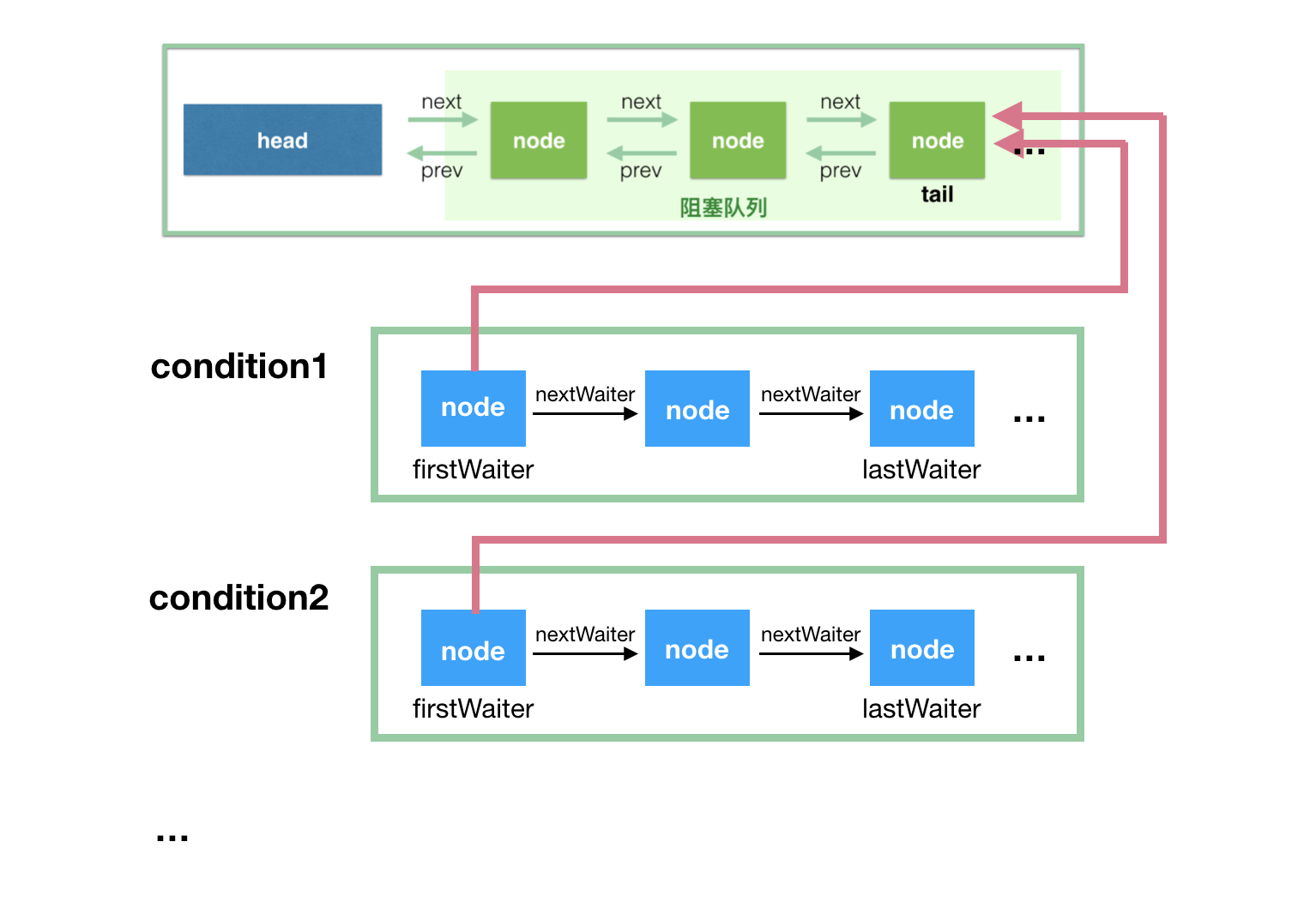

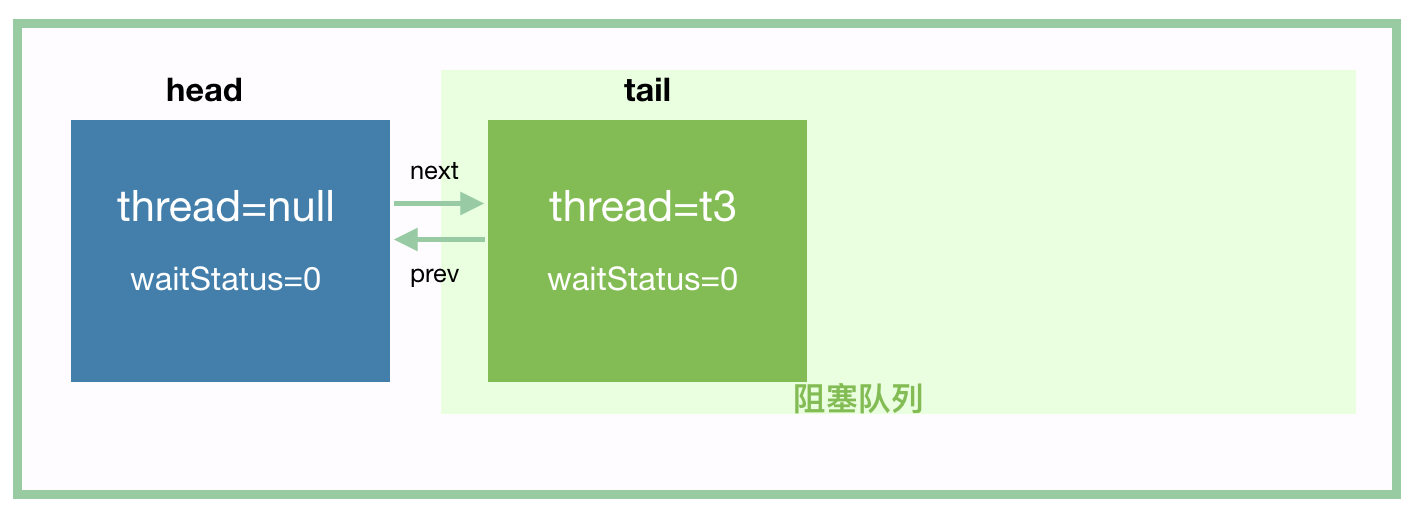

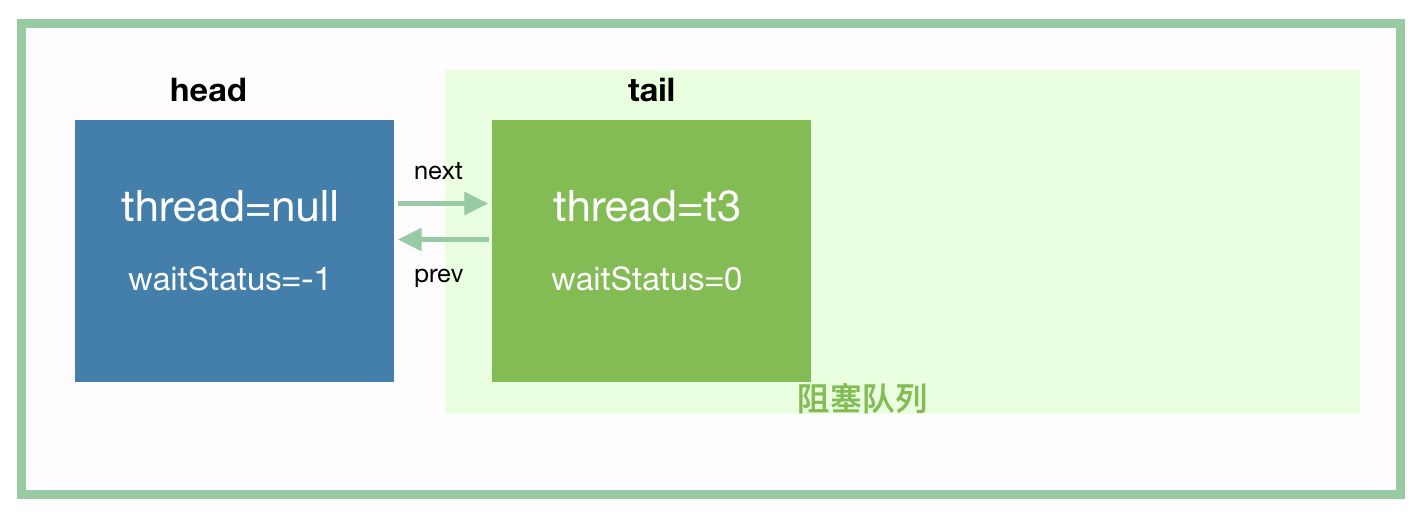

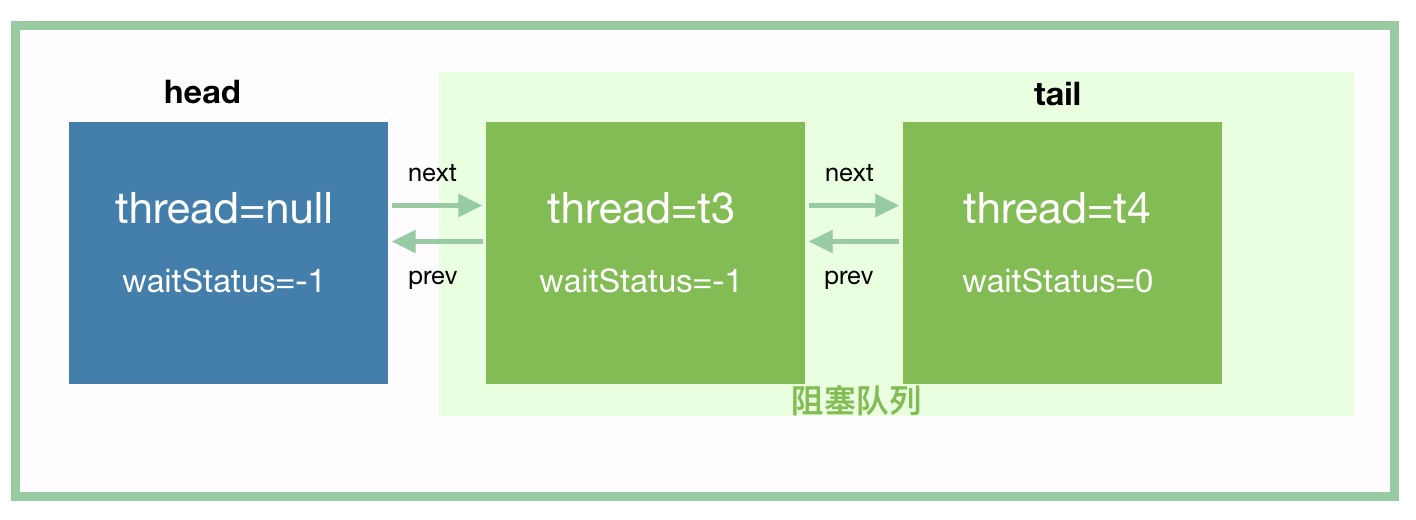

ObjectMonitor 的三个队列:cxq、EntryList、WaitSet 详解

ObjectMonitor 中的三个队列各有不同的职责,理解它们的区别是理解 synchronized 底层机制的关键:

| 队列 | 全称 | 用途 | 线程来源 | 数据结构 |

|---|---|---|---|---|

| _cxq | Contention Queue | 新竞争线程的入口队列 | 新到达的、尝试获取锁失败的线程 | 单向链表(LIFO) |

| _EntryList | Entry List | 等待获取锁的正式队列 | 从 cxq 转移过来的线程 | 双向链表 |

| _WaitSet | Wait Set | 调用 wait() 后等待的线程 | 调用 Object.wait() 的线程 | 双向循环链表 |

flowchart TB

subgraph "ObjectMonitor 的三个队列"

direction TB

NEW_THREAD["新到达的竞争线程"]

subgraph CXQ["_cxq(Contention Queue)"]

CXQ_DESC["新竞争者入口<br/>━━━━━━━━━━━━━━━━━━━━<br/>• 单向链表,LIFO 顺序<br/>• 新线程从头部插入<br/>• 锁释放时可能整体转移到 EntryList"]

C1["线程 C"] --> C2["线程 B"] --> C3["线程 A"]

end

subgraph ENTRYLIST["_EntryList"]

EL_DESC["正式等待队列<br/>━━━━━━━━━━━━━━━━━━━━<br/>• 双向链表<br/>• 锁释放时从这里唤醒线程<br/>• 被唤醒的线程竞争 _owner"]

E1["线程 X"] <--> E2["线程 Y"] <--> E3["线程 Z"]

end

subgraph WAITSET["_WaitSet"]

WS_DESC["wait() 等待队列<br/>━━━━━━━━━━━━━━━━━━━━<br/>• 双向循环链表<br/>• 调用 wait() 的线程进入<br/>• notify() 后转移到 EntryList 或 cxq"]

W1["线程 P"] <--> W2["线程 Q"] <--> W3["线程 R"]

W3 <-.-> W1

end

OWNER["_owner<br/>当前持锁线程"]

NEW_THREAD -->|"1. 获取锁失败"| CXQ

CXQ -->|"2. 锁释放时转移"| ENTRYLIST

ENTRYLIST -->|"3. 被唤醒后竞争"| OWNER

OWNER -->|"4. 调用 wait()"| WAITSET

WAITSET -->|"5. 被 notify()"| ENTRYLIST

style OWNER fill:#c8e6c9

style CXQ fill:#fff9c4

style ENTRYLIST fill:#e1f5ff

style WAITSET fill:#ffcdd2

end为什么需要两个入口队列(cxq 和 EntryList)?

这是一个性能优化设计:

- cxq 是"快速入口":新线程竞争锁失败时,直接 CAS 插入 cxq 头部(LIFO),这个操作非常快,不需要获取任何锁

- EntryList 是"正式队列":锁释放时,持锁线程会将 cxq 中的线程批量转移到 EntryList,然后从 EntryList 中唤醒线程

- 分离的好处:入队操作(插入 cxq)和出队操作(从 EntryList 唤醒)在不同的队列上进行,减少了竞争

为什么 ObjectMonitor 有 cxq,而 AQS 没有?

这是一个很好的问题。AQS 确实没有 cxq 这样的结构,但两者都实现了"无锁入队"的目标,只是方式不同:

| 对比项 | ObjectMonitor | AQS |

|---|---|---|

| 入队结构 | cxq(单向链表,LIFO) | sync queue(双向链表,FIFO) |

| 入队方式 | CAS 插入 cxq 头部 | CAS 设置 tail 指针 |

| 是否需要额外队列 | 需要 cxq + EntryList | 不需要,直接操作 sync queue |

| 入队复杂度 | O(1) CAS 到头部 | O(1) CAS 到尾部 |

为什么设计不同?

- ObjectMonitor 的历史原因:ObjectMonitor 是 JVM 早期设计的,cxq 的 LIFO 设计可能是为了简化实现(头插法比尾插法简单)

- AQS 的改进设计:AQS 设计时借鉴了 CLH 队列的思想,直接 CAS 到 tail,同样是 O(1) 操作,但保持了 FIFO 顺序

- 本质相同:两者都实现了"无锁入队"——新线程入队时不需要获取任何锁,只需要一次 CAS 操作

1 | |

结论:cxq 不是锁的"必要"组成部分,它只是 ObjectMonitor 实现无锁入队的一种方式。AQS 用另一种方式(CAS 到 tail)达到了同样的目的。

sequenceDiagram

participant T1 as 线程1(持锁)

participant T2 as 线程2(新竞争)

participant T3 as 线程3(新竞争)

participant CXQ as _cxq

participant EL as _EntryList

participant Owner as _owner

Note over T1,Owner: T1 持有锁

T2->>CXQ: CAS 插入头部

T3->>CXQ: CAS 插入头部

Note over CXQ: cxq: T3 → T2

T1->>Owner: 释放锁(_owner = null)

T1->>CXQ: 将 cxq 转移到 EntryList

Note over EL: EntryList: T3 ↔ T2

T1->>EL: 唤醒 EntryList 头部线程

T3->>Owner: 竞争获取锁

Note over T3,Owner: T3 成为新的 _ownerWaitSet 的特殊性:

WaitSet 与 cxq/EntryList 有本质区别:

- cxq/EntryList:线程在等待获取锁

- WaitSet:线程在等待某个条件(已经释放了锁)

当线程调用 wait() 时:

- 释放持有的锁(

_owner = null) - 进入 WaitSet 等待

- 被

notify()唤醒后,转移到 EntryList 或 cxq - 重新竞争锁,获取成功后从

wait()返回

为什么轻量级锁不需要等待队列?

因为轻量级锁的设计假设是"竞争很少发生"。在这种假设下,竞争失败的线程通过短暂的 CAS 自旋就能获取到锁,不需要排队等待。一旦自旋超过阈值(说明竞争激烈),就膨胀为重量级锁,此时才需要等待队列来管理大量等待的线程。

synchronized 的非公平性:完整机制分析

规范层面的说明:

Java Language Specification (JLS 17.1) 明确指出:synchronized 只保证互斥性和 happens-before 关系,不保证任何特定的获取顺序。这意味着依赖 synchronized 公平性的代码是不正确的。

非公平性的来源(HotSpot 实现):

synchronized 的非公平性来源于多个因素的组合,而不仅仅是 cxq 的 LIFO 特性:

| 因素 | 描述 | 对非公平性的贡献 |

|---|---|---|

| 新线程直接抢占 | 新线程首先尝试 CAS 获取 _owner,不先排队 |

主要因素:新线程可以"插队" |

| cxq 的 LIFO 特性 | 新竞争线程从 cxq 头部插入 | 次要因素:影响等待线程间的顺序 |

| 唤醒后重新竞争 | 被唤醒的线程需要与新线程竞争 | 次要因素:唤醒不等于获得锁 |

flowchart TB

subgraph "synchronized 非公平性的三个来源"

direction TB

subgraph SOURCE1["来源1:新线程直接抢占(主要因素)"]

S1_1["新线程到达"]

S1_2["直接尝试 CAS _owner"]

S1_3["成功则获取锁<br/>失败才入队"]

S1_1 --> S1_2 --> S1_3

style S1_2 fill:#ffcdd2

end

subgraph SOURCE2["来源2:cxq 的 LIFO 特性(次要因素)"]

S2_1["线程 A 先到达"]

S2_2["线程 B 后到达"]

S2_3["cxq: B → A"]

S2_4["B 可能比 A 先被处理"]

S2_1 --> S2_3

S2_2 --> S2_3

S2_3 --> S2_4

style S2_3 fill:#fff9c4

end

subgraph SOURCE3["来源3:唤醒后重新竞争(次要因素)"]

S3_1["EntryList 线程被唤醒"]

S3_2["唤醒过程需要时间"]

S3_3["新线程可能抢先获取锁"]

S3_4["被唤醒线程 CAS 失败"]

S3_1 --> S3_2 --> S3_3 --> S3_4

style S3_3 fill:#e1f5ff

end

end关键澄清:cxq 的 LIFO 不是非公平性的主要原因

一个常见的误解是认为 synchronized 的非公平性主要来自 cxq 的 LIFO 特性。实际上:

-

cxq 的 LIFO 只影响等待线程之间的顺序:它决定了 A、B、C 三个等待线程谁先被转移到 EntryList,但这只是"不公平"的一个方面。

-

真正的非公平性来自"插队"机制:即使 cxq 是 FIFO 的,只要允许新线程直接 CAS 获取锁(不先检查队列),synchronized 仍然是非公平的。

-

对比 AQS 的公平锁实现:AQS 公平锁通过

hasQueuedPredecessors()检查队列是否有等待者,如果有则不允许新线程直接获取锁。synchronized 没有这个检查。

sequenceDiagram

participant New as 新线程

participant Owner as 持锁线程

participant Monitor as ObjectMonitor

participant EL as EntryList 线程

Note over Owner,Monitor: 持锁线程正在执行临界区

Owner->>Monitor: 1. 释放锁(_owner = null)

Owner->>EL: 2. 唤醒 EntryList 头部线程

Note over EL: 3. 唤醒中...(需要时间)

New->>Monitor: 4. 新线程到达,直接 CAS _owner

Note over New,Monitor: CAS 成功!新线程获取锁

Note over EL: 5. 唤醒完成

EL->>Monitor: 6. 尝试 CAS _owner

Note over EL,Monitor: CAS 失败,重新进入等待

Note over New,EL: 结果:新线程"插队"成功为什么设计成非公平的?

非公平锁的吞吐量更高,原因是:

-

减少锁空闲时间:公平锁在释放锁后必须等待队列头部线程被唤醒,这期间锁处于空闲状态。非公平锁允许新线程立即获取锁,减少了空闲时间。

-

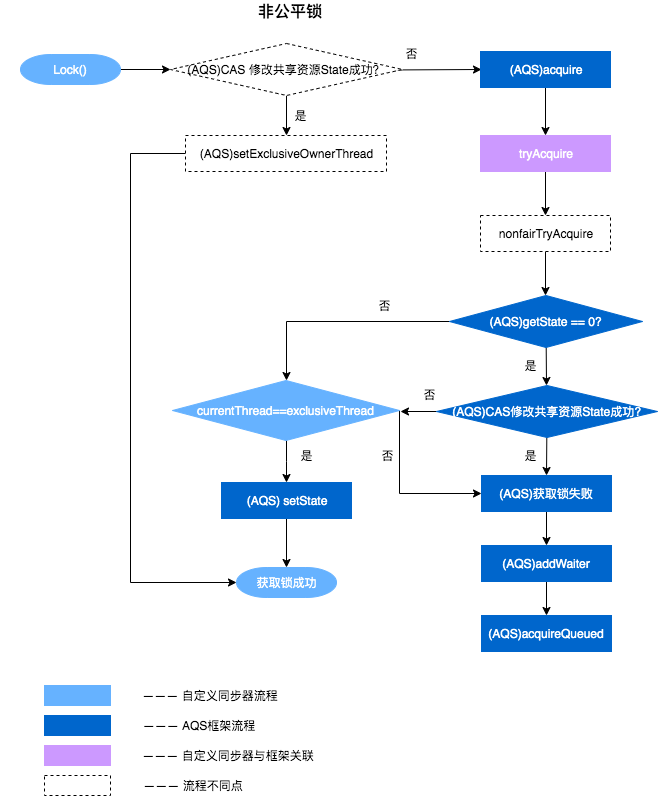

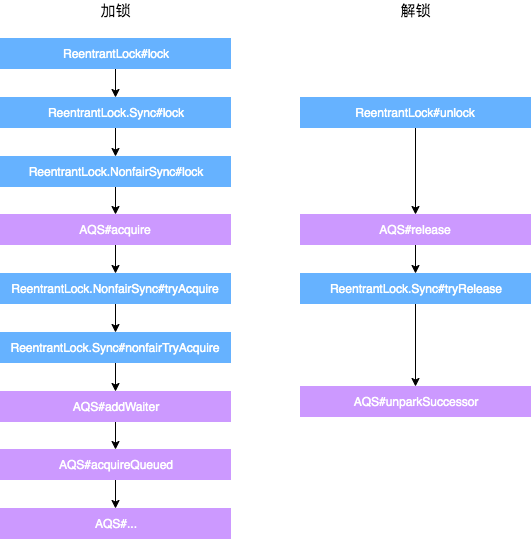

减少上下文切换:如果新线程能直接获取锁,就不需要经历"入队 → 阻塞 → 唤醒"的过程,减少了上下文切换开销。

-

利用 CPU 缓存局部性:刚释放锁的线程如果立即重新获取锁,其 CPU 缓存中的数据仍然有效,性能更好。

总结:

| 问题 | 答案 |

|---|---|

| synchronized 是公平的吗? | 否,JLS 不保证公平性 |

| 非公平性的主要来源? | 新线程可以直接 CAS 获取锁,不先排队 |

| cxq 的 LIFO 是主要原因吗? | 否,它只是次要因素,影响等待线程间的顺序 |

| 为什么设计成非公平的? | 吞吐量更高,减少锁空闲时间和上下文切换 |

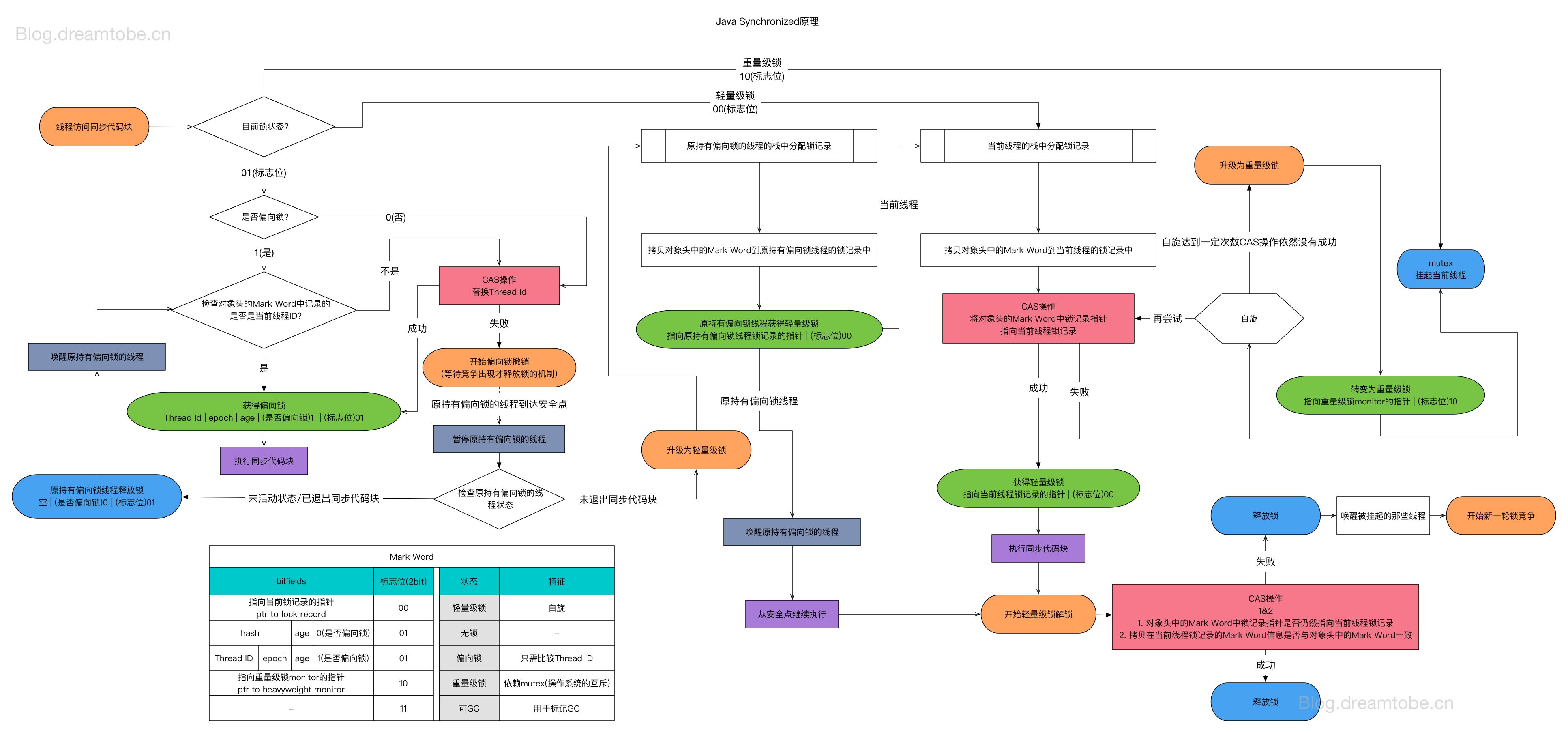

锁升级全景图:从无锁到重量级锁的完整状态转换

下图展示了 synchronized 锁的完整生命周期,包括所有可能的状态转换路径:

flowchart TB

subgraph 锁状态转换图

direction TB

START(("对象创建")) --> Unlocked

subgraph Unlocked["无锁状态"]

U1["Mark Word: hashCode | age | 0 | 01"]

U2["无线程持有锁"]

end

subgraph Biased["偏向锁状态"]

B1["Mark Word: threadId | epoch | age | 1 | 01"]

B2["偏向第一个获取锁的线程"]

end

subgraph Lightweight["轻量级锁状态"]

L1["Mark Word: Lock Record 指针 | 00"]

L2["指向持锁线程栈上的 Lock Record"]

end

subgraph Heavyweight["重量级锁状态"]

H1["Mark Word: ObjectMonitor 指针 | 10"]

H2["指向 C++ 堆上的 Monitor 对象"]

end

Unlocked -->|"首次加锁<br/>(偏向锁启用时)"| Biased

Unlocked -->|"首次加锁<br/>(偏向锁禁用时)"| Lightweight

Biased -->|"同一线程重入<br/>(无需任何操作)"| Biased

Biased -->|"其他线程竞争<br/>(偏向锁撤销)"| Lightweight

Biased -->|"调用 hashCode()<br/>(偏向锁撤销)"| Heavyweight

Lightweight -->|"同一线程重入<br/>(Lock Record 计数)"| Lightweight

Lightweight -->|"CAS 自旋失败<br/>(锁膨胀)"| Heavyweight

Lightweight -->|"解锁成功<br/>(CAS 恢复 Mark Word)"| Unlocked

Heavyweight -->|"线程竞争<br/>(进入 EntryList)"| Heavyweight

Heavyweight -->|"解锁<br/>(可能降级 JDK 15+)"| Unlocked

end

style Unlocked fill:#e8f5e9

style Biased fill:#fff3e0

style Lightweight fill:#e3f2fd

style Heavyweight fill:#ffebee锁升级的触发条件与详细流程:

flowchart TB

subgraph "锁升级决策流程"

START["线程尝试获取锁"]

CHECK_BIAS{"偏向锁<br/>是否启用?"}

subgraph "偏向锁路径"

BIAS_CHECK{"Mark Word<br/>threadId == 当前线程?"}

BIAS_CAS["CAS 写入 threadId"]

BIAS_SUCCESS["偏向锁获取成功<br/>━━━━━━━━━━━━━━<br/>后续重入零开销"]

BIAS_REVOKE["偏向锁撤销<br/>━━━━━━━━━━━━━━<br/>需要 STW 安全点"]

end

subgraph "轻量级锁路径"

LW_RECORD["创建 Lock Record<br/>复制 Mark Word"]

LW_CAS["CAS: Mark Word<br/>→ Lock Record 指针"]

LW_SUCCESS["轻量级锁获取成功"]

LW_SPIN["CAS 自旋重试"]

LW_SPIN_CHECK{"自旋次数<br/>超过阈值?"}

end

subgraph "重量级锁路径"

HW_INFLATE["锁膨胀<br/>━━━━━━━━━━━━━━<br/>创建 ObjectMonitor"]

HW_ENTER["进入 Monitor<br/>━━━━━━━━━━━━━━<br/>可能阻塞"]

HW_SUCCESS["重量级锁获取成功"]

end

START --> CHECK_BIAS

CHECK_BIAS -->|"是"| BIAS_CHECK

CHECK_BIAS -->|"否"| LW_RECORD

BIAS_CHECK -->|"是"| BIAS_SUCCESS

BIAS_CHECK -->|"否(其他线程)"| BIAS_REVOKE

BIAS_CHECK -->|"否(无偏向)"| BIAS_CAS

BIAS_CAS -->|"成功"| BIAS_SUCCESS

BIAS_CAS -->|"失败"| BIAS_REVOKE

BIAS_REVOKE --> LW_RECORD

LW_RECORD --> LW_CAS

LW_CAS -->|"成功"| LW_SUCCESS

LW_CAS -->|"失败"| LW_SPIN

LW_SPIN --> LW_SPIN_CHECK

LW_SPIN_CHECK -->|"否"| LW_CAS

LW_SPIN_CHECK -->|"是"| HW_INFLATE

HW_INFLATE --> HW_ENTER

HW_ENTER --> HW_SUCCESS

end

style BIAS_SUCCESS fill:#c8e6c9

style LW_SUCCESS fill:#c8e6c9

style HW_SUCCESS fill:#c8e6c9

style BIAS_REVOKE fill:#ffcdd2

style HW_INFLATE fill:#ffcdd2锁状态与 Mark Word 的对应关系:

| 锁状态 | Mark Word 布局(64位) | 标志位 | 特点 |

|---|---|---|---|

| 无锁 | [unused:25][hashCode:31][unused:1][age:4][biased:1][lock:2] |

0 01 |

存储对象 hashCode |

| 偏向锁 | [threadId:54][epoch:2][unused:1][age:4][biased:1][lock:2] |

1 01 |

存储偏向线程 ID,无 hashCode 存储空间 |

| 轻量级锁 | [Lock Record 指针:62][lock:2] |

00 |

指向栈上 Lock Record |

| 重量级锁 | [ObjectMonitor 指针:62][lock:2] |

10 |

指向堆上 Monitor |

| GC 标记 | [转发指针或其他 GC 信息:62][lock:2] |

11 |

GC 期间使用 |

锁升级的不可逆性与例外:

graph LR

subgraph "传统模型(JDK 14 及之前)"

A1[无锁] --> B1[偏向锁]

B1 --> C1[轻量级锁]

C1 --> D1[重量级锁]

D1 -.->|"不可降级"| D1

end

subgraph "现代模型(JDK 15+)"

A2[无锁] --> C2[轻量级锁]

C2 --> D2[重量级锁]

D2 -.->|"可降级"| C2

note1["偏向锁默认禁用<br/>-XX:+UseBiasedLocking 可启用"]

note2["重量级锁可降级<br/>当竞争消失时"]

end

style D1 fill:#ffcdd2

style D2 fill:#fff9c4各锁状态的性能特征对比:

| 维度 | 偏向锁 | 轻量级锁 | 重量级锁 |

|---|---|---|---|

| 获取开销 | 几乎为零(仅比较 threadId) | 一次 CAS 操作 | 可能涉及系统调用 |

| 释放开销 | 无(不修改 Mark Word) | 一次 CAS 操作 | Monitor 操作 |

| 竞争处理 | 撤销偏向(需 STW) | CAS 自旋 | 阻塞等待 |

| 适用场景 | 单线程反复获取同一锁 | 多线程交替获取,竞争不激烈 | 多线程激烈竞争 |

| JDK 15+ 默认 | 禁用 | 启用 | 启用 |

为什么 JDK 15 默认禁用偏向锁?

- 撤销成本高:偏向锁撤销需要在安全点(STW)进行,影响应用延迟

- 现代应用特征变化:容器化、微服务架构下,单线程反复获取同一锁的场景减少

- 轻量级锁足够高效:现代 CPU 的 CAS 操作已经非常快

- 简化 JVM 实现:移除偏向锁可以简化锁的实现和调试

偏向锁与 hashCode() 的特殊关系

当对象处于偏向锁状态时,调用 hashCode() 会导致偏向锁直接膨胀为重量级锁,而非回到无锁状态。这是因为:

- Mark Word 空间冲突:偏向锁的 Mark Word 存储的是 threadId(54位),没有空间存储 hashCode(31位)

- hashCode 需要持久存储:一旦计算了 hashCode,必须保存在对象头中(用于 HashMap 等场景的一致性)

- 重量级锁的解决方案:ObjectMonitor 结构中有专门的字段存储 hashCode

flowchart LR

subgraph "偏向锁调用 hashCode() 的处理"

BIASED["偏向锁状态<br/>Mark Word: threadId"]

CALL["调用 hashCode()"]

PROBLEM["问题:无空间存储 hashCode"]

INFLATE["膨胀为重量级锁"]

MONITOR["ObjectMonitor<br/>可存储 hashCode"]

BIASED --> CALL --> PROBLEM --> INFLATE --> MONITOR

style PROBLEM fill:#ffcdd2

style INFLATE fill:#fff9c4

end依据:HotSpot 源码 biasedLocking.cpp 中的 BiasedLocking::revoke_and_rebias() 方法。

最佳实践:如果对象会被用作锁,避免在加锁前调用 hashCode(),或者考虑使用 System.identityHashCode() 的替代方案。

锁消除(Lock Elimination)

什么是锁消除?

锁消除是 JIT 编译器的一项优化技术:如果 JVM 通过**逃逸分析(Escape Analysis)**发现某个锁对象不可能被其他线程访问,那么这个锁就是"多余的",可以被安全地消除。

逃逸分析的核心问题:对象会不会"逃逸"出当前作用域?

| 逃逸类型 | 说明 | 示例 |

|---|---|---|

| 不逃逸 | 对象只在方法内部使用,不会被外部引用 | 方法内的局部变量 |

| 方法逃逸 | 对象被作为参数传递或作为返回值 | return new Object() |

| 线程逃逸 | 对象可能被其他线程访问 | 赋值给静态变量、实例变量 |

只有"不逃逸"的对象上的锁才能被消除。

锁消除的工作原理

图1:锁消除的决策流程

graph TB

subgraph "JIT 编译时的逃逸分析"

CODE["synchronized (lockObj) {<br/> // 临界区代码<br/>}"]

ANALYZE["逃逸分析<br/>━━━━━━━━━━━━━━━━━━━━<br/>分析 lockObj 的引用链<br/>判断是否可能被其他线程访问"]

ESCAPE{"lockObj 是否逃逸?"}

ELIMINATE["锁消除<br/>━━━━━━━━━━━━━━━━━━━━<br/>移除 monitorenter/monitorexit<br/>直接执行临界区代码"]

KEEP["保留锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>正常执行同步逻辑"]

CODE --> ANALYZE

ANALYZE --> ESCAPE

ESCAPE -->|"不逃逸"| ELIMINATE

ESCAPE -->|"可能逃逸"| KEEP

style ELIMINATE fill:#c8e6c9

style KEEP fill:#fff9c4

end锁消除的典型场景

场景1:StringBuffer/StringBuilder 的同步

1 | |

在这个例子中,StringBuffer sb 是一个局部变量,不会逃逸出 concatString 方法,更不可能被其他线程访问。因此,JIT 编译器可以安全地消除 append() 方法内部的同步操作。

优化后的等效代码:

1 | |

场景2:方法内部的同步块

1 | |

由于 lock 对象是方法内部创建的局部变量,每次方法调用都会创建新的对象,不可能被其他线程访问,因此这个同步块可以被完全消除。

ReentrantLock 能被消除吗?

根据 CMU 的研究论文,ReentrantLock 也可以被锁消除优化。JIT 编译器的逃逸分析不仅适用于 synchronized,也适用于 java.util.concurrent 包中的锁。

1 | |

如果 lock 对象不逃逸,JIT 编译器可以消除 lock() 和 unlock() 的调用。

但需要注意:

| 锁类型 | 消除难度 | 原因 |

|---|---|---|

| synchronized | 较容易 | JVM 内置支持,字节码层面可识别 |

| ReentrantLock | 较难 | 需要识别 lock()/unlock() 的调用模式 |

| 分布式锁 | 不可能 | 涉及外部系统,无法通过逃逸分析判断 |

如何验证锁消除是否生效?

1 | |

锁粗化(Lock Coarsening)

什么是锁粗化?

锁粗化是 JIT 编译器的另一项优化技术:如果 JVM 检测到一系列连续的加锁/解锁操作都是针对同一个锁对象,那么可以将这些操作合并为一次更大范围的加锁/解锁,从而减少锁操作的开销。

图1:锁粗化的优化过程

graph TB

subgraph "优化前:频繁加锁/解锁"

BEFORE["synchronized (lock) { op1(); }<br/>synchronized (lock) { op2(); }<br/>synchronized (lock) { op3(); }"]

COST1["开销分析<br/>━━━━━━━━━━━━━━━━━━━━<br/>• 3 次 monitorenter<br/>• 3 次 monitorexit<br/>• 3 次 CAS 操作<br/>• 可能的锁膨胀"]

BEFORE --> COST1

style COST1 fill:#ffcdd2

end

subgraph "优化后:一次大锁"

AFTER["synchronized (lock) {<br/> op1();<br/> op2();<br/> op3();<br/>}"]

COST2["开销分析<br/>━━━━━━━━━━━━━━━━━━━━<br/>• 1 次 monitorenter<br/>• 1 次 monitorexit<br/>• 1 次 CAS 操作<br/>• 锁持有时间略长"]

AFTER --> COST2

style COST2 fill:#c8e6c9

end

BEFORE -->|"JIT 锁粗化"| AFTER锁粗化的典型场景

场景1:循环内的同步

1 | |

场景2:连续的同步方法调用

1 | |

锁粗化的权衡

图2:锁粗化的利弊分析

graph TB

subgraph "锁粗化的收益"

BENEFIT1["减少锁操作次数<br/>━━━━━━━━━━━━━━━━━━━━<br/>N 次加锁/解锁 → 1 次<br/>减少 CAS 开销"]

BENEFIT2["减少锁状态转换<br/>━━━━━━━━━━━━━━━━━━━━<br/>避免频繁的偏向锁撤销<br/>避免轻量级锁膨胀"]

BENEFIT3["提高缓存命中率<br/>━━━━━━━━━━━━━━━━━━━━<br/>减少 Mark Word 的修改<br/>减少缓存行失效"]

style BENEFIT1 fill:#c8e6c9

style BENEFIT2 fill:#c8e6c9

style BENEFIT3 fill:#c8e6c9

end

subgraph "锁粗化的代价"

COST1["锁持有时间变长<br/>━━━━━━━━━━━━━━━━━━━━<br/>其他线程等待时间增加<br/>可能降低并发度"]

COST2["临界区变大<br/>━━━━━━━━━━━━━━━━━━━━<br/>包含了原本不需要同步的代码<br/>可能引入不必要的串行化"]

style COST1 fill:#ffcdd2

style COST2 fill:#ffcdd2

end| 场景 | 是否适合锁粗化 | 原因 |

|---|---|---|

| 连续的短临界区 | 适合 | 锁操作开销 > 临界区执行时间 |

| 循环内的同步 | 适合 | 避免大量重复的加锁/解锁 |

| 包含 I/O 操作的临界区 | 不适合 | 锁持有时间过长,严重影响并发 |

| 高并发竞争场景 | 不适合 | 锁粗化会加剧竞争 |

锁粗化 vs 锁细化

锁粗化和锁细化(Lock Splitting/Striping)是两个相反的优化方向:

graph LR

subgraph "锁粗化"

COARSE["多个小锁 → 一个大锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>减少锁操作开销<br/>适合低竞争场景"]

style COARSE fill:#e1f5ff

end

subgraph "锁细化"

FINE["一个大锁 → 多个小锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>减少锁竞争<br/>适合高并发场景"]

style FINE fill:#fff9c4

end

COARSE <-->|"相反的优化方向"| FINEJVM 自动进行锁粗化,但锁细化需要程序员手动设计。 典型的锁细化例子包括:

ConcurrentHashMap的分段锁(JDK 7)/ CAS + synchronized(JDK 8+)LongAdder的分散热点- 读写锁分离(

ReentrantReadWriteLock)

如何控制锁粗化?

1 | |

最佳实践:

- 信任 JVM 的优化:在大多数情况下,JVM 的锁粗化决策是合理的

- 避免过度优化:不要为了"帮助" JVM 而手动粗化锁,这可能适得其反

- 关注热点代码:只有被 JIT 编译的热点代码才会进行锁粗化优化

- 监控锁竞争:使用

jstack、async-profiler等工具监控锁竞争情况,判断是否需要手动调整锁粒度

锁膨胀(Lock Inflation)

本章节完整介绍 synchronized 锁的状态变化机制,包括:偏向锁、轻量级锁、重量级锁的实现原理,以及自旋与阻塞的等待机制优化。这是理解 JVM 锁优化的核心内容。

术语说明:在 JVM 和 HotSpot 源码中,描述偏向锁 -> 轻量级锁 -> 重量级锁这一过程的正式术语是 Lock Inflation(锁膨胀),而非 “Lock Escalation”。后者是数据库领域的术语,指将多个细粒度锁(如行锁)升级为粗粒度锁(如表锁)以减少锁管理开销。中文社区常用的"锁升级"(Lock Upgrade)虽然不够精确,但已被广泛接受。本文采用"锁膨胀"这一更贴近 HotSpot 实现的术语。

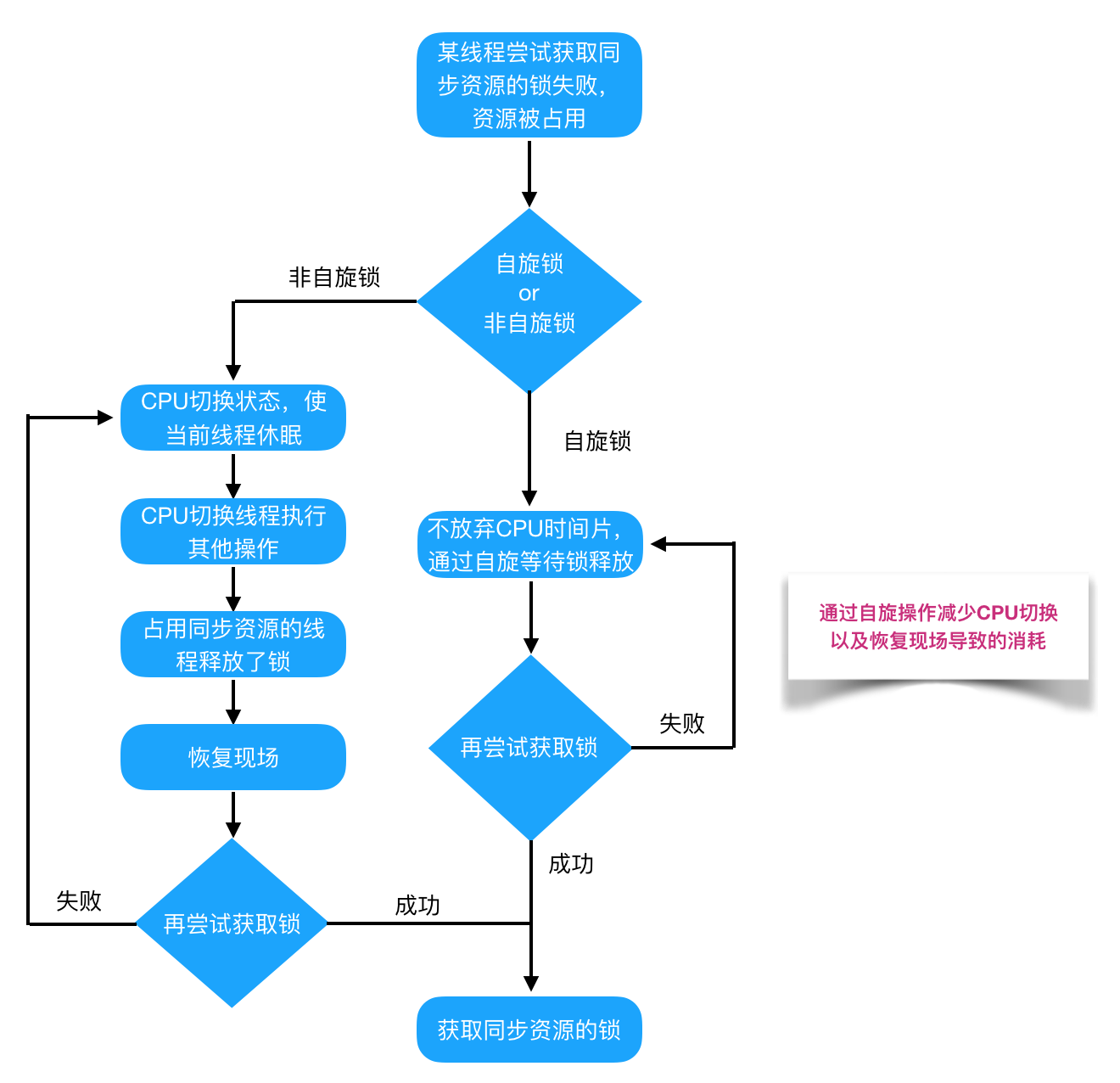

概述:锁状态与等待机制

在深入讨论之前,我们需要先澄清两个常被混淆的概念:

"自旋锁"这个术语在不同语境下有不同含义:

-

狭义的自旋锁(Spinlock):一种独立的锁实现,如 Linux 内核中的

spinlock_t,它完全基于自旋实现,不涉及线程阻塞。这种锁通常用于内核态或中断上下文中,因为这些场景不能进行线程调度。 -

锁的自旋优化(Spin Optimization):在传统阻塞锁的基础上,增加一个自旋阶段。线程获取锁失败后,先自旋一段时间,如果还获取不到再阻塞。这是 JVM 中 synchronized 和 ReentrantLock 采用的策略。

本文讨论的是第二种含义——锁的自旋优化。

关键理解:自旋是等待机制的优化,不是锁实现的优化

graph TB

subgraph "锁的分类维度"

direction TB

subgraph "按锁实现分类"

IMPL["锁实现<br/>━━━━━━━━━━━━━━━━━━━━<br/>偏向锁 / 轻量级锁 / 重量级锁<br/>━━━━━━━━━━━━━━━━━━━━<br/>决定:如何记录锁的持有者<br/>如何管理锁的状态"]

style IMPL fill:#e1f5ff

end

subgraph "按等待机制分类"

WAIT["等待机制<br/>━━━━━━━━━━━━━━━━━━━━<br/>自旋等待 / 阻塞等待<br/>━━━━━━━━━━━━━━━━━━━━<br/>决定:获取锁失败后<br/>线程如何等待"]

style WAIT fill:#fff9c4

end

end

note1["这两个维度是正交的!<br/>偏向锁/轻量级锁/重量级锁 描述的是「锁的实现」<br/>自旋/阻塞 描述的是「等待机制」<br/>不要混为一谈"]

style note1 fill:#ffcdd2英文文献中的术语:

在学术文献和专业书籍中,这两个概念有明确的区分:

| 英文术语 | 中文 | 含义 |

|---|---|---|

| Lock Implementation | 锁实现 | 偏向锁、轻量级锁、重量级锁属于这个范畴 |

| Spinning / Spin-waiting | 自旋等待 | 获取锁失败后,线程忙循环等待 |

| Blocking / Block-waiting | 阻塞等待 | 获取锁失败后,线程被挂起 |

| Spin-then-block | 先自旋后阻塞 | JVM 采用的混合策略 |

《The Art of Multiprocessor Programming》(多处理器编程的艺术)一书中明确指出:

“Spinning is a technique where a thread repeatedly checks a condition instead of blocking. It is orthogonal to the lock implementation itself.”

(自旋是一种线程反复检查条件而不是阻塞的技术。它与锁的实现本身是正交的。)

为什么这个区分很重要?

因为:

- 偏向锁、轻量级锁、重量级锁回答的是"锁的状态如何记录、锁的持有者如何追踪"

- 自旋、阻塞回答的是"获取锁失败后,线程如何等待"

这两个问题是独立的。例如:

- 轻量级锁获取失败后,可以选择自旋等待,也可以直接膨胀为重量级锁然后阻塞

- 重量级锁获取失败后,JVM 也会先自旋一段时间,再进入阻塞

锁状态升级的完整路径:

1 | |

接下来,我们将按照这个升级路径,逐一介绍每种锁状态的实现原理。

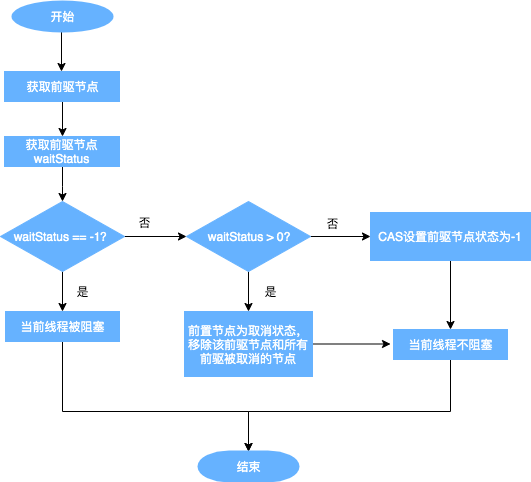

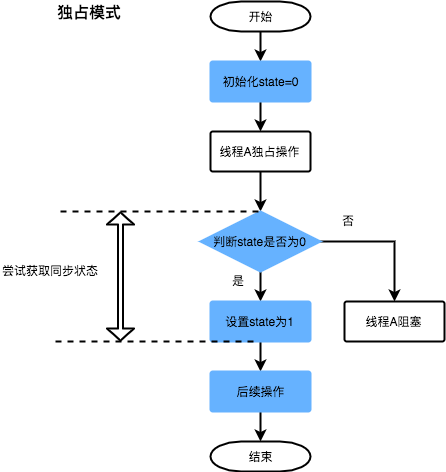

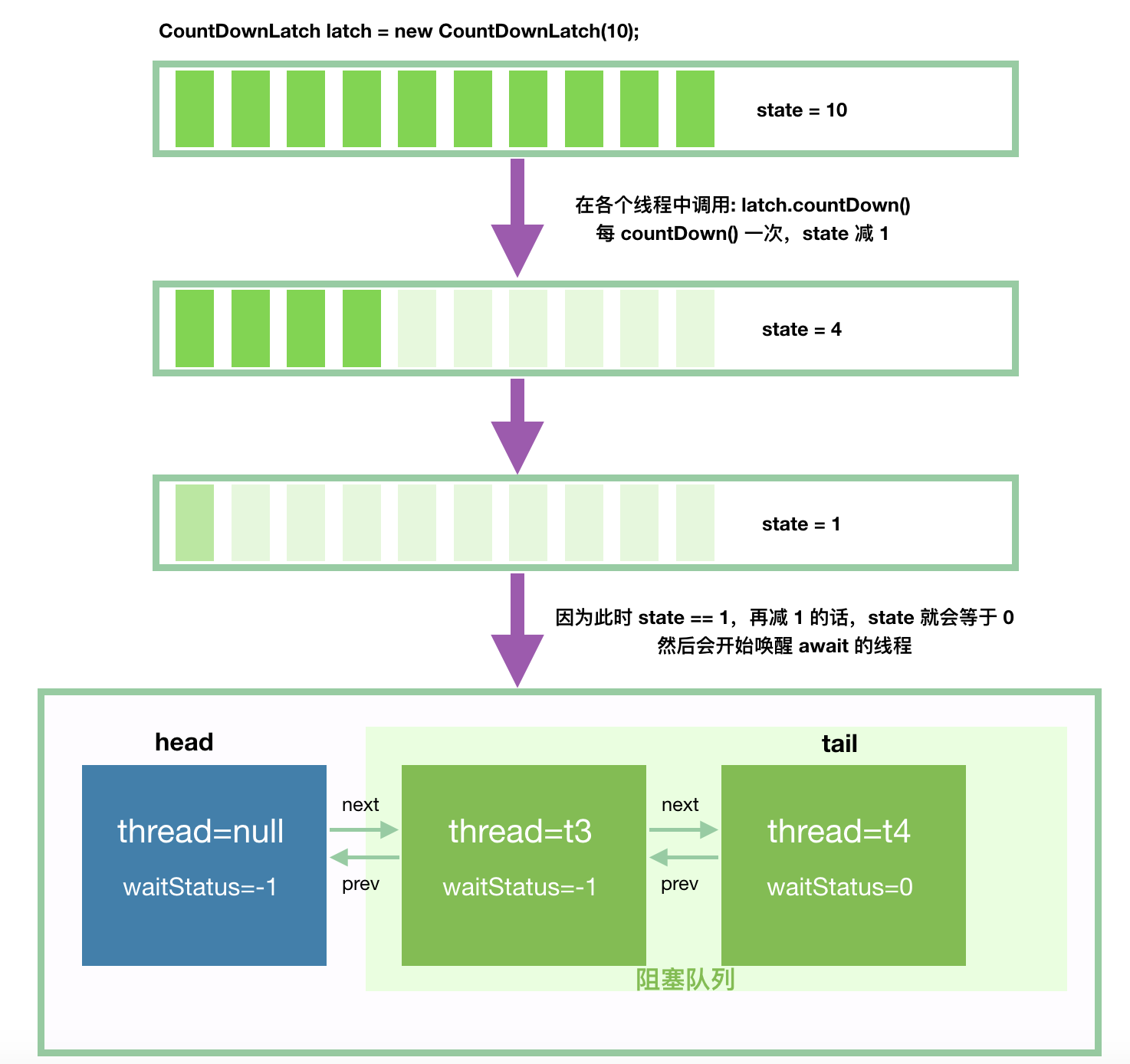

偏向锁(Biased Lock)

偏向锁是 JDK 1.6 中引入的一项锁优化。它的目的是消除数据在无竞争情况下的同步原语,进一步提高程序的运行性能。如果说轻量级锁在无竞争的情况下使用 CAS 操作去消除同步使用的互斥量,偏向锁就是在无竞争的情况下,把整个同步过程都消除掉,连 CAS 都不做了。

偏向锁的本质:一个"写在 Mark Word 里的 volatile threadId"

理解偏向锁最直观的方式是将它类比为一个 volatile 全局变量:

1 | |

偏向锁与 volatile 变量的相似性:

| 对比维度 | volatile threadId 变量 | 偏向锁的 Mark Word |

|---|---|---|

| 存储位置 | 堆中的对象字段 | 对象头的 Mark Word |